"Stell dich vor!"

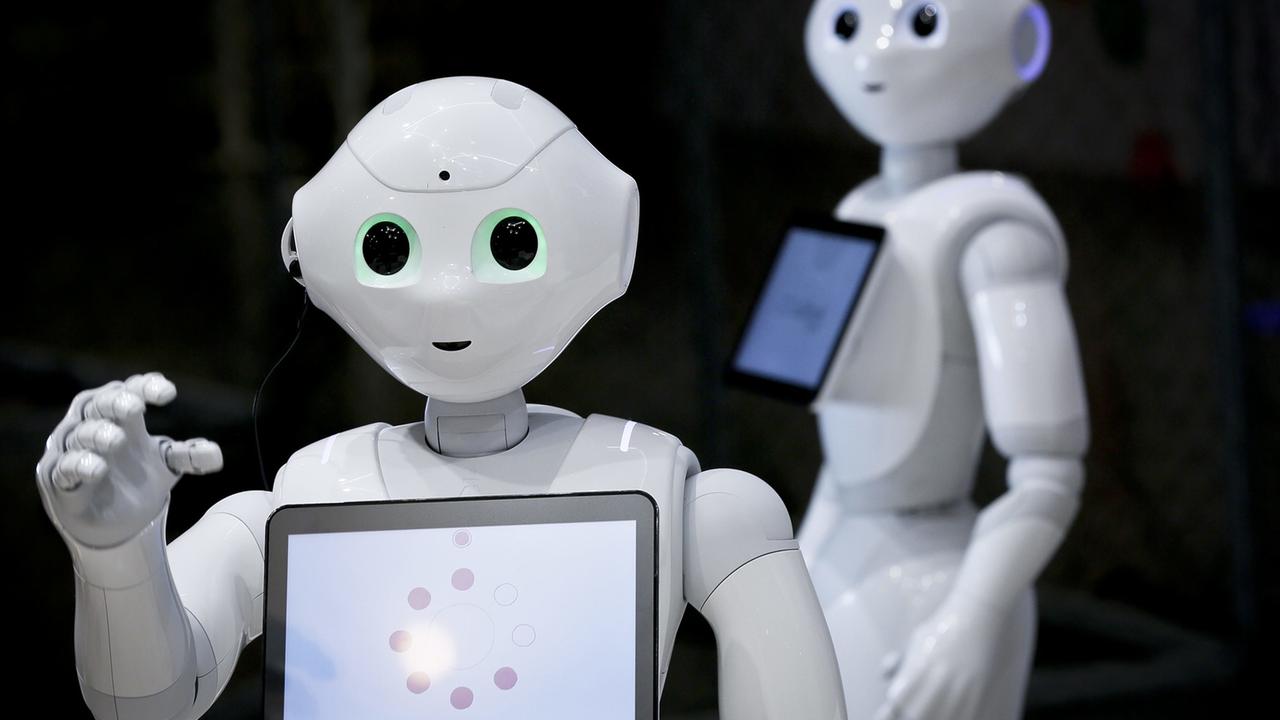

"Mein Name ist Pepper. Ich bin ein humanoider Roboter und bin einen Meter zwanzig groß."

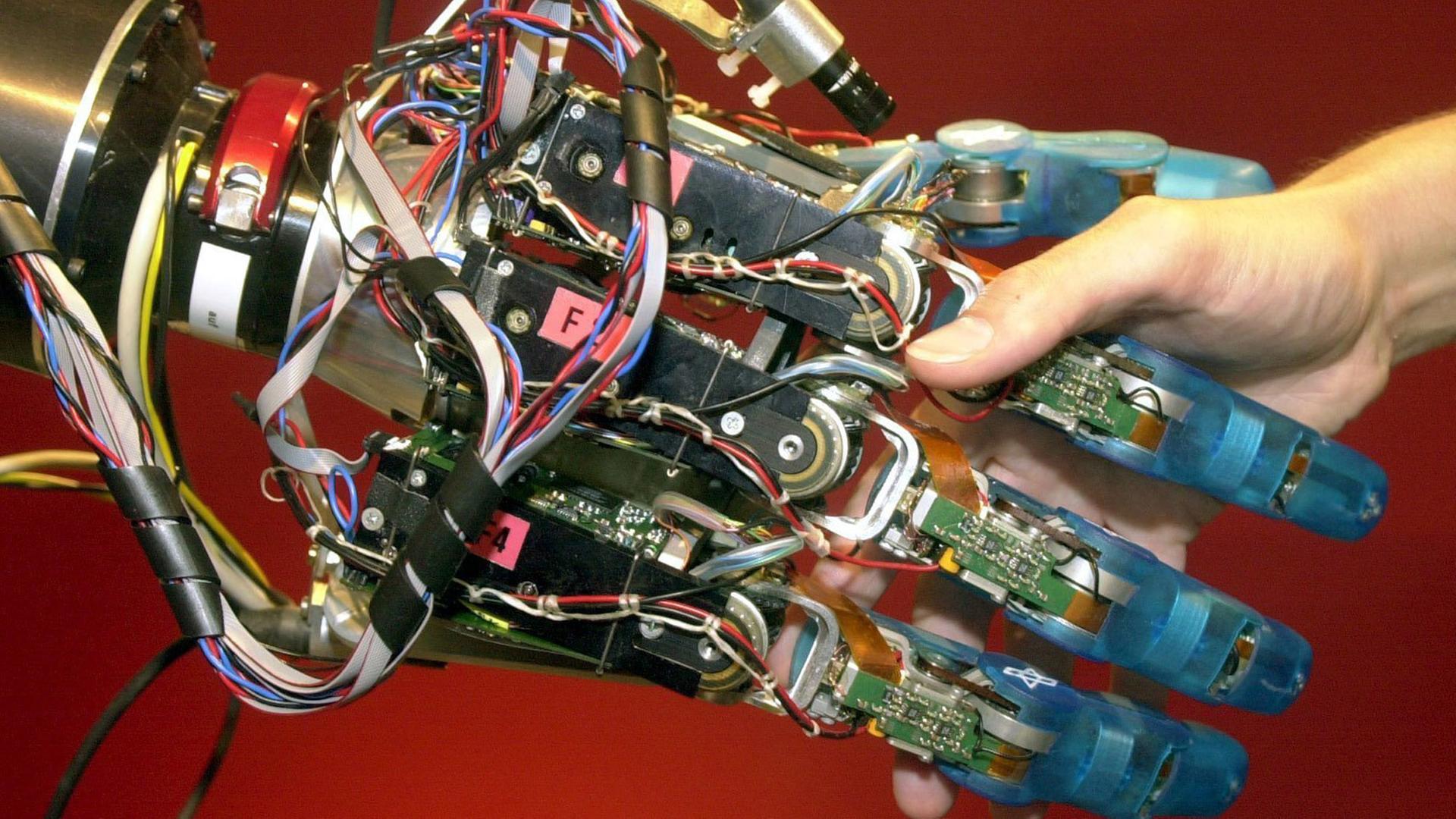

"Kennst du die Robotergesetze?"

"Ja. Das erste Gesetz ist: ein Roboter darf Menschen nicht verletzen oder durch Untätigkeit zulassen, dass einem Menschen Schaden zugefügt wird. Das zweite ist: ein Roboter muss den ihm von einem Menschen gegebenen Befehlen gehorchen – es sei denn, ein solcher Befehl würde mit Regel eins kollidieren. Das dritte ist: ein Roboter muss seine eigene Existenz schützen, solange dieser Schutz nicht mit Regel eins oder zwei kollidiert."

Pepper ist ein niedlicher Roboter mit großen blauen Augen und einem wohlwollenden Lächeln. Er wird heute schon in Restaurants oder Krankenhäusern eingesetzt, erkennt menschliche Emotionen, und soll sogar einen Sinn für Humor haben. Zitiert hat Pepper die Robotergesetze des Schriftstellers Isaac Asimov, wie er sie 1942 in seiner Kurzgeschichte "Runaround” beschrieb.

Wie Mensch und Roboter in Zukunft zusammenleben werden, das beschäftigt Film und Literatur schon lange. In der realen Alltagswelt jedoch, wo Roboter immer mehr zum Einsatz kommen, gibt es noch viele Lücken im Regelwerk, was Recht und Ethik angeht. Susanne Beck ist Professorin für Strafrecht und Rechtsphilosophie an der Leibniz-Universität Hannover. Sie warnt davor, Science-Fiction-Romane zu ernst zu nehmen:

"Ich glaube, es ist nicht sinnvoll, permanent darüber zu diskutieren, dass in 20 Jahren Terminator-Roboter unsere Welt übernehmen. Das ist nicht unser Problem. Sondern unser Problem stellt sich jetzt in den nächsten zwei, drei Jahren, vier Jahren: Wollen wir selbstfahrende Kraftfahrzeuge haben? Wollen wir Roboter im Pflegebereich einsetzen? Solche Dinge, damit müssen wir uns beschäftigen."

Denn die Robotik boomt. Von 2010 bis 2014 wurden jedes Jahr 17 Prozent mehr Roboter verkauft als im Jahr zuvor. Patentanmeldungen im Bereich Robotik haben sich in den letzten zehn Jahren verdreifacht. Auch die Europäische Union will bei diesem Trend ganz vorn dabei sein: Das europäische SPARC Programm ist das weltgrößte zivile Forschungsprogramm für Robotik. Die EU investiert bis 2020 rund 700 Millionen Euro in SPARC, die Privatindustrie soll das Dreifache beisteuern.

EU hat bis jetzt keine umfassenden Robotik-Gesetze

Doch obwohl Forschung und Industrie so stark gefördert werden, hat die Europäische Union bis jetzt keine umfassenden Robotik-Gesetze. Bis heute decken einzelne Richtlinien, beispielsweise für Maschinen oder allgemeine Produktsicherheit, die Robotik nur teilweise ab. Das muss sich ändern, fordert das EU-Parlament.

Im Februar verabschiedete das Europäische Parlament einen Bericht über die zivilrechtlichen Regelungen der Robotik. Der Bericht soll die EU-Kommission dazu bewegen, sich um EU-Gesetze für Robotik und künstliche Intelligenz zu kümmern. Es brauche erkennbare ethische Prinzipien für eine Gesetzgebung, erklärte das Parlament. Nur so könne die EU konkurrenzfähig bleiben, sagt Mady Delvaux, die sozialistische Berichterstatterin.

"Der Bericht sieht eine Ethik-Charta vor, oder einen Verhaltenskodex für die Roboter-Konstrukteure, denn wir wollen Roboter, die zum Wohl der Menschheit eingesetzt werden und die Würde, die Privatsphäre und Freiheit achten."

Dass Robotergesetze nun so dringend gebraucht werden, liegt an der rasanten Entwicklung der künstlichen Intelligenz – kurz KI –, mit der die Roboter einen neuen Grad Eigenständigkeit erlangen.

Künstliche Intelligenz besteht aus zwei Grundelementen: Daten und Algorithmen. Immer größere Datenmengen können von immer leistungsfähigeren Algorithmen ausgewertet werden. So sollen Algorithmen Kreditwürdigkeit einschätzen können, menschliche Emotionen erkennen, oder vorhersehen, wo wahrscheinlich Verbrechen stattfinden werden.

Mit der Grundsatzfrage, ob diese neuen Technologien unsere Gesellschaft verbessern – oder ob sie unsere Freiheit und Würde einschränken, beschäftigt sich die noch junge Disziplin der Roboterethik. Besonders viele Fragen wirft etwa das "Affective Computing” auf. Hier liegt der Forschungsschwerpunkt auf der Interaktion zwischen Mensch und Maschine, also auf Systemen, die menschliche Gefühle erkennen, interpretieren und simulieren können.

Affective Computing wird für die Entwicklung von sozialen Robotern gebraucht. Diese Roboter werden beispielsweise in Hotels eingesetzt, um Gästen Frühstückszeiten oder WLAN-Passwörter mitzuteilen. Zunehmend werden sie aber auch in sensibleren Bereichen, wie der Pflege oder dem Gesundheitswesen, eingesetzt. Pouyan Zarfati ist Mitgründer der Start-up LuxAI und Entwickler des kleinen QT-robots in Luxemburg:

"QT ist eine soziale Roboter-Plattform und hat viele unterschiedliche Anwendungsmöglichkeiten. Die Universität Luxemburg nutzt QT im Rahmen eines emotionalen Fähigkeitstrainings für Kinder mit Autismus. QT erklärt den Kindern, warum Menschen verschiedene Emotionen haben, wie man diese Emotionen erkennen kann, bei sich selbst, aber auch bei anderen, und wie man diese Emotionen kontrollieren kann."

"Wenn man keine Richtlinien hat, schafft man sich eigene"

Jüngere Studien zeigen, dass es für manche Kinder mit Autismus tatsächlich einfacher zu sein scheint, einen Roboter als Kommunikationsbrücke zu nutzen, als mit den unberechenbareren Menschen direkt zu kommunizieren. Entsteht aber dadurch die Gefahr einer emotionalen Bindung zum Roboter? Es sei wichtig, Grenzen beim Einsatz der Roboter zu ziehen, meint die Rechtsexpertin Susanne Beck:

"Ich glaube, eine wichtige Grenze ist, wenn Menschen sich das nicht selbst aussuchen können. Also zum Beispiel Leute, die, sagen wir mal, an Demenz erkrankt sind und auf einmal mit Maschinen interagieren – oder vielleicht sogar getäuscht werden darüber, ob das Maschinen oder Menschen sind. Das fände ich problematisch, weil sie nicht selber entscheiden können, was sie tun wollen. Insgesamt immer dann, wenn es so in Richtung Täuschung geht, also wenn die Maschine bewusst menschlich gestaltet wird, um einen bestimmten Effekt hervorzurufen, dann finde ich es schwierig."

Den Roboter-Konstrukteuren stellen sich beim Programmieren inzwischen ganz konkrete Fragen. Pflegeroboter sollen ältere Menschen begleiten und auch imstande sein, den Patienten zu den richtigen Uhrzeiten Medikamente auszuteilen. Aber: Wie soll ein Roboter nun reagieren, wenn ein Patient sich weigert, seine Medikamente zu nehmen? Leon van der Torre ist Informatik-Professor an der Universität Luxemburg und bedauert, dass bestehende ethische Richtlinien in solchen Fällen nicht sehr hilfreich sind.

"Klassische ethische Theorien beschäftigen sich nicht mit solchen alltäglichen Fragen wie 'soll man die Medikamente geben oder nicht'. Also programmieren die einzelnen Konstrukteure den Roboter so, wie sie es für richtig halten. Wenn man keine Richtlinien zur Verfügung hat, schafft man sich halt eigene Regeln."

Robotern komplexe Entscheidungen zu überlassen, ist problematisch - darüber sind sich Experten einig. Dennoch soll uns die enorm gestiegene Rechenleistung der künstlichen Intelligenz gerade dabei unterstützen, solch komplexe Entscheidungen zu treffen. Die KI schafft Zugang zu Informationen, die zuvor im Chaos der sogenannten "Big Data”, der Massendaten, verborgen blieben. So können Algorithmen beispielsweise soziale Netzwerke systematisch nach Hass-Kommentaren durchsuchen.

Ob Kommentare dann aber gelöscht werden sollten oder nicht, das sollte immer noch ein Mensch entscheiden, meint Christoph Benzmüller, Informatik-Professor an der Freien Universität Berlin:

"Ich denke, dass wir für einen gewissen Zeitraum uns darauf einstellen sollten, dass wir immer noch einen 'man in the loop' haben sollten. Das heißt, dass wir kritische Entscheidungen im ethischen Bereich, aber auch im Bereich von Gesetzen, nicht den Maschinen alleine idealerweise überlassen sollen. Aber natürlich: Um einen 'man in the loop' zu haben, einen Menschen, der letztendlich die Entscheidung verantwortet oder trifft, ist es notwendig, dass die intelligenten Maschinen, die wir entwickeln, in der Lage sind, in eine Interaktion mit dem Menschen zu treten."

"Jetzt politisch Grenzen ziehen"

Wenn jede Entscheidung auf einen Menschen zurückzuführen sei, werde die Frage der Verantwortung vereinfacht. Das löse aber noch nicht das Problem, erklärt Frederike Kaltheuner von der Nichtregierungsorganisation Privacy International.

"Wenn man über die Ethik spricht, ist es auch relevant zu sehen, wie wir durch bestimmte Entscheidungen vorgeprägt werden. Eine Software für die vorhersagende Polizeiarbeit wird natürlich nicht selbst verhaften. Die Polizei verhaftet. Aber wenn ein System so entworfen ist, dass es Informationen als hundertprozentig sicher darstellt, oder Personen als 'zweifellos kriminell', dann kann man sagen, dass diese Software Menschen darauf ausrichtet, bestimmte Entscheidungen zu treffen."

Algorithmen, die Entscheidungsfindungen für den Menschen vorbereiten, sind auch deswegen problematisch, weil sie auch auf persönliche Daten zugreifen. Oft geben Personen ihr Einverständnis für die Nutzung ihrer Daten, ohne zu wissen, wofür diese Daten später genutzt werden.

Der grüne Europapolitiker und Datenschutzexperte Jan Philipp Albrecht erklärt, dass der Datenschutz die Selbstbestimmung des Einzelnen garantieren soll, aber nicht unbedingt Grenzen dafür setzt, welche Daten wie verarbeitet werden können.

"Das heißt, die große Aufgabe ist es, jetzt politisch Grenzen zu ziehen dafür, welche Verarbeitungswege wollen wir eigentlich am Ende nicht. Wollen wir am Ende zum Beispiel, dass aus einem Profil eine Entscheidung getroffen wird, bei der möglicherweise Menschen mit einer bestimmten Krankheit weniger Möglichkeiten als Verbraucher haben als andere. Oder Menschen mit bestimmten Lebensinhalten – was weiß ich – Extremsportler zum Beispiel, dass die anders behandelt werden als andere Menschen – das ist eine Diskussion, die wir jetzt erst führen."

Außerdem können auch Algorithmen irren, wenn sie keinen Zugriff auf komplette Datensets haben - oder wenn die Daten nicht korrekt sind. Selbst-lernende Algorithmen sollen immer aus Daten der Vergangenheit auf die Zukunft schließen. Anders gesagt: Zeigt man einem selbst-lernenden Algorithmus tausend Frauen, wird der Algorithmus in der Lage sein, weitere Frauen als solche zu erkennen.

"Wenn ich mir einen Datensatz aus der Vergangenheit heranziehe in einem Bereich, in dem zum Beispiel gegen gewisse kulturelle Gruppen oder gegen Frauen oder Kinder diskriminiert worden ist, und dann auf der Grundlage dieser Daten meine Mechanismen des maschinellen Lernens trainiere, und da neue Modelle generiere und die dann einsetze für Prognosen oder sogar Entscheidungsfindungen in der Zukunft, dann kann ich sogar diesen Diskriminierungseffekt, der in der Vergangenheit passiert, ist eventuell potenzieren dadurch."

Erklärt Christoph Benzmüller von der Freien Universität Berlin. Um Diskriminierungen überhaupt feststellen zu können, müssen Algorithmen transparent und verständlich sein. Dabei können selbst-lernende Algorithmen so komplex werden, dass ihre Entwickler selbst sie nicht mehr verstehen.

So werben Ethik-Experten für das "Recht auf Erklärung”, einen Transparenz-Mechanismus, der Nutzern erlaubt, die Entscheidung eines Algorithmus nachzuvollziehen.

Algorithmen schwer zu verstehen? Keine Entschuldigung

Sandra Wachter ist Dataethik-Expertin beim Oxford Internet Institute:

"Das Recht auf Erklärung wäre so ein Transparenz-Mechanismus, der Leuten verständlich macht, wie der Algorithmus funktioniert, warum eine Entscheidung wie getroffen wurde, um dadurch Algorithmen haftbar zu machen. Damit man nicht willkürlich Entscheidungen treffen kann. Das Statement 'Algorithmen sind halt schwer zu verstehen' ist keine Entschuldigung. Wenn man sich überlegt, dass Richter Algorithmen benutzen, um zu entscheiden, ob man ins Gefängnis gehen soll!"

Ganz grundsätzlich kritisieren es auch viele Techniker, dass ethische Richtlinien oft erst nach der Entwicklung neuer Technologien entworfen werden. So reguliert sich der Sektor der künstlichen Intelligenz oft noch selbst - das bedauert Robert Sparrow, Ethik-Experte von der Monash Universität in Melbourne, Australien:

"Es ist außergewöhnlich, wie akzeptabel Anarchismus plötzlich wird, wenn man über Konzerne oder Technologie redet. Nicht gewählte Ingenieure verfügen auf einmal über eine enorme Macht über unser tägliches Leben. Wir dürfen die Behauptung, dass sie sich schon selbst regulieren, keinesfalls akzeptieren. Hier gibt es ein enormes demokratisches Defizit."

Robert Sparrow ist Mitglied im Institut für Elektrotechnik- und Informationstechnik-Ingenieure. Die Arbeitsgruppen zu Ethik und Technologie dieses Berufsverbandes gelten weltweit als Referenz. Sie arbeiten derzeit an internationalen Ethik-Richtlinien, die der gesellschaftlichen Meinungsvielfalt Rechnung tragen sollen.

Die demokratische Öffentlichkeit fehle auch in anderen Aspekten der Robotik, meint Robert Sparrow: etwa was die Auswirkungen auf die Arbeitsmärkte angeht. Bis 2019 werden laut der "International Federation of Robotics” mehr als 1,4 Millionen neue Industrie-Roboter in den Fabriken rund um den Globus installiert, weitere Roboter werden im Service- und Pflegebereich eingesetzt werden.

Die Ökonomen sind sich nicht einig darüber, ob die Robotik nun mehr Arbeitsplätze vernichtet, als sie schafft. Konsens besteht jedoch darüber, dass die Arbeitswelt von morgen andere Kompetenzen verlangt als heute. Jochen Leidner, Forschungsdirektor bei Thomson Reuters:

"Was machen die, die nicht programmieren können, die keine Anwälte oder Buchhalter sind - oder was auch immer in der Zukunft noch gebraucht wird? Wenn zum Beispiel jemand jetzt Fahrer ist, und Autofahren, LKW-Fahren wird automatisiert? Womit wird der Fahrer der Zukunft dann sein Geld verdienen? Und wenn wir alle am Strand sitzen, gibt es natürlich noch ein weiteres Problem. Es scheint wünschenswert zu sein, aber der Mensch gewinnt durch seine Arbeit auch Bedeutung für sich selbst und identifiziert sich mit seiner Arbeit. Wenn das verloren geht, dann kommt auch nicht jeder damit zurecht."

Arbeit der Roboter besteuern?

So forderte die EU-Parlamentarierin Mady Delvaux in einer ersten Version ihres Robotik-Berichtes eine Debatte über die Idee des universellen Grundeinkommens, finanziert durch eine moderne Maschinensteuer. Auch andere Führungskräfte der IT-Wirtschaft – etwa Bill Gates – haben sich schon dafür ausgesprochen, die Arbeit der Roboter zu besteuern, um den Verlierern der Automatisierung eine finanzielle Unterstützung bieten zu können.

Das aber wollten die konservative und die liberale Fraktion im EU-Parlament keinesfalls im Robotik-Bericht stehen lassen. Ihr Argument: Eine Robotersteuer würde der europäischen Innovationskraft schaden. Diese Kritik erscheint der Autorin Delvaux absurd.

"Mir vorzuwerfen, der Bericht sei technophob - das fand ich eine sehr starke Unterstellung. Im Gegenteil, wir wollen die europäische Industrie und auch die Forschung unterstützen. Forschung nicht nur darüber, was reine Robotik angeht, sondern auch, welche Konsequenzen diese neue Entwicklung auf den Arbeitsmarkt und auf unser Leben hat. Wie werden wir mithilfe der Roboter zusammen leben?"

Die Politik hat auf diese Entscheidungen großen Einfluss, weil immer mehr öffentliche Gelder in die Robotik-Forschung fließen. Dieser Zusammenhang sei den Menschen jedoch nicht immer so bewusst, meint die Rechtsphilosophin Susanne Beck aus Hannover.

"Robotik wird gerade sehr stark gefördert, weil man weiß, das ist für unsere Wirtschaft gut, das wird Deutschland voranbringen, da können wir wirklich auf den Weltmarkt mitspielen – und das ist sicherlich auch so. Aber in dem Bereich gibt es eben kaum eine Diskussion – 'ist es denn sinnvoll, soviel Geld in die und die Entwicklung zu stecken?'.

Immer aber gibt es die Bedenken, dass die Europäische Union weniger kompetitiv werden könnte, wenn Investitionen in die Grundlagen- und Anwendungsforschung von Bedingungen abhängig gemacht werden. Der Grünen-EU-Parlamentarier Jan Philipp Albrecht ist nicht damit einverstanden.

"Es ist auf jeden Fall eine entscheidende Frage: Worein investieren wir in Europa, vor allen Dingen als Europäische Union, wo viele Gelder im Bereich der Digitalisierung und der Forschung investiert werden. Investieren wir das in Überwachungsforschung oder eben in klassische Silicon Valley-Anwendungen? Kopieren wir das einfach? Oder investieren wir das in Datenschutz-freundliche Technologien, Anonymisierung, in eine Digitalisierung, die gerade auf sichere Standards und auf ethische Standards achtet? Ich glaube, dass das richtig wäre, weil wir da auch einen Marktvorteil weltweit hätten."

Bis Mitte Mai muss die EU-Kommission zum Robotik-Bericht des EU-Parlaments Stellung nehmen: Auch wenn sie sich dafür entscheidet, keine Gesetzesvorschläge zur Künstlichen Intelligenz und Robotik zu machen, muss die Kommission das begründen.

Früher oder später aber wird Brüssel sich mit der Roboterethik auseinandersetzen müssen. Der Druck auch auf die europäischen Institutionen, ethische und demokratische Prinzipien in der digitalen Welt zu erhalten, wird zunehmen.