Manfred Kloiber: Das ist ein Thema, das Betreiber von Rechenzentren schon lange umtreibt: Hardwareunabhängigkeit. Sie wollen frei sein von den Zwängen, die ihnen die hoch spezialisierten Rechner eines einzigen Anbieters auferlegen. Und deshalb machen sie Dampf bei den Anbietern, mehr herstellerunabhängige Systeme zu liefern. Doch mit dem Software-Defined Data Center gehen die Entwickler noch einen Schritt weiter. Denn bei dieser neuen Technologie geht es darum, das Rechenzentrum und seine Leistungen völlig von der Hardware zu lösen. Was steckt dahinter, Peter Welchering?

Peter Welchering: Wir haben es hier mit drei Trends zu tun. Zum einen geht es darum, Rechenzentrumsleistungen für alle Endgeräte, vom Smartphone übers Tablet bis hin zum Arbeitsplatzrechner anzubieten. Daraus folgt zweitens der Trend, zunehmend auf verteilte Rechenzentren zu setzen. Und drittens werden diese Rechenzentren von Management-Software gesteuert und koordiniert. Deshalb wird auch von einem Software-Defined Data Center gesprochen. Die Management-Software legt fest und entscheidet, welche Server eingebunden sind, welche Sicherheitsmechanismen aktiv sind, wie die Speicher aufgebaut und virtualisiert sind, mit welcher Bandbreite die unterschiedlichen Komponenten kommunizieren, über welche Techniken sie quasi zusammengeschaltet werden.

Kloiber: Vom Cloud Computing gehen ausgesprochen starke Impulse für das Software-Defined Data Center aus. Sie verstärken eine Entwicklung im Betrieb von Rechenzentren, die sich lange Zeit nicht durchsetzen konnte, jetzt aber die Data Centers letztlich aus Kostengründen erobert: Verteilte Automatisierungssoftware für die Rechenzentrumssteuerung. Wir haben zusammengefasst, was da gerade passiert.

"Zentrales und verteiltes Rechenzentrum werden auch in Zukunft noch nebeneinander bestehen"

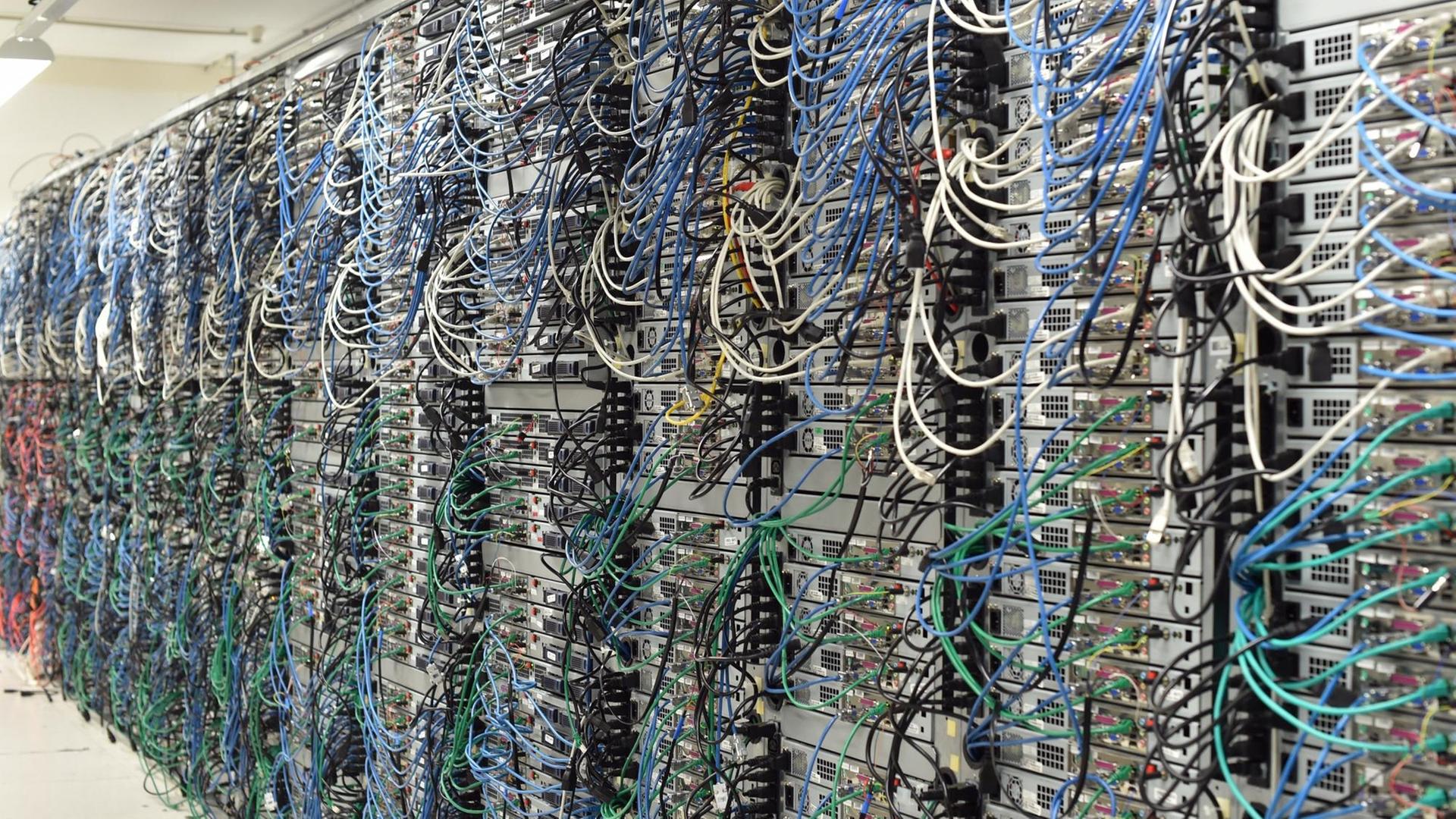

Das vollkommen menschenleere Rechenzentrum wird es zwar vorerst noch nicht geben. Aber besonders viele Menschen werden für den Rechenzentrumsbetrieb nicht mehr gebraucht. Vor allen Dingen Wartungstechniker werden kaum noch eingestellt. Sie werden auf mittelfristige Sicht sogar weitgehend überflüssig. Denn wenn eine Festplatte kaputt geht, muss die nicht mehr von Menschenhand unterstützt mithilfe eines Schraubenziehers ausgebaut werden. Der Wartungsroboter ersetzt die Speichereinheit mit einem Klick. Und so wird es auch in anderen Bereichen des Rechenzentrums aussehen. Das Software-Defined Data Center kommt mit erheblich weniger Personal aus. Mike Yang, Geschäftsführer des Rechenzentrumsausstatters Quanta Computer sieht darin auch eine Reaktion auf den Fachkräftemangel:

"Ich denke, die Provider haben einfach nicht mehr die menschlichen Ressourcen etwa an Ingenieuren und sie haben nicht mehr die Wissenskapazitäten. Deshalb müssen sie die Hardware bündeln, sie müssen sie mit Software bündeln. Und da haben wir es mit vielen Problemen zu tun. Das können wir nur durch Zusammenarbeit mit unseren Softwarepartnern lösen. Der Kunde will eine Cloud-Anwendung haben und das müssen wir dann ganz oben auf unsere Angebotsliste nehmen."

Das Internet der Dinge ist auch im Rechenzentrum angesagt. Und zwar gleich auf zwei Ebenen. Zum einen stellen Industrie-4.0-Anwendungen neue Anforderungen an das Rechenzentrum. Zum anderen müssen die einzelnen Komponenten eines Rechenzentrums, vom Speicher über die Server bis hin zu den Routern auch direkt miteinander kommunizieren. Das verteilte Rechenzentrum ist dabei das Ziel. Aber es setzt sich nur langsam durch. Mike Yang:

"In naher Zukunft werden Sie sehen, wie das verteilte Rechenzentrum aussieht, vergleichbar mit dem restrukturierten zentralen Büro. Das ist ein Trend. Bei den Cloud-Services sehen wir verschiedene Methoden. Das zentrale Rechenzentrum steht da gleichberechtigt neben dem verteilten Rechenzentrum. Die beiden werden auch in der nahen Zukunft noch nebeneinander bestehen."

Auf diesen Trend müssen vor allen Dingen die Telekommunikationsunternehmen schnell reagieren. Denn verteilte Rechenzentren, in denen kritische Industrie-4.0-Anwendungen gefahren werden, müssen mit ausreichender Bandbreite, mit mehrfach redundanter Sicherheit, aber dennoch kostengünstig untereinander verbunden sein. Die Herausforderungen, die Industrie-4.0-Anwendungen hier an die Rechenzentrumsbetreiber und an die Telekommunikationsprovider stellen, dürften nicht unterschätzt werden, meint Howard Wu, Vizepräsident des schwedischen Telekommunikationskonzerns Ericsson:

"Die Maschinen werden mehr Daten hochladen und die müssen im Rechenzentrum verarbeitet werden. Maschinen kommunizieren effektiver, Maschinensprache ist kürzer. Aus der Programmierer-Perspektive bedeutet das kürzere Reaktionszeiten. Aus der Perspektive dessen, der für die Infrastruktur verantwortlich ist, heißt das, die Massen an Datenkommunikation zwischen den Maschinen zu organisieren. Und die Maschinen müssen miteinander reden."

Die zentrale Management-Software zur Steuerung eines Rechenzentrums hat im Software-Defined Data Center deshalb ausgedient. Management- und Automatisierungssoftware werden in die einzelnen Komponenten des Rechenzentrums verlagert und handeln dann die Entscheidungen zur Steuerung des gesamten verteilten Rechenzentrums aus. Das geht nur mit schnellen Algorithmen des maschinellen Lernens, die auf die Abstimmung vieler einzelner Komponenten im verteilten Rechenzentrum hin optimiert wurden.

"Virtualität": Automatisierte Dienstleistungen ohne menschliches Zutun

Wissenschaftsjournalist Peter Welchering im Gespräch mit Manfred Kloiber

Manfred Kloiber: Rechenzentrumsdienstleistungen für Kunden sollen also unabhängig vom Standort des Rechenzentrums, unabhängig von der eingesetzten Hard- und Software erbracht werden. Obendrein soll auch noch kein Mensch mehr eingreifen müssen. Was für Dienstleistungen konkret sind das zum Beispiel, Peter Welchering?

Peter Welchering: Beispielsweise eine IP-Adresse für einen neuen Blog, der aufgesetzt werden soll. Ich will ihn unter der Domain "meinBlog" aufbauen und brauche dafür eine IP-Adresse, mit der die Domain konnektiert wird. Sämtliche Eintragungen vom Registrar bis hin zu Ripe übernimmt dann Verwaltungssoftware als Dienstleistung. Und das nennen die Verfechter des Konzepts eines Software-Defined Data Centers übrigens Virtualität, weil diese Dienstleitung "Vergabe einer IP-Adresse" in verschiedenen verteilten Rechenzentren für mich erledigt wird. Es ist eine virtuelle Dienstleistung, ein virtueller Prozess, weil nicht mehr wichtig ist, welche Komponente diesen Prozess ausführt und wo diese Komponente angesiedelt ist.

Kloiber: Also die Virtualisierung der Rechenleistung geht hier offensichtlich weit über so etwas wie Server-Virtualisierung hinaus.

Welchering: Die geht wesentlich darüber hinaus. Bei der Server-Virtualisierung passieren zwei Dinge. Es wird mit virtuellen Maschinen gearbeitet, bei denen die Software sozusagen die Hardware simuliert. Das hat sich als Sicherheitsanforderung bewährt. Und zweitens wird über eine virtuelle Serververwaltung das an Serverleistung jeweils bereitgestellt, was auch gerade im laufenden Betrieb benötigt wird.

"Zentrale Verwaltungssoftware wird zum Falschenhals"

Kloiber: Aber das passiert doch schon seit einiger Zeit in den Rechenzentren.

Welchering: Was jetzt hinzukommt, ist die verteilte Automatisierung der Prozesse im Rechenzentrum, die dann untereinander Daten austauschen. Bei meinem Web-Provider setze ich meinen Blog auf. Da wird ein Prozess ausgelöst, der Serverkapazität, Speicher und so weiter für meinen Blog bereitstellt. Und dieser Prozess teilt einem anderen Verwaltungsprozess mit: Besorg mir mal schnell eine IP-Adresse dafür. Und so gibt es dann ein Angebot aus der Cloud als virtuelle Dienstleistung. Es ist gleichgültig, welches von den verteilten Data Centers diesen Prozess hostet. Wichtig ist, dass dieser Prozess andere anstößt oder beendet und dass dieser Prozess mit anderen kommuniziert, um dann eine Dienstleistung aus einer Hand bereitstellen zu können.

Kloiber: Wer sorgt dafür, dass alle diese Prozesse auch wirklich die richtigen Daten austauschen?

Welchering: Zurzeit noch überwiegend eine zentrale Verwaltungssoftware. Aber die muss abgelöst werden. Denn die wird zum Flaschenhals. Das heißt aber auch, dass die Intelligenz einer zentralen Software für die Rechenzentrumssteuerung in die einzelnen Komponenten eines Rechenzentrums und somit in die Prozesse verlagert werden muss. Das setzt ganz neue Betriebssystemroutinen, ganz neue Firmware, eine ganz neue Verwaltungsarchitektur voraus. Und da stehen wir eben noch sehr am Anfang eines enormen Veränderungsprozesses.

Die Konfiguration von Speicher, Rechenzeit, Kommunikation wird für jede Rechenzentrumsdienstleistung genau dann erbracht, wenn diese Rechenzentrumsdienstleistung gerade gebraucht wird, in Echtzeit. Und sie muss von den beteiligten Komponenten ausgehandelt werden. Sie wird nicht mehr von einer zentralen Stelle angeordnet. Das macht Rechenzentren flexibler, macht die Prozesse schneller und es spart vor allen Dingen Ressourcen. Also wirklich menschenleer wird das Rechenzentrum der Zukunft nicht sein, aber ganze Berufsgruppen, die heute noch im Rechenzentrum arbeiten, werden dadurch wegfallen.