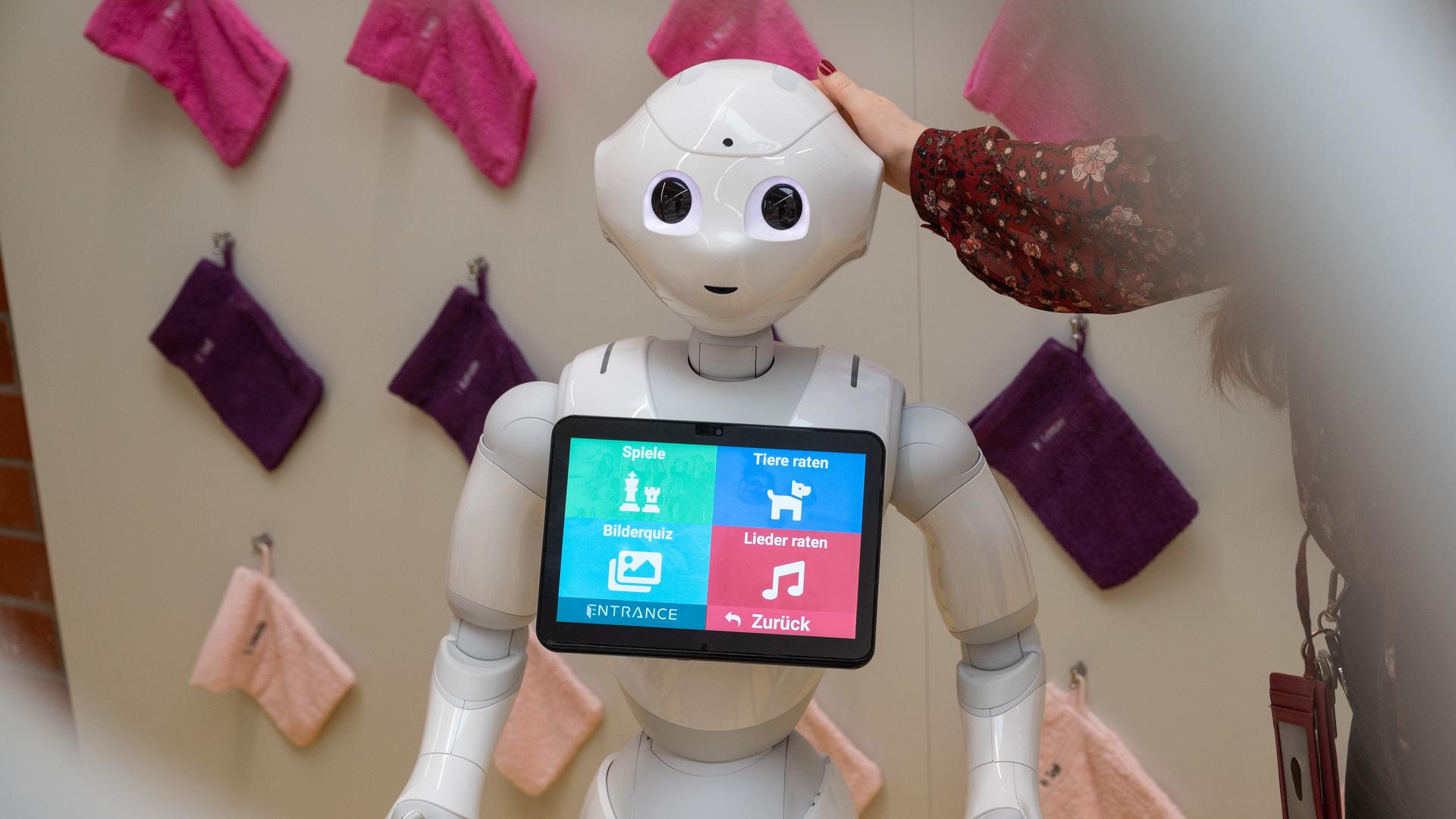

„Hallo ich bin Pepper und helfe in der Altenpflege. Im letzten Jahr habe ich zusammen mit den Pflegern und Senioren bereits einiges gelernt. Zum Beispiel TaiChi und Memory spielen, Fragen beantworten, singen, tanzen, Witze erzählen und so Menschen vielleicht etwas Freude und Anregung bringen.“

Pepper – ein sogenannter humanoider Roboter, der sich hier in einer Fernsehdokumentation des WDR vorstellt. Pepper ist eine bewegliche, etwa 1,20 Meter große Kunststofffigur mit freundlichem Gesicht. Seine künstliche Intelligenz ist darauf trainiert, Menschen und deren Mimik, Gestik und Sprache zu analysieren und darauf zu reagieren. Als Modellprojekt zur Unterstützung von Pflegekräften ist Pepper in einem bayrischen Pflegeheim und in der Berliner Charité im Einsatz.

Wann wird KI für Menschen zur Konkurrenz?

Roboter wie Pepper, die von einer künstlichen Intelligenz, kurz KI, gesteuert werden, werden in naher Zukunft zwar keine Menschen ersetzen, aber eine persönliche Beziehung könne man durchaus mit so einer Maschine aufbauen, sagt Lukas Brand, Theologe am Lehrstuhl für Religionsphilosophie und Wissenschaftstheorie der Ruhr-Universität Bochum:

„Also Roboter werden nicht Homo Sapiens. Aber Roboter werden sich, da bin ich relativ zuversichtlich, das werden wir technisch irgendwann hinbekommen, Roboter werden sich so verhalten wie Menschen. Also wenn wir es schaffen Maschinen zu bauen, die sich von Menschen nicht mehr unterscheiden lassen, dann werden wir in eine ziemliche Krise geraten. Nicht alles, was technisch möglich ist, ist auch moralisch geboten, oder ist sofort auch erlaubt.“

Denn das ist neben dem technischen Fortschritt die zentrale Frage: Was sollte Robotern wie Pepper erlaubt und was sollte verboten sein, was kann, darf und soll eine KI, eine künstliche Intelligenz?

KI, oder englisch AI für „artificial intelligence“, ist längst in unserem Alltag angekommen. Sie wird eingesetzt bei der optimalen Routenplanung in Navigationssystemen, in der Kommunikation mit digitalen Smartphone-Sprachassistenten wie Siri, beim Nutzen von Google, Facebook oder Instagram, wenn auf die Benutzer zugeschnittene Themen angezeigt werden. Aber auch in der medizinischen Krebsdiagnostik, beim Sichten von Bewerbungen, bei der Bewilligung von Krediten, bei der Gesichtserkennung am Flughafen oder als Industrie- oder Staubsaugerroboter kommt KI zum Einsatz. Genauso beim Social Scoring in China, bei dem das Sozialverhalten der Menschen überwacht und nach Punkten beurteilt wird, oder in der Forschung zu autonomen Waffen.

Kaum spezifische Regulierung von künstlicher Intelligenz

All das muss reguliert werden, denn der Einsatz von KI ist nicht nur nützlich oder zeitsparend, sondern mitunter auch gefährlich. Dabei sei die jeweilige Anwendung entscheidend, meint der KI-Forscher und Informatik-Professor Christoph Benzmüller von der FU Berlin.

„Wenn ich jetzt eine KI Firma bin, die sich darauf spezialisiert im Internet vorzuschlagen, was der nächste schöne Videoclip ist, den ich mir anschauen sollte, ist das nicht komplett harmlos, aber es ist sozusagen keine Anwendung, die in irgendeiner Weise da heranreichen würde, was wir sozusagen mit Autonomie in Waffensystemen diskutieren.“

Zurzeit wird der Einsatz künstlicher Intelligenz kaum reguliert, sagt der auf Rechtsfragen rund um die KI spezialisierte Jura-Professor Christian Heinze von der Universität Heidelberg:

„Stattdessen greifen aktuell je nach Produkt oder Dienstleistung sektorspezifische Regeln. Also für Medizinprodukte die Regeln für Medizinprodukte, für Finanzdienstleistungen die über Finanzdienstleistungen. Und ergänzend gelten allgemeine Regeln, die immer gelten, zum Beispiel das Bürgerliche Gesetzbuch oder Strafgesetzbuch über die Haftung und vor allem das Datenschutzrecht zum Umgang mit personenbezogenen Daten. Man kann sagen, es existiert bisher keine oder kaum spezifische Regulierung für Systeme der künstlichen Intelligenz. Das hängt mit verschiedenen Gründen zusammen, zum Teil mit ihrer Innovativität, zum anderen aber auch mit der gar nicht einfach zu entscheidenden Frage, was künstliche Intelligenz ist.

Was genau ist künstliche Intelligenz?

Laut den Ergebnissen einer repräsentativen Umfrage des TÜV-Verbandes kennen zwar fast alle Verbraucher den Begriff künstliche Intelligenz, aber kaum jeder zweite weiß, was damit eigentlich gemeint ist.

Das wiederum sei aber hilfreich für Verbraucher und Unternehmen, um Risiken und Gefahren der KI besser abschätzen zu können, sagt Frederike Kaltheuner. Sie leitet den European AI Fund. Mehre Stiftungen haben ihn ins Leben gerufen, um der Zivilgesellschaft in der KI-Debatte Gehör zu verschaffen. Denn KI sei mehr als einfach nur Digitalisierung.

„Da geht es um die Lösung von Problemen, die traditionell nur Menschen lösen können. Ein ganz simples Beispiel ist das Erkennen von Objekten. KI weiß nicht, was es erkennt, es erkennt nur Muster. Man trainiert einen Datensatz und man labelt diese Daten. Man sagt, das ist ein Muffin, das ist ein Chihuahua. Hier sind Bilder, das ist kein Muffin, hier sind Bilder, das ist ein Muffin. Was wir da eigentlich machen, ist KI trainieren. Das was wir als KI bezeichnen ist meistens maschinelles Lernen.“

Maschinen in moralischen Dilemmas

Und das birgt Risiken. Ein Beispiel:

Auf dem Parkplatz vor der Technischen Universität Berlin steht ein weiß-grüner VW Tiguan. Das Auto gehört zu einem Modellprojekt, in dem selbstfahrende Fahrzeuge erprobt werden, erklärt Mitarbeiter Marc Augusto vom DAI Labor, das zur Universität gehört und zur künstlichen Intelligenz forscht.

„Sie sehen hier unser allererstes Versuchsfahrzeug. Sie sehen einerseits hier auf dem Fahrzeugrack sieben Kameras, das sind die kleinen schwarzen Kameras hier. Wir haben 3D-Lidare auf dem Dach installiert, die erzeugen eine Funkwolke drumherum und damit kann das Fahrzeug dann erkennen, was man sieht.“

Aber da die KI im Auto nicht weiß, was sie sieht, wenn sie auf der Straße unterwegs ist, muss sie lernen, die Dinge zu erkennen und die richtigen Schlüsse zu ziehen, sagt der wissenschaftliche Mitarbeiter Lukas Radke:

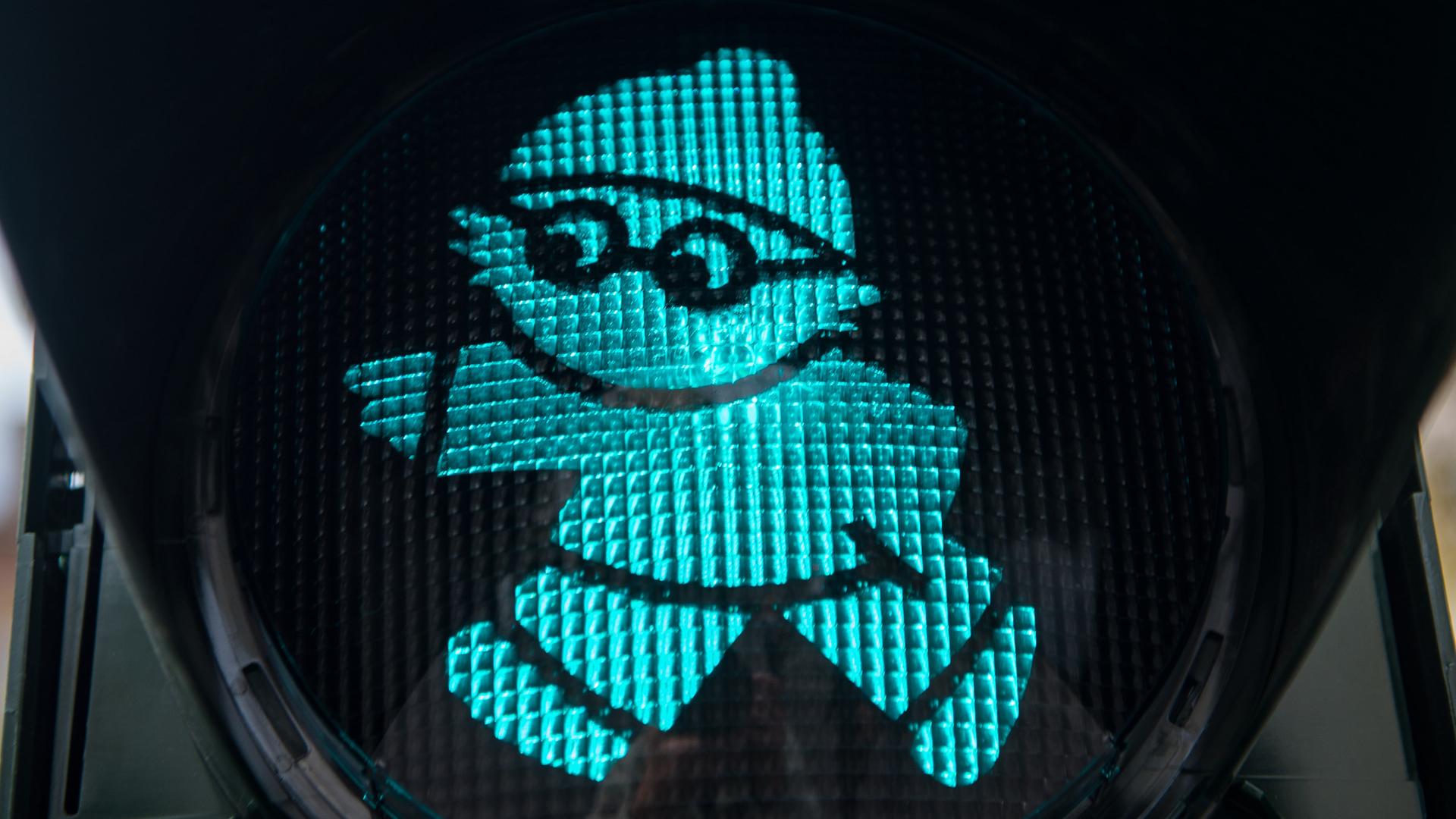

„Wenn man dann zum Beispiel sieht, das ist ein grüner, kreisförmiger Bereich und darum herum ist ein großer schwarzer Block, dann könnte man das zum Beispiel erkennen, dass das eine Ampel sein könnte, das könnte er zum Beispiel lernen und dann lernt er das selber, indem er eben mit der Zeit erkennt, in dem man ihm immer sagt, das ist eine Ampel und dann versucht er eben was ähnliches zu finden.“

Problematisch wird es, wenn gelernt wurde, was Ampeln, Fahrräder oder Kinder sind, und auf einmal unbekannte Objekte wie eine Pferdekutsche des Weges kommen. Oder wenn ein Unfall nicht zu verhindern ist und die KI in einer sogenannten Dilemmasituation entscheiden soll, ob lieber das Kind oder die Oma umgefahren werden soll.

Mehr zum Thema:

- Für das Handwerk bleiben echte Menschen unentbehrlich

- Wenn Künstliche Intelligenz das Forum moderiert

- Künstliche Intelligenz im Unterricht

- Wie Algorithmen die geostrategische Lage verändern

- Deepfakes: Wenn Künstliche Intelligenz Geschichte, Stars und Präsidenten fälscht

- Philosoph: „Wir haben keine seriösen Experten für angewandte Ethik der KI“

Die künstliche Intelligenz würde sich dann nach den Entscheidungen richten, die bisher von Menschen in vergleichbaren Situationen getroffen wurden – unabhängig davon, ob die gut oder schlecht, richtig oder falsch waren.

Denn: KI hat keine eigene Moral, sondern kann menschliche Moral nur simulieren, sagt Theologe Lukas Brand von der Ruhr-Universität Bochum, der sich in seiner Magisterarbeit damit beschäftigt hat, ob Maschinen Moral lernen können.

Die FDP-Politikerin Daniela Kluckert, Parlamentarische Staatssekretärin beim Bundesminister für Digitales und Verkehr, möchte die Entwicklung der Technologie in Deutschland trotzdem vorantreiben. Man könne von einer künstlichen Intelligenz nicht verlangen, besser oder klüger zu sein als der Mensch:

„Das ist einfach eine Überfrachtung der Technologie mit ethischen Fragestellungen, die wir selbst nicht beantworten können.“

China und die USA führen sind führend

2020 hat die Bundesregierung ihre 2018 beschlossene Strategie künstliche Intelligenz fortgeschrieben. Dafür wurden die finanziellen Mittel bis 2025 von drei auf fünf Milliarden Euro angehoben, um die KI-Entwicklung in Deutschland an die Weltspitze zu bringen und dabei Rahmenbedingungen vorzugeben. Gefördert werden unter anderem die Forschung, der Einsatz von KI in Unternehmen, die Ausbildung von KI-Fachkräften.

Aber bis zur Weltspitze ist es ein langer Weg. Führend in der Entwicklung und Anwendung von KI sind derzeit die USA und China. In den USA gibt es autonome Fahrzeuge auf ausgewählten Strecken in einzelnen Bundesstaaten. In Shenzen in China sind Autos ohne Fahrer am Steuer bereits im Regelbetrieb. In Deutschland gibt es über 40 Pilotprojekte, wie das der TU Berlin. Auf ungeteilte Zustimmung in der Bevölkerung treffen solche Ideen nicht.

Diskriminierung durch Maschinen?

Zwar sei das Misstrauen gegenüber künstlicher Intelligenz laut der Umfrage des TÜV in den vergangenen Jahren deutlich geschwunden, aber immer noch hätten fast zwei Drittel der Befragten Angst, dass KI-Systeme bei sicherheitskritischen Anwendungen Fehler machen oder Entscheidungen treffen, die die Betroffenen nicht gut finden.

Joachim Bühler, Präsidiumsmitglied des TÜV-Verbandes, fordert deshalb eine Art Prüfzeichen für einen verantwortungsvollen Einsatz von KI – zum Beispiel wenn sie elementare Grundrechte wie die Gleichbehandlung gefährde. Denn, so Bühler, bereits heute entscheide KI zum Teil darüber, wer bei Versicherungen welchen Tarif, wer einen Kredit oder einen bestimmten Job bekommt:

„Und da kam es bereits vor, dass manche Menschen mit spezieller Hautfarbe oder auch einem bestimmten Geschlecht aussortiert worden sind, weil die KI angenommen hat, dass sich ganz bestimmte Bewerber mit einem Geschlecht besser eigenen würden und das stellt eine Diskriminierungsform dar.“

Mitunter sei das noch nicht einmal Absicht, sagt der Theologe Lukas Brand von der Universität Bochum. Unbeabsichtigte Risiken und Nebenwirkungen entstehen durch die Auswahl der Daten, mit denen die KI trainiert wird und dadurch, dass manchmal gar nicht klar ist, was im Innern einer KI eigentlich ablaufe:

„Maschinen lernen entweder aus vielen Erfahrungsdaten oder man gibt ihnen eine bestimmte Zielvorgabe und dann machen sie so trial and error. Die versuchen, was funktioniert, um diese Zielvorgabe zu erreichen und dann lernt die Maschine nach welchen Regeln sie sich verhalten muss, damit der Input zu dem Output passt.“

Die KI erkläre sich nicht selbst, so Brand. Oft sei unklar, warum eine Maschine diese Entscheidung getroffen hat und keine andere.

Politische Einflussnahme durch KI?

Nun ist es vielleicht unerheblich, ob ein Navigations-Gerät mithilfe von KI diesen oder einen anderen Weg zum Ziel findet. Aber wenn künstliche Intelligenz etwa eingesetzt wird, um zu entscheiden, wer bei Facebook oder Instagram welche Beiträge angezeigt bekommt, dann sei sogar die Demokratie gefährdet, meint Joachim Bühler vom TÜV:

„Wir haben eine große Debatte über die sogenannten Filterblasen. Das heißt eine künstliche Intelligenz registriert, was ich mir in sozialen Netzwerken anschaue, welche Beiträge ich mir besonders gerne anschaue und die künstliche Intelligenz reagiert darauf und zeigt mir in Zukunft dann auch bevorzugt Beiträge an, die meinen Geschmack oder meine politische Meinung bestärken. Man radikalisiert sich quasi im Internet und künstliche Intelligenz kann da einen Beitrag zu leisten, diese Tendenzen eben zu verstärken.

Und genau das passiert immer wieder – zumindest nach Ansicht von Algorithmwatch.

Das ist eine gemeinnützige Nichtregierungsorganisation, die Prozesse erforschen und diskutieren möchte, bei denen Algorithmen zur Entscheidungsfindung eingesetzt werden. Vor der letzten Bundestagswahl hat die Organisation dazu Daten von Nutzern sozialer Netzwerke wie Facebook ausgewertet, die diese freiwillig zur Verfügung gestellt haben, erklärt Matthias Spielkamp, Geschäftsführer von Algorithmwatch:

„Und wenn man dann auswertet, was wir da gesammelt haben, dann stellt man fest, dass Inhalte der AfD im Durchschnitt immer einen Platz höher angezeigt wurden in der Timeline, als Inhalte von anderen politischen Parteien. Und jetzt ist natürlich die spannende Frage, warum ist das der Fall? Hat Facebook ein Interesse daran?

Das wohl eher nicht, meint Spielkamp. Facebook habe aber durchaus ein Interesse, dass die Leute sich lange auf der Plattform aufhalten:

„Und dann könnte es sein, dass dieser Algorithmus, also dieses System zu Vorschlagen der Inhalte quasi gelernt hat aus der Vergangenheit, dass Inhalte der AfD besonders dazu beitragen, dass Leute damit interagieren. Die einen, weil sie es toll finden, die anderen, weil sie sich darüber aufregen, ja, warum wissen wir nicht.“

Die Plattformbetreiber könnten und müssten wenn so etwas passiert den Algorithmus schnell entsprechend anpassen, fordert Spielkamp:

„Die hätten durchaus die Möglichkeit da einzugreifen und könnten dann feststellen, oh hoppla, unser System hat sich dahingehend optimiert, dass jetzt immer Beiträge der AfD höher angezeigt werden als von anderen Parteien, finden wir das eigentlich richtig? Und wenn wir das nicht richtig finden, dann sollten wir da mal an ein paar Stellschrauben drehen und dafür sorgen, dass sich das ändert.“

Algorithmwatch fordert Regulierung

Und weil das selten passiert, müssten die Plattformbetreiber durch Gesetze und Regelungen zu Änderungen an ihren Algorithmen verpflichtet werden, so Spielkamp.

Immerhin wird eine europaweite Regelung für den Einsatz künstlicher Intelligenz derzeit diskutiert, aber vermutlich nicht vor 2023 in Kraft treten. „Europa soll das globale Zentrum für vertrauenswürdige künstliche Intelligenz werden.“ – so das Ziel der Europäischen Kommission im Entwurf einer KI-Verordnung vom April 2021.

Diese sieht eine risikobasierte Regelung von KI-Systemen vor. Unterschieden wird in geringes, hohes und inakzeptables Risiko, erklärt der Jurist und KI-Experte Christian Heinze von der Universität Heidelberg.

Eher harmlose Anwendungen wie ein Navi, ein Staubsauger oder Übersetzungsprogramme blieben vorerst weitgehend unreguliert, Systeme mit inakzeptablem Risiko, wie etwa die Bewertung des Sozialverhaltens durch den Staat oder die unterschwellige Beeinflussung von Verbrauchern, sollen laut dem Verordnungs-Entwurf komplett verboten werden. Und:

„Dann gibt es Hochrisikosysteme, die relativ strengen Regelungen unterworfen werden sollen, wo man dann Datenqualität sich anschauen muss, die Dokumentation sicherstellen muss, menschliche Aufsicht sicherstellen muss und eine Expost-Überwachung. Diese Systeme sind vor allem Systeme, die sich auf den Schutz von Gesundheit, Sicherheit und Grundrechten beziehen. Und dann gibt es Transparenzpflichten, die geschaffen werden, dass ich mit einem KI-System agiere und nicht mit einem Menschen, dass ich sagen kann, ich will mit so einem System nicht agieren und wer das einsetzt, mit dem mache ich keinen Vertrag.“

KI als neutrale Instanz?

Oder Menschen stimmen dem Einsatz der KI bewusst zu, meint die FDP-Abgeordnete Daniela Kluckert, Staatssekretärin im Bundesministerium für Digitales und Verkehr:

„Vielleicht ist es ja auch irgendwann so, dass wir sagen, bitte das soll jetzt kein Mensch bearbeiten, gerade in Bezug auf den Staat, bitte das soll jetzt die KI entscheiden. KI kann ja auch gerechter sein, als der Mensch das ist.“

Bei der Bearbeitung von Bauanträgen oder Bafög-Bescheiden etwa sei die KI außerdem deutlich schneller und unabhängiger als der Mensch.

Weil die KI in so vielen Lebensbereichen bereits im Einsatz sei, gebe es ohnehin kein Zurück mehr, meint Kluckert:

„Wir werden uns nicht dagegen wehren können. Das was wir tun können, ist die Regeln, die die künstliche Intelligenz hat, mitzubestimmen und Menschen zu sensibilisieren damit umzugehen mit künstlicher Intelligenz. Was wir nicht können, ist sie verbieten.“

Kritik an geplanter EU-KI-Verordnung

Die neue EU-KI-Verordnung soll deswegen die Transparenz der Systeme sicherstellen, das heißt, dass öffentlich gemacht wird, wie der Algorithmus darin funktioniert.

Aber es gibt auch Kritik am Entwurf der europäischen KI-Verordnung.

Frederike Kaltheuner vom European AI Fund möchte vor allem die Kategorie inakzeptables Risiko erweitern. Dabei hat sie mögliche KI-Anwendungen im Blick, die Menschen anhand von Gesichtserkennung und Äußerlichkeiten klassifizieren, um sie dann zum Beispiel als homosexuell, intelligent oder humorvoll einzuordnen. Dass das nicht funktioniert, sei in Studien vielfach belegt:

Außerdem werde jeglicher militärische Einsatz im Entwurf der KI-Verordnung nicht thematisiert, kritisiert der Informatik-Professor Christoph Benzmüller von der FU Berlin. Viele Länder hätten sich bereits für eine Ächtung autonomer Waffensysteme starkgemacht, nicht aber Deutschland, sagt Benzmüller, und fordert, über die Vereinten Nationen ein Regelwerk zu installieren. Autonome Waffen sind etwa Raketen oder Drohnen, bei denen eine künstliche Intelligenz und nicht mehr der Mensch Ziele auswählt und möglicherweise attackiert. Außerdem sollte, so Benzmüller, das maschinelle Lernen eine Grenze haben. Wenn es um Leib und Leben geht, müsse ein System eben so programmiert werden, dass es sich an Recht und Gesetz orientiert:

„Wir brauchen glaube ich auch für KI-Systeme eine solche Vorgabe von Grenzen und Regeln, die nicht überschritten werden können und die nicht sozusagen erlernt werden oder trainiert werden. Also ich weiß, das KI-System wird diese Regeln niemals brechen.“

Die Europäische Kommission empfiehlt in ihrer Verordnung jedenfalls eine strenge menschliche Aufsicht auf allen Stufen des Entwicklungsprozesses einer KI.

Und damit sei auch klar, dass niemals die künstliche Intelligenz für ihr Handeln und ihren Einfluss auf Menschen verantwortlich gemacht werden könne, sagt Matthias Spielkamp von Algorithmwatch. Das gilt wenn Roboter Pepper Senioren zum Lachen bringt, wenn mit einer autonomen Drohne Menschen getötet werden, wenn das Navi den schnellsten Weg findet und auch wenn Instagram oder Facebook polarisierende politische Beiträge bevorzugt anzeigen:

„Wir müssen uns immer vor Augen führen, die KI hat keine Absichten. Die hat keine Ziele, die hat keinen freien Willen und keine Autonomie. Aber zu sagen, die KI war schuld ist einfach immer nur eine billige Ausrede.“

![Hunderte von Helfern versuchen am 3.6.1998 im Wrack des verunglückten ICE 884 bei Eschede in der Nähe von Celle, Opfer des Zugunglücks zu bergen. Der Intercity-Express "Wilhelm Conrad Röntgen" von München nach Hamburg war mit etwa Tempo 200 gegen eine Brücke geprallt, die dabei zerfetzt wurde. Die Zahl der Todesopfer könnte auf weit über 100 steigen. Diese Schätzung nannte die Einsatzleitung der Rettungskräfte am Abend im Gespräch mit Bundesverkehrsminister Wissmann. Möglicherweise sind unter den noch nicht geborgenen Toten auch Kinder aus zwei Schulklassen. Rund 300 Menschen wurden verletzt, viele von ihnen schwer. Es handelt sich um das schwerste Zugunglück in Deutschland seit 20 Jahren. [dpabilderarchiv] Hunderte von Helfern versuchen am 3.6.1998 im Wrack des verunglückten ICE 884 bei Eschede in der Nähe von Celle, Opfer des Zugunglücks zu bergen. Der Intercity-Express "Wilhelm Conrad Röntgen" von München nach Hamburg war mit etwa Tempo 200 gegen eine Brücke geprallt, die dabei zerfetzt wurde. Die Zahl der Todesopfer könnte auf weit über 100 steigen. Diese Schätzung nannte die Einsatzleitung der Rettungskräfte am Abend im Gespräch mit Bundesverkehrsminister Wissmann. Möglicherweise sind unter den noch nicht geborgenen Toten auch Kinder aus zwei Schulklassen. Rund 300 Menschen wurden verletzt, viele von ihnen schwer. Es handelt sich um das schwerste Zugunglück in Deutschland seit 20 Jahren. [dpabilderarchiv]](https://bilder.deutschlandfunk.de/7b/1c/99/87/7b1c9987-85ad-48de-a9ef-d7cc27234184/eschede-ice-zugunglueck-100-1920x1080.jpg)