Ralf Krauter: In der aktuellen Ausgabe des Fachmagazins Science fordern Neurowissenschaftler der Universität Tübingen gemeinsam mit Kollegen, ethische Richtlinien für den Einsatz von Neuroprothesen zu entwickeln. Also für Prothesen, die über einen direkten Draht zum Gehirn gesteuert werden: Über ein Brain-Computer-Interface, das Hirnströme erfasst und analysiert. Für medizinische Zwecke ist diese Technologie zwar extrem hilfreich. Aber es gibt eben auch jede Menge offene Fragen in punkto Betriebssicherheit, Haftung, Privatsphäre und Datenschutz beim Einsatz solcher Neuroprothesen. Ich wollte von dem Neurowissenschaftler Dr. Surjo Soekadar, der an der Universitätsklinik Tübingen Patienten mit Neuroprothesen versorgt und einer der Autoren des Aufrufs in Science ist, wissen: Welche technischen Hilfsmittel haben er und seine Kollegen im Sinn, wenn Sie jetzt für verbindliche ethische Standards plädieren?

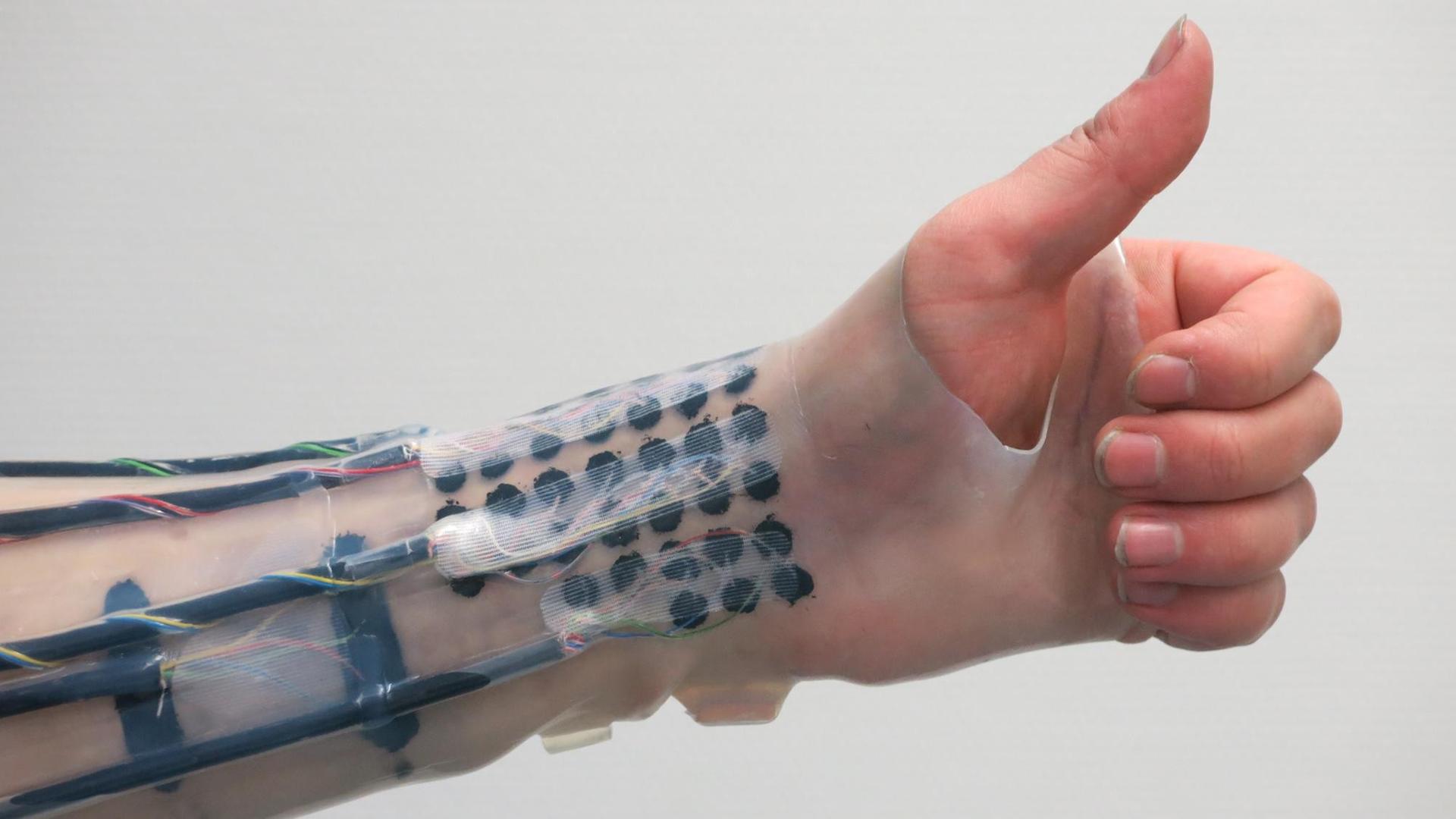

Surjo Soekadar: Also es ist so, dass der technische Fortschritt in den letzten Jahren dazu geführt hat, dass sogenannte Gehirn-Computer-Schnittstellen oder auch Gehirn-Maschine-Schnittstellen – das sind Systeme, die Gehirnaktivität in Steuersignale von externen Geräten, aber auch Computern übersetzen können –, dass solche Systeme auch im Alltag mittlerweile eingesetzt werden können und zwar ganz konkret: zum Beispiel von gelähmten Menschen, die über eine solche Gehirn-Computer-Schnittstelle einen Roboter steuern, der ihnen hilft zu essen oder zu trinken zum Beispiel. Letztlich muss man erst mal sagen, dass natürlich diese Technologie ein Segen ist für vor allem teilweise querschnittsgelähmte Patienten, die eben nicht mehr in der Lage sind, selbstständig zu essen oder zu trinken. Aber der Einsatz von solchen hirngesteuerten Geräten im Alltag ist mit zahlreichen ethischen, aber auch rechtlichen und gesellschaftlichen Fragen verbunden, und letztlich geht es in erster Linie um den Schutz der Anwender – also da geht es zum Beispiel um haftungsrechtliche Fragen – als auch um den Schutz von Dritten, das heißt zum Beispiel, wenn es um die Sicherheit und Zuverlässigkeit von solchen Systemen im Alltag geht.

"Systeme sind nicht immer zu 100 Prozent zuverlässig"

Krauter: Nehmen wir mal als konkretes Beispiel das, was Sie schon genannt haben, also eine Handprothese, die zum Beispiel ein Gelähmter mit zu einem Brain-Computer-Interface dann steuert, stellt sich zum Beispiel die Frage, was würde denn passieren, wenn der Gelähmte mit dieser Hand versehentlich jemand anderes verletzen würde. Wer wäre denn dann haftbar?

Soekadar: Das ist genau die wichtige entscheidende Frage, denn die Systeme, die im Moment bei uns in den Laboratorien entwickelt wurden, teilweise auch mit implantierbaren Elektroden, diese Systeme sind nicht immer zu 100 Prozent zuverlässig. Das heißt, das Auslesen und Interpretieren dieser Hirnaktivität, vor allem im Alltag, wo viele Störungen auftreten können – man denke da zum Beispiel an irgendwelche Handys oder andere elektromagnetische Störquellen –, wenn man das jetzt im Alltag einsetzt, kann es natürlich sein, dass die Hirnaktivität nicht korrekt übersetzt wird. Und das hieße dann, dass zum Beispiel, wenn Sie jetzt ein Baby in der Hand halten mit so einem Roboter oder irgendetwas anderes Sensibles, dass da ein Schaden entstehen kann und genau da dann die Frage sich stellt, wer ist denn dafür haftbar.

Krauter: Man könnte ja im Nachhinein wahrscheinlich auch gar nicht so ohne Weiteres entscheiden, war das jetzt eine bewusste Aktion des Nutzers oder vielleicht eine Fehlfunktion.

Soekadar: Exakt, und genau deswegen fordern wir, dass sämtliche Systemparameter, aber auch die Hirnaktivität vorübergehend in eine Art Blackbox aufgezeichnet wird, aber dass natürlich das Aufzeichnen dieser Daten unter den besten Prinzipien des Datenschutzes erfolgt, damit nicht Schindluder damit getrieben wird.

Vetofunktion für hirngesteuerte Systeme

Krauter: Welche anderen technischen Vorkehrungen ließen sich denn treffen, um mögliche unerwünschte Zwischenfälle zu vermeiden mit solchen Neuroprothesen?

Soekadar: Also im Kern fordern wir, dass es bei allen hirngesteuerten Systemen, insbesondere wenn auch semiautonome Komponenten eine Rolle spielen – das heißt, dass die sozusagen nur ein Startsignal geben und der Roboter dann entscheidet, was ist der beste Lösungsweg, das heißt, wo Sie selber auch gar nicht absehen können, wie genau verhält sich das System jetzt in dieser Situation –, eine sogenannte Vetofunktion integriert wird. Das heißt, dass Sie zu jedem Zeitpunkt in der Lage sind, mit hoher Sicherheit die Handlung, die da von der Maschine ausgeführt wird, zu unterbrechen.

Krauter: Also eine Art Notausschalter, –

Soekadar: Absolut.

Krauter: – nur gedanklich realisiert?

Soekadar: Ja, das Problem ist, dass bei den gedanklich realisierten Vetosystemen im Grunde genommen das Ganze noch nicht zuverlässig genug funktioniert, und wir haben in Tübingen ja ein System entwickelt, das auch im Alltag eingesetzt werden kann von querschnittsgelähmten Patienten. Die benutzen dann entsprechende Augenbewegungen, um ungewollte Handlungen des Exoskeletts, das ihnen erlaubt, eine Gabel zu greifen zum Beispiel, zu unterbrechen.

Emotionale Zustände und Gedanken auslesen?

Krauter: Und das funktioniert schon zufriedenstellend?

Soekadar: Ja, man muss sagen, dass natürlich die Vetofunktion über Augenbewegung sehr zuverlässig funktioniert. Bei anderen Systemen, wo jetzt keine Augenbewegungen vorhanden sind, müsste man sich dann überlegen, wie man so eine Vetofunktion realisiert, aber dass es eine solche Vetofunktion geben muss, das ist sozusagen Kern unserer Forderung.

Krauter: Jetzt haben wir über Haftungsfragen gesprochen, über Betriebssicherheit auch. Wie sieht es mit dem Datenschutz aus? Da werden ja auch ja letztlich Gedanken ausgelesen. Auch da könnte man auf die Idee kommen, dass irgendeiner die mitlesen und vielleicht Informationen missbrauchen könnte.

Soekadar: Ja, das ist natürlich eine berechtigte Sorge. Im Moment ist es so, dass wir viele der Hirnaktivitätsmuster nicht interpretieren können. Jetzt wissen wir aber, wenn man jetzt diese Hirnaktivität aufzeichnet und weiß, in welchem Kontext sie entstanden ist und vielleicht auch noch andere Biosignale mitaufzeichnet, zum Beispiel Puls oder Atemfrequenz, dass man dann diesen Hirnaktivitäten bestimmte Zustände zuordnen kann, also zum Beispiel emotionale Zustände oder bestimmte Gedanken. Und das ist natürlich ein Problem in der Zukunft, dass dann, wenn man solche Hirn-Maschine-Schnittstellen oder Hirn-Computer-Schnittstellen regelmäßig einsetzt, auch möglicherweise emotionale Zustände oder Gedanken auslesen kann. Das ist natürlich kein Problem, das wir im Moment haben, aber es ist ja so, dass mehrere Unternehmen, insbesondere in den USA, genau auch diese Gehirn-Maschine-Schnittstellen in unseren Alltag integrieren möchten.

Krauter: Das heißt, das würde sich dann die Frage stellen, ob man diese Daten irgendwie verschlüsseln kann, damit kein Unberechtigter mitlesen kann.

Soekadar: Das ist genau die Frage, und da fordern wir, dass die besten Standards, was die Verschlüsselung der Daten angeht, eingehalten werden müssen.

"Sicherstellen, dass Hirnschrittmacher nicht von außen manipuliert werden"

Krauter: Ein anderes interessantes Stichwort in Ihrem Artikel ist das Wort "Neurojacking". Was verbirgt sich dahinter und was lässt sich dagegen tun?

Soekadar: Also es ist so, dass natürlich Sie über eine Hirn-Maschine-Schnittstelle Informationen, oder sagen wir mal Hirnaktivität aus dem Gehirn, auslesen können. Jetzt gibt es natürlich auch Systeme, die nicht nur auslesen können, sondern möglicherweise auch das Gehirngewebe direkt stimulieren können, elektrisch zum Beispiel, und bei solchen Systemen muss man natürlich aufpassen, dass nicht von außen jemand Zugriff bekommt und dann diese Hirnstimulation in seinem Sinne einsetzt und dadurch natürlich das Verhalten von den Anwendern beeinflussen kann von außen.

Krauter: Also es könnten jetzt zum Beispiel Hirnschrittmacher sein, wie sie bei Epilepsie manchmal zum Einsatz kommen, solche Dinge?

Soekadar: Ganz genau, und bei diesen Hirnschrittmachern ist natürlich das Problem, dass man sicherstellen muss, dass die nicht von außen manipuliert werden, aber das Ganze wird natürlich noch ein größeres Problem, wenn Sie Hirn-Maschine-Schnittstellen haben, die also in großer Anzahl bei auch der Normalbevölkerung, die das nicht zu medizinischen Zwecken einsetzen, eingesetzt wird.

Krauter: Im Sinne von Neuro-Enhancement, was ja auch so eine Bewegung ist, die vielleicht noch auf uns zukommt in größerem Maße.

Soekadar: Ganz genau, und da sagen wir, wir müssen jetzt daran denken, uns mit den ethischen und rechtlichen Fragen auseinanderzusetzen, damit wir nicht später vom technologischen Fortschritt überrollt werden.

Äußerungen unserer Gesprächspartner geben deren eigene Auffassungen wieder. Der Deutschlandfunk macht sich Äußerungen seiner Gesprächspartner in Interviews und Diskussionen nicht zu eigen.