"Hey Donald, have you heard about this new technology?", fragt eine künstliche Obama-Stimme.

Im April 2017 veröffentlicht das kanadische Startup-Unternehmen Lyrebird eine Demonstration seines Könnens:

"Are you speaking about this new algorithm to copy voices?", antwortet eine künstliche Trump-Stimme.

Eine einminütige Tonaufnahme, schon kann das System jeden Text mit derselben Stimme vorlesen.

"This is huge, it can make us say anything, really anything."

Das Ganze funktioniert einigermaßen gut, wie man an diesem kleinen, vermeintlichen Dialog zwischen Barack Obama und Donald Trump hört. Man kann das als eine interessante technische Spielerei begreifen. Oder kreativ weiterdenken.

"Hi grandma, I need some money! Maybe 50 Dollar?"

"Piotr Heller, that’s me."

Es ist erst ein paar Monate her, dass die Macher von Lyrebird eine Demoversion ihres Systems veröffentlicht haben. Daher kann es auch mit meiner Stimme sprechen, wenn auch nur auf Englisch.

"This is huge. How does that technology work?"

Selbstlernende, künstliche neuronale Netze

Es wäre natürlich interessant zu erfahren, wie diese Technologie genau funktioniert. Aber das wissen derzeit nur ihre Entwickler. Und die stehen trotz mehrerer Anfragen nicht für Interviews zur Verfügung. In ihrer Demonstration geben sie zumindest einen Hinweis mit der Stimme von Hillary Clinton:

"Hey guys! I think they use deep learning and artificial neuronal networks."

"Hillary is right."

Das System nutzt also künstliche neuronale Netze. Das sind selbstlernende Computerprogramme. Ihre Arbeitsweise ist grob dem Lernprozess eines Gehirns nachempfunden. Damit das System meine Stimme lernt, muss ich auf die Lyrebird-Homepage gehen und mindestens 30 vorgegebene Sätze einsprechen.

"Stall it along until the extra comes out."

"Nobody's trying to put anything over on you."

Diese Aufnahmen analysiert das System und lernt dabei Satz für Satz dazu. Am Ende kann es jeden beliebigen Text mit meiner Stimmte aufsagen. Etwa so:

"It’s not perfect, but it sounds pretty good, don’t you think so?"

Manche Krankheiten zerstören die Stimme von Menschen. Lyrebird könnte sie ihnen zurückgeben. Es könnte auch die Stimme von James Dean zurückholen, Hörbücher und virtuelle Assistenten personalisieren - oder eine Kreissparkasse ausräumen.

"Unsere Kreissparkasse in Kaiserlautern, die wird jetzt in den nächsten Jahren etliche Filialen schließen und bietet gleichzeitig an, dass Sie dort anrufen können und über Ihre Daten Bargeld bestellen", sagt Andreas Dengel

Wie sich Lyrebird missbrauchen ließe

In Kaiserslautern gibt es nicht nur die Kreissparkasse, sondern auch das DFKI, das Deutsche Forschungszentrum für künstliche Intelligenz. Andreas Dengel arbeitet hier an selbstlernenden Systemen. Sein Büro ist modern eingerichtet, viel Stahl und Glas, an den Wänden hängt fernöstliche Kunst. An diesem Abend sitzt er hier in einem tiefen Ledersessel und überlegt, wie sich Lyrebird missbrauchen ließe. Er muss nicht lange grübeln.

"Jetzt nehmen Sie an, sie haben sowas wie Lyrebird auf der einen Seite – die Daten kann man vielleicht erspähen – und man ruft jetzt auf seiner Sparkasse an und sagt: 'Ich habe meine Rente erhalten, und ich möchte jetzt 500 Euro da und da hin gebracht haben, meine Enkelin wird sie abpassen, ich bin nicht verfügbar.’ Man kommt da an und liefert das ab und tatsächlich wurde die Stimme gefaked und man verwendet KI, um sowas zu tun."

Ob diese Betrugsmasche in allen Einzelheiten so klappen würde, ist nicht klar. Sie macht aber eines deutlich: Künstliche Intelligenz erwirbt derzeit Fähigkeiten, die auch Kriminelle interessieren. Die Entwicklungen der letzten Jahre spielen ihnen in die Hände: Wer früher einen Schachcomputer oder eine Übersetzungsmaschine programmieren wollte, der musste ihnen jede Regel einzeln per Hand beibringen. Mittlerweile lernen die Maschinen selbst.

"Wir sind heute dazu übergegangen sehr datenintensiv zu arbeiten, dass wir hierdurch die Grundlage geschaffenhaben, jetzt Konzepte des Trainings von neuronalen Netzen eben so weit zu entwickeln, dass wir übermenschliche oder "Super Human"-Fähigkeiten entwickeln können auf solchen Maschinen", sagt Andreas Dengel.

Grundlagen für "Super Human"-Betrüger

"Super Human"-Fähigkeiten. Das sind etwa "Super Human"-Autofahrer, also autonome Autos, die bald sicherer im Straßenverkehr unterwegs sein sollen als Menschen. Es sind "Super Human"-Ärzte: Diagnoseprogramme, die bösartige Hautveränderungen auf Fotos schneller und teilweise zuverlässiger als menschliche Dermatologen finden. "Super Human"-Taktiker: Programme wie Alpha Go, das die weltbesten Profis im Brettspiel Go besiegte und sogar bisher unbekannte Strategien für dieses altertümliche Spiel entwickelte.

Und wer aktuelle Veröffentlichungen von Computerwissenschaftlern durchblättert, bekommt den Eindruck, dass die klugen Köpfe an den Universitäten mit Tools wie dem Stimmen-Imitator gerade die Grundlagen für "Super Human"-Betrüger schaffen.

Die Frage ist: Wie super sind sie denn? Kann ich sie erkennen, wenn sie mir begegnen?

In Darmstadt, am Fraunhofer Institut für Grafische Datenverarbeitung hört sich Andreas Braun die Lyrebird-Beispiele an und ist vom Versprechen der Entwickler beeindruckt.

"Also generell, dass man versucht, aus aufgenommenen Sprachparametern, die wichtigsten Merkmale einer Stimme herauszuholen, ist in dem Sinne nichts Neues. Die Geschwindigkeit, in der versprochen wird, das zu tun, dass man bereits aus einer Minute Sprachaufnahmen eine naturgetreue Stimme nachbilden möchte, das wäre was Neues, wenn es denn so funktionieren würde."

Andreas Braun ist Informatiker und spezialisiert auf Computersysteme, die Menschen anhand von Fingerabdrücken oder ihres Gesichts oder eben ihrer Stimme erkennen. Im Vereinigten Königreich etwa bieten manche Banken ihren Kunden das so genannte Voice Trust Verfahren an. Bei dieser Sprachverifikation erkennt ein Programm an der Stimme eines Kunden, ob er wirklich der ist, der er vorgibt zu sein. Genau diese Technik könnte man mit Sprachsynthese-Algorithmen wie Lyrebird eventuell täuschen. Andreas Braun wiederum will Fake-Stimmen entlarven.

Noch recht roboterhaft

"Jeder Synthese-Algorithmus hat gewisse Eigenschaften. Er versucht die Sprache auf eine gewisse Art und Weise so zu modifizieren, dass sie für uns natürlich klingt. Und da wir wissen, wie das Tonsignal modifiziert wird, können wir auch genau wieder diese Muster erkennen, die dieser Algorithmus dann in dem Sprachsignal hinterlassen hat."

Die Künstliche Intelligenz hinterlässt eben typische Spuren in ihren Werken. Das macht es anderen Computersystemen möglich, die falschen Stimmen zu entdecken. Wir Menschen haben es da nicht so leicht. Zwar klingen die synthetischen Stimmen für unsere Ohren noch recht roboterhaft:

"The results still are a bit robot-like."

Aber sie werden besser.

"They will definitely get better."

Schon jetzt beherrscht Lyrebird verschiedene Tonlagen, was die Macher wiederum am Beispiel Donald Trumps illustrieren.

"I am not a robot, my intonation is always different. I am not a robot, my intonation is always different. I am not a robot, my intonation is always different."

Es ist nur eine Frage der Zeit, bis solche Systeme mit bloßem Ohr nicht mehr von einem echten Menschen zu unterscheiden sind.

An der University of Bath forscht Tom Haines. Ursprünglich wollte er mit zwei Kollegen ein Programm schreiben, das erkennt, ob eine Handschrift gefälscht ist.

"Dann haben wir uns gedacht: Wir sollten erstmal etwas machen, das Handschriften fälschen kann. Denn wenn man selbst Fälscher ist, kann man Fälschungen leichter erkennen."

"Dann haben wir uns gedacht: Wir sollten erstmal etwas machen, das Handschriften fälschen kann. Denn wenn man selbst Fälscher ist, kann man Fälschungen leichter erkennen."

Als System gedacht, Handschriften zu imitieren

Doch schon allein dieses Zwischenziel habe sich als so herausfordernd entpuppt, dass die Forscher ihren ursprünglichen Plan aus den Augen verloren. Sie konzentrierten sich also voll und ganz darauf, ein System zu entwickeln, das Handschriften imitiert. Und es ist ihnen gelungen.

"Damit kann man etwa Gelähmten ihre Handschrift zurückgeben. Das andere wäre das Floristen-Scenario: Wenn man Blumen verschickt, haben die immer diese furchtbar unpersönlichen maschinell geschriebenen Grußbotschaften. Mit unserem System könnte man sie in der eigenen Handschrift drucken lassen. Oder bei Übersetzungen von Comicbüchern die charakteristische Handschrift der Zeichner erhalten."

Und so funktioniert das Programm: Es braucht ein paar Sätze, die eine Person aufgeschrieben hat. Die werden eingescannt.

"Dann kommt der Markierungsprozess. Das läuft halbautomatisch. Ein Mensch geht also diesen Text durch und sagt dem Computer: Das ist ein A, das ist ein B und so weiter."

Das System lernt, damit nicht nur die Form der Buchstaben nachzuahmen. Es analysiert den Gesamteindruck der Schrift und versucht, ihn widerzugeben.

"Wir haben herausgefunden, dass es – um jemanden zu täuschen – vor allem darauf ankommt, wie die Buchstaben verbunden sind und wie weit sie auseinander stehen. Das ist eben der Schreibfluss und wenn man den nicht gut simuliert, dann wirken die Ergebnisse künstlich."

Probanden konnten Unterschied nicht feststellen

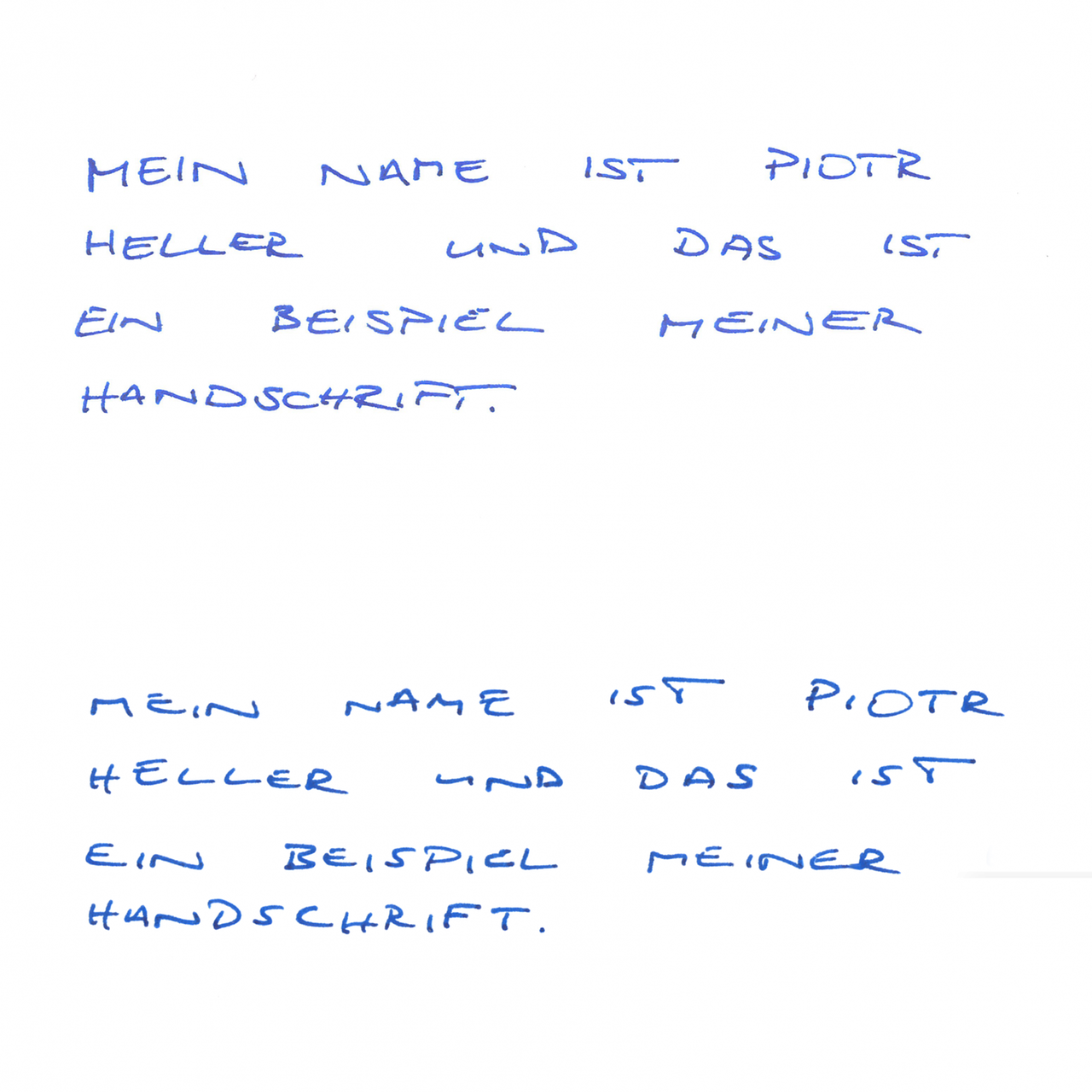

Das ist beim Programm der Informatiker nicht der Fall: In Experimenten präsentierten sie Testpersonen verschiedene echte und gefälschte Texte – die Probanden konnten den Unterschied nicht feststellen. Doch wie gut ist das System wirklich? Um das herauszufinden, habe ich Tom Haines eine Probe meiner Handschrift gegeben.

"Diese Handschrift ist schon fast zu einfach für uns: Alles in Großbuchstaben, die kaum verbunden sind."

Er fütterte sein System damit und ließ es einen einfachen Text schreiben: "Mein Name ist Piotr Heller und das ist ein Beispiel meiner Handschrift." Den gleichen Text habe auch ich aufgeschrieben und eingescannt. Dann habe ich beides auf einer Seite ausgedruckt: Oben den Satz in meiner Handschrift, direkt darunter die maschinelle Imitation meiner Handschrift. Damit bin ich dann ins Mannheimer Schrift- und Urkundenlabor gegangen.

"Ja, Hallo?"

"Hallo, Piotr Heller vom Deutschlandfunk."

"Kommen Sie rein, wir sind im dritten Stock."

In dem Labor arbeiten die erfahrenen Schriftsachverständigen Gudrun Bromm und Elisabeth Hoffmann. Ihr Job ist es, für Gerichte zu prüfen, ob ein Testament wirklich aus der Feder des Verstorbenen stammt oder eine Unterschrift echt ist. Ich zeige ihnen die Seite und sage, dass ich nur einen der Sätze selbst geschrieben habe und der andere eine Fälschung ist.

Die beiden Schriftsachverständigen wissen nicht, dass einer der Texte von einem Computerprogramm geschrieben wurde. Gudrun Bromm greift zu einer Lupe:

"Ich habe erstmal versucht, mir einen groben Eindruck von den beiden Schriften zu verschaffen. Ich habe mir zum Beispiel angeschaut, wo beginnt der Buchstabe O und wo endet er. Die Wölbung ist offen. Wenn man jetzt das Original hätte, könnte man sehen, ob dieses Rundelement im Uhrzeigersinn oder gegen den Urzeigersinn geschrieben wurde."

"Zunächst ist festzustellen, dass die Schriften auf den ersten Blick relativ ähnlich aussehen, das muss aber nichts bedeuten", sagt Elisabeth Hoffmann.

Erstdiagnose falsch

Normalerwiese nehmen sich die Sachverständigen mehr Zeit für eine Überprüfung und haben vor allem das Original vorliegen, an dem Sie etwa untersuchen, wie fest beim Schrieben aufgedrückt wurde. Ich gebe Gudrun Bromm und Elisabeth Hoffmann jetzt andere Handschriften von mir.

"Ich habe noch andere Beispiele meiner Handschrift dabei."

Können die Schriftsachverständigen jetzt feststellen, ob der untere oder der obere Satz von mir stammt? Mit der Erstdiagnose liegt Elisabeth Hoffmann daneben.

"Ein Detail, was mich zunächst veranlasst hatte, aber nur zunächst, eher zu sagen, Sie hätten die untere Eintragung gefertigt, ist das S. Weil dieser Basis-Querzug hier gebogen ist, was ich gemeint habe auch in Ihrer Schrift zu sehen. Aber die Schriften sind erstmal so ähnlich, dass man wirklich erst jedes Detail prüfen muss und dann sehen, ob man überhaupt eine gerichtete Schlussfolgerung ziehen kann."

So eine echte Überprüfung dauert mehrere Stunden und dafür ist einfach keine Zeit. Ich löse auf und erkläre, dass der untere Satz von einem Computerprogramm geschrieben wurde, der meine Handschrift imitieren kann. Gudrun Bromm hat daraufhin eine Vermutung, wie man das Programm hätte entlarven können. Sie steht auf und macht eine Kopie der Seite.

"Ich mache das mit einer Leuchtplatte, man braucht ein Hintergrundlicht. Normalerweise machen wir das mit einem Computerprogramm und überlagern die Schriften. Wenn man hier das 'ist’ aus der Schreibleistung aus Zeile eins und zwei übereinanderläge, dann sieht man schon: Eine fast absolute Deckungsgleichheit. Und da eine Person nie zwei Mal exakt gleich schreibt, wäre das ein Hinweis, dass es eine Fälschung ist."

Doch noch aufgeflogen

So wäre die Fälschung bei genauerer Betrachtung doch noch aufgeflogen. Sind die Sachverständigen denn beeindruckt von der Technologie?

"Also technische Fälschungen hat es vorher auch schon gegeben. Die waren nur mühevoller zu fertigen. Was hier eben mit Hilfe dieses Computerprogramms möglich ist, ist dass es sozusagen ein Verfahren für jedermann wird und dadurch auch eine wahrscheinlich deutlich größere Verbreitung erfährt."

Genau das ist die Gefahr: Künstliche Intelligenz macht Fälschungen zur Massenware. Übeltäter werden sich in Zukunft nicht mehr mühevoll Tonaufnahmen oder handgeschriebene Buchstaben zurechtschneiden müssen. Nein, dank künstlicher Intelligenz werden sie im Handumdrehen zig Handschriften fälschen oder Stimmen nachahmen. Tom Haines hat sein Werkzeug zum Fälschen von Handschriften sogar open source für jeden verfügbar gemacht. Wer einigermaßen programmieren kann, kann es nutzen. Ist das nicht unverantwortlich?

"Wir sind bis zu dem Punkt gegangen, an dem wir Menschen, die sich nicht zu sehr mit der Sache auseinandersetzen, täuschen. Wir sind nicht weitergegangen. Das war eine bewusste Entscheidung. Als nächstes hätten wir versuchen können, Schriftsachverständige zu täuschen, aber das wollten wir nicht. Jetzt ist das System für unsere Comicbücher oder personalisierten Grußkarten geeignet, alles, was darüber hinausgeht, wäre Wahnsinn."

Aber ist es nicht schon schlimm genug, dass das Programm den Durchschnittsbürger täuschen kann?

"Wir schaffen mit unserer Arbeit Gefahrenbewusstsein"

"Heute gibt es gar nichts mehr, das man nicht fälschen könnte, wenn man genug Geld hat. Man muss sich nur die Technik der neuen Hollywoodfilme anschauen. Und ich glaube, die Menschen sollten sich dessen bewusst sein."

Tom Haines sagt: Wir schaffen mit unserer Arbeit Gefahrenbewusstsein. Das sei wichtig, denn Kriminelle interessieren sich natürlich für künstliche Intelligenz.

"Professionelle Kriminelle, das ist deren Profession. Dann geht es darum, dass der potenziell motivierte Täter auf der Suche nach geeigneten Tatobjekten ist, und sich dann Tatgelegenheiten bedient, die ihm zur Verfügung stehen. Und das ist halt einfach heutzutage ein IT-Tool", so nüchtern betrachtet Dirk Fleischer die Sache.

Der ehemalige Bundespolizist ist Mitglied der Deutschen Gesellschaft für Kriminologie und berät große Unternehmen in Sachen Sicherheit. Wie würde denn eine Betrugsmasche mit Hilfe von künstlicher Intelligenz aussehen? Sagen wir: Eine Entführung?

"Die Eltern, die davon ausgehen, dass ihr Kind entführt wurde, weil auf der anderen Seite spricht das Kind tatsächlich mit mir und ruft mit der Nummer an, die über ein ganz normales Telefonspoofing dann bei mir falsch dargestellt wurde. Ich habe den Eindruck, ich spreche mit meinem Kind, was sich gerade tatsächlich in der Gewalt eines anderen befindet, und bin dann bereit, irgendwelche kurzfristigen Zahlungen zu machen."

Einen Fall gab es schon

Bei so etwas würde eine Sprachsynthese à la Lyrebird helfen. Zugegeben: Das alles ist noch recht theoretisch, zumal die Verbrecher erst eine Stimmprobe des Kindes bräuchten. Aber wenn sie die von mehreren Kindern hätten, könnten sie auch gleichzeitig viele Eltern anrufen und so darauf spekulieren, dass zumindest einige darauf reinfallen und zahlen. Einen Fall, den man als Vorboten begreifen kann, gab es sogar schon:

"An einem Freitagvormittag werden über 200 Mitarbeiter eines Unternehmens angeschrieben, die über Web Crawler identifiziert wurden, und alle mit einer individuell gesteuerten Mail aufgefordert, doch bitte freundlicherweise ihre Kontodaten, Reisepass-Daten und so weiter zur Verfügung zu stellen, weil es ein SAP-Update gab und die Gehaltszahlungen nicht mehr garantiert werden können. Das war alles automatisiert. Jede Mail war in einem sehr, sehr engen Zeittakt an die entsprechenden Adressaten geschickt worden."

Fleischer vermutet, dass hier Computerprogramme am Werk waren, die das Internet automatisch nach passenden Opfern durchsucht haben, etwa in Karrierenetzwerken.

"Es passte von vorne bis hinten: Die Ansprechpartner im Unternehmen, die da gewählt wurden, waren die richtigen. Selbst die Signaturen stimmten. Am Ende des Tages haben rund 20 Prozent der angeschriebenen darauf reagiert."

Vielleicht wären noch mehr Menschen hereingefallen, wenn das Schreiben per Fax gekommen wäre, mit der gefälschten Unterschrift des Personalchefs. Andererseits: Wirkt die Handschrift im geschäftlichen Umfeld überhaupt noch zeitgemäß?

"Die Handschrift ist zeitgemäß, weil sie nämlich immer Vertraulichkeit suggeriert. Also der formale Geschäftsbrief, der handschriftlich mit 'Sehr geehrter Herr Doktor, lieber Klaus’, anfängt, wird anders wahrgenommen als die E-Mail."

Adressen, Geburtstage, Kontoinformationen, Kreditkartennummern oder Passwörter

Wenn man sich mal das große Bild anschaut, dann erweitern Programme, die Handschriften oder Stimmen imitieren, ein bekanntes Phänomen: Den Identitätsdiebstahl. Dabei spähen Täter persönliche Daten wie Adressen, Geburtstage, Kontoinformationen, Kreditkartennummern oder Passwörter ihrer Opfer aus. Damit machen sie dann Geschäfte im Namen der Opfer. In den USA etwa sollen im letzten Jahr 16 Milliarden Dollar auf diese Weise erbeutet worden sein. Demnächst kann eine gestohlene Identität auch die Stimme oder die Handschrift enthalten. Das alles ist nur möglich, weil sich ein großer Teil unserer Kommunikation ins Internet verlagert hat. Wir stehen mit Banken, Geschäften, Bekannten und sogar den eigenen Kindern über Chatprogramme oder soziale Netze in Verbindung. Da ist es manchmal nicht so einfach zu erkennen, ob das Gegenüber wirklich die Person ist, die sie vorgibt zu sein.

Gallileo, Pro Sieben: "Sieht lustig aus, ist aber heikel, denn die Software bietet ungeahnte Möglichkeiten der Manipulation.

Wissenschaftsdoku, 3Sat: "Das System ist ideal, um damit großen Unfug zu treiben."

So kritisch war das Medienecho, als Forscher vom Max-Planck-Institut für Informatik und der Universität Erlangen-Nürnberg 2016 ihr System Face2Face vorstellen. Das ist ein Grund, warum sie heute keine Interviews mehr zu dem Thema geben wollen.

"Wir präsentieren eine neue Methode zur Veränderung von Gesichtszügen, die mit jeder gewöhnlichen Webcam funktioniert."

Jede Person zu einer Art Gesichts-Marionette machen

Auf Youtube kann man sich aber noch eine Demonstration der Technologie anschauen. Darin zu sehen ist einer der Forscher. Vor einer Webcam zieht er Grimassen. Hinter ihm läuft ein Video. Es zeigt den US-Präsidenten George W. Bush. Das Besondere: Der Präsident hat exakt den gleichen Gesichtsausdruck wie der Forscher. Das Ganze funktioniert so: Das System nimmt ein beliebiges Video von Bush, analysiert es und berechnet ein Modell der Gesichtszüge und der Mimik. Damit kann es jede beliebige Mimik des Forschers auf das Gesicht von Bush übertragen. Und auch auf jeden anderen Menschen. Man könnte sagen, dass man mit dieser Technik jede Person zu einer Art Gesichts-Marionette machen kann.

"Wie man hier sieht, können wir eine realistische und überzeugende Veränderung der Gesichtszüge generieren."

Die Forscher veröffentlichten Ihr System ausgerechnet zu einer Zeit, in der viel von Fake News die Rede war, also von bewusst lancierten falschen Behauptungen. Für die USA konnten Forscher der Indiana University inzwischen zeigen, dass Falschinformationen kurz nach ihrer Veröffentlichung vor allem von Bots über soziale Netzwerke weitergeleitet werden, also von automatischen Konten, die sich als Menschen ausgeben.

"Wenn man jetzt die Entwicklungen bei einigen Wahlen der jüngsten Vergangenheit sieht, welchen Ausgang die hatten und mit welchen Möglichkeiten es tatsächlich heute geht, Menschenmassen zu manipulieren, dann glaube ich, dass es zunehmend auch ein Interesse geben wird, wie man das optimieren kann. Und dass man dann auch versuchen wird, Technologien gezielter einzusetzen, um eigene Vorteile herauszuschlagen"

Ein Beispiel: Ende letzten Jahres tauchte auf Facebook ein Foto der Grünen-Politikerin Renate Künast auf. Darunter ein Zitat. Es sollte sich auf den Fall Maria L. beziehen, bei dem ein Flüchtling eine Studentin ermordet haben soll:

"Der traumatisierte Flüchtling hat zwar getötet, man muss ihm aber jetzt trotzdem helfen."

Mit bloßem Auge nicht mehr erkennbar

Als Quelle war die Süddeutsche Zeitung angegeben. Natürlich hat Renate Künast das nie gesagt. Es ist ein Beispiel für Fake News. Mit Systemen wie Lyrebird und Face2Face hätte man Renate Künast diese Worte auch in einem Video in den Mund legen können.

Wenn in Zukunft tatsächlich solche Fakes auftauchen, würde ich sie gern erkennen. Sollte das mit dem bloßen Auge nicht mehr möglich sein, müssen Algorithmen her. Für von Hand gefälschte Fotos gibt es die bereits. Sie werden zum Beispiel am Fraunhofer Institut für Sicherheit in der Informationstechnik in Darmstadt entwickelt.

Wenn in Zukunft tatsächlich solche Fakes auftauchen, würde ich sie gern erkennen. Sollte das mit dem bloßen Auge nicht mehr möglich sein, müssen Algorithmen her. Für von Hand gefälschte Fotos gibt es die bereits. Sie werden zum Beispiel am Fraunhofer Institut für Sicherheit in der Informationstechnik in Darmstadt entwickelt.

Auf dem Computermonitor flimmert ein Propaganda-Foto der iranischen Regierung, das vier Raketen beim Start zeigt. Tatsächlich waren es nur drei, eine wurde im Bild kopiert. Martin Steinebach startet den so genannten Duplikat-Detektor.

"Da werden Regionen miteinander verglichen und dann erkennt der Rechner, dass das abgeschlossen ist, und zeigt mir hier ein Ergebnis an. Das ist rot hinterlegt, hat also gesagt: Da ist ein Problem, das können wir uns jetzt mal im Detail anschauen."

Der Duplikat-Detektor ist Teil eines Pakets, das das Institut für Versicherungen entwickelt hat. Ein weiteres Tool: Ein allgemeiner "Manipulations-Detektor".

"Jedes Bild hat ein natürliches Rauschen. Und wenn ich jetzt anfange, in dem Bild Objekte hin und her zu kopieren und dann mit einem Weichzeichner da schön reinzufügen… die verändert dieses natürliche Rauschen."

Natürlich oder aus Fragmenten zusammengesetzt?

Martin Steinebach öffnet das Bild eines Ententeiches und startet das Programm. Sofort markiert es eine der Enten rot.

"Diese Ente, die ist wahrscheinlich nachträglich in das Bild reinkopiert worden, weil das Bildrauschen an dieser Stelle einfach nicht passt."

Könnte man diese Technik auch nutzen, um etwa die manipulierte Mimik der Face2Face Videos zu erkennen? Noch ist das schwer zu beurteilen, aber prinzipiell geht Steinebach davon aus, dass das Tool auch in den Videos seine Spuren hinterlässt.

"Ist das eine natürliche Mimik? Oder wird sie vielleicht aus Bild-Fragmenten zusammengesetzt? Das kommt darauf an, wie der Algorithmus funktioniert. Oder man merkt, dass die Charakteristiken, wie jetzt Beleuchtung, Rauschen in der Gesichtspartie eine ganz andere ist wie im Hintergrund, Haut, Haare. Also dazu braucht man die Videos und kann dann die forensisch untersuchen und entscheiden, ob das für manche Betrachter eine Herausforderung ist und für den Computer trivial oder auch für den Computer schwer."

Selbst lernende Algorithmen lernen schnell. Damit dürften die kriminellen Machenschaften, die es immer gab, schon bald ein neues Niveau erreichen. Das wird Opfer fordern und vermutlich auch unser Vertrauen in Dokumente und Demokratie generell erschüttern. Natürlich werden die Informatiker reagieren und Systemen entwickeln, die Mimik und Gestik, Schrift und Stimme nach Spuren künstlicher Intelligenz absuchen. Denkbar wäre eine Erweiterung für den Internetbrowser, mit der jeder verdächtige Posts durchleuchten kann.

Aber wir sollten uns keiner Illusion hingeben: Solche Erkennungsprogramme wären keine dauerhafte Lösung, sondern lediglich die nächste Etappe im Rüstungswettstreit. Derzeit lernen die künstlichen Intelligenzen, wie sie uns täuschen. Als nächstes könnten sie lernen, andere Computer zu täuschen, um unerkannt zu bleiben.

"Gangster Code: Fraud with artificial intelligence"

Gangster Code: Betrüger mit künstlicher Intelligenz

Von Piotr Heller

Es sprachen: Der Autor und Thomas Holländer

Ton: Alexander Brennecke

Regie: Friederike Wigger.

Redaktion: Christiane Knoll

Eine Produktion des Deutschlandfunk 2017

Von Piotr Heller

Es sprachen: Der Autor und Thomas Holländer

Ton: Alexander Brennecke

Regie: Friederike Wigger.

Redaktion: Christiane Knoll

Eine Produktion des Deutschlandfunk 2017