Ein junges Team der Technischen Universität von Shanghai hat auf der Siggraph eine Methode vorgestellt, mit Künstlicher Intelligenz tief in real gefilmte Szenen einzugreifen. Aus zwei Tänzern in einem Raum werden 20 gemacht oder einer davon riesengroß und zehn winzig klein – so etwas war bisher nicht zu sehen und wird Auswirkungen nicht nur in Musikvideos haben.

Der Koordinator des Projekts, Zhang Jaikai, erklärt, "mich haben einige Arbeiten inspiriert, etwa von der Universität in Berkeley mit dem gelungenen Versuch, künstliche Kamerabewegungen zu ermöglichen. Die Methode nennt sich Neural Radiance Field, kurz NeRF. Dabei kann man aber nicht Inhalte des Videos verändern. Eine andere, für uns wichtige Inspiration kommt aus dem Google-Forschungsbereich, wo man mit einer Kamera jemanden in Bewegung aufnimmt und anschließend aus der Aufnahme entfernt. Wir wollten die ganze 3D-Szene erfassen, statt auf die KI-Interpretation eines Videos angewiesen zu sein."

Vervielfältigung wird automatisch erledigt

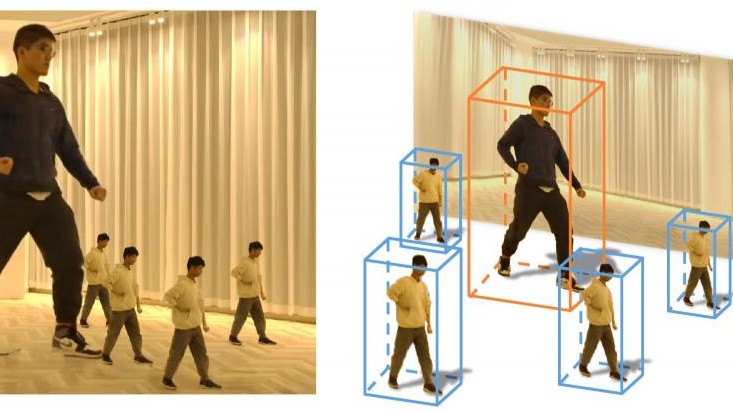

Bei den Aufnahmen mit den Tänzern wurde mit mehreren Kameras "alles in Innenräumen aufgenommen, wegen des kontrollierbaren Lichts. Die 16 Kameras waren synchronisiert und nahmen alles in 4K-Auflösung auf. Hauptaugenmerk war, dass sie zu jeder Zeit von allen Kameras gesehen werden konnten", sagte Zhang. Um Personen aus einer real gefilmten Szene und mit ihnen die Schatten und Reflexionen zu entfernen, "erfassen wir die Personen, indem wir um sie herum dreidimensionale Boxen erzeugen. Für jede Person trainieren wir dann die KI. Wenn die Schatten sich außerhalb der Box befinden, lernt das neuronale Netz etwas Falsches, und wir können die Figur dann nicht inklusive Schatten aus der Szene entfernen." Wenn im Gegensatz zum Entfernen von Personen diese vervielfacht, sogar vergrößert und verkleinert und in der Zeit verschoben werden, dann macht das die eingesetzte Volumen-Rendering-Technik automatisch.

"Was nicht funktioniert, sind verschiedene Lichtverhältnisse in verschiedenen Szenarios"

Technisch sei es auch kein Problem, eine Person aus einem Innenraum nach draußen zu versetzen, erklärt Zhang. "Was aber nicht funktioniert, sind die verschiedenen Lichtverhältnisse in verschiedenen Szenarios. Der direkte Transfer einer Tänzerin würde nicht überzeugend aussehen, es sei denn, die beiden Szenen haben zufällig sehr ähnliche Beleuchtung."

Die Software "ist komplett in Python programmiert. Wir nutzen das Open Source Programm Pytorch, um das neuronale Netz für jede dynamische Szene neu zu trainieren. Wir haben den Code auf Github veröffentlicht, wo ihn jeder selbst ausprobieren kann."

Das Interview in voller Länge:

Maximilian Schönherr: Der Koordinator des Projekts ist Zhang Jaikai. Waren sie überrascht, dass ihre Arbeit von der strengen Jury der Siggraph akzeptiert wurde?

Zhang Jaikai: Ich bin in meinem zweiten PhD-Jahr, und das war das erste Paper, das ich eingereicht habe. Es war eine unglaubliche Überraschung für das ganze Team. Wir haben die 14 Seiten mit vielen wunderschönen Illustrationen in nur drei Monaten fertiggestellt!

Schönherr: Wie kamen sie überhaupt auf die Idee?

Zhang: Mich haben einige Arbeiten inspiriert, etwa von der Universität in Berkeley mit dem gelungenen Versuch, künstliche Kamerabewegungen zu ermöglichen. Die Methode nennt sich Neural Radiance Field, kurz NeRF. Dabei kann man aber nicht Inhalte des Videos verändern. Eine andere für uns wichtige Inspiration kommt aus dem Google-Forschungsbereich, wo man mit einer Kamera jemanden in Bewegung aufnimmt und anschließend aus der Aufnahme entfernt. Wir wollten die ganze 3D-Szene erfassen, statt auf die KI-Interpretation eines Videos angewiesen zu sein. In unserem Team arbeiten jetzt drei Ingenieure, die die Daten sammeln und verarbeiten. Vier Personen schreiben Code und trainieren das Neuronale Netz. Ich habe die Sachen im Wesentlichen koordiniert.

Schönherr: Sie nutzen mehrere Kameras für die Aufnahme. Ähnliche Ergebnisse ließen sich also nicht mit nur einer Kamera erreichen?

Zhang: Sicherlich nicht. Denn eine Kamera kann nicht die vielen Betrachtungswinkel gleichzeitig aufnehmen.

Schönherr: Können sie etwas über die Aufnahmen mit Ihren Tänzern sagen?

Zhang: Wir haben alles in Innenräumen aufgenommen, wegen des kontrollierbaren Lichts. Die 16 Kameras waren synchronisiert und nahmen alles in 4K-Auflösung auf. Wir luden Tänzer aus unserer Universität ein, die so perfekt tanzten, dass wir nur selten Szenen mehrere Male wiederholen mussten. Hauptaugenmerk war, dass sie zu jeder Zeit von allen Kameras gesehen werden konnten. Das war unser Job. Typischerweise haben wir alles dreimal aufgenommen.

Schönherr: Wenn sie Personen aus einer real gefilmten Szene entfernen, wie entfernen sie die Schatten und Reflexionen dieser Person? Ist das schwierig, oder erledigt das die Künstliche Intelligenz aus sich heraus?

Zhang: Wir erfassen die Personen, indem wir um sie herum dreidimensionale Boxen erzeugen. Für jede Person trainieren wir dann die KI. Wenn die Schatten sich außerhalb der Box befinden, lernt das neuronale Netz etwas Falsches, und wir können die Figur dann nicht inklusive Schatten aus der Szene entfernen.

Schönherr: Wenn sie im Gegensatz zum Entfernen von Personen aus der Szene Personen vervielfachen, sogar vergrößern und verkleinern und in der Zeit verschieben, sie also asynchron tanzen lassen – wie gehen sie dann mit Überlappungen um, also wenn ein Tänzer sich vor seinem Duplikat bewegt?

Zhang: Die von uns eingesetzte Volumen-Rendering-Technik macht das automatisch.

Schönherr: Inwieweit beschränken sich Ihre Experimente auf ein und dieselbe Umgebung? Will heißen, können sie eine Person aus einem Innenraum nach draußen versetzen?

Zhang: Technisch ist das kein Problem. Was aber nicht funktioniert, sind die verschiedenen Lichtverhältnisse in verschiedenen Szenarios. Der direkte Transfer einer Tänzerin würde nicht überzeugend aussehen, es sei denn, die beiden Szenen haben zufällig sehr ähnliche Beleuchtung.

Schönherr: Erzählen sie uns ein bisschen über die Software, die Sie einsetzen.

Zhang: Das Projekt ist komplett in Python programmiert. Wir nutzen das Open Source Programm Pytorch, um das neuronale Netz für jede dynamische Szene neu zu trainieren. Wir haben den Code auf Github veröffentlicht, wo ihn jeder selbst ausprobieren kann.

Schönherr: Welche Rolle spielt Augmentierte Realität, also der Mix aus künstlichen und realen Szenen, in ihrer Arbeit? Oder anders gefragt: Setzen sie nur Video ein, oder auch Lidar-Scanner?

Zhang: Augmentierte Realität wird immer wichtiger. Mit Lidar-Scannern hatten wir das Problem, dass sich deren Daten schwer mit RGB-Kameradaten zusammenbringen lassen. Die präzise Entfernungsmessung erledigen wir häufig mit RGB-D-Kameras, die uns zusätzliche Tiefeninformationen liefern und sich leichter kalibrieren lassen und zudem Farbe liefern, was der Laser nicht kann.

Schönherr: Sie zeigen auch ein Beispiel von Kamerastabilisierung. Ein wacklig gefilmtes Video ruhig zu stellen, bieten Videoschnittprogramme schon lange an. Was ist das Neue an ihrer stabilisierten Basketball-Szene?

Zhang: Anders als die klassische Videostablisierung erfassen wir Teile der Spielhalle in 3D. Wir könnten also auch eine völlig neue Kamerabewegung erzeugen.

Schönherr: Mit Ihren 15 Kameras können sie eine Szene in drei Dimensionen einfrieren. Ich kann das mit einer 500 Euro billigen 360°-Kamera auch.

Zhang: Schon. Aber auch die 360°-Kamera hat nur einen Blickwinkel, während wir mit unserem Experiment Raum plus Zeit erfassen.

Schönherr: Wenn sie sich in der KI-Szene umsehen, was da mit Video alles möglich wird – wohin geht die Reise?

Zhang: Erstens sehe ich, dass das neuronale Rendern räumlicher Szenen allmählich das Rendern von zweidimensionalem Videomaterial, zum Beispiel mit dem Grafikkartenprotokoll openGL ersetzt. Ich könnte mir auch vorstellen, dass der große Aufwand, Szenen in 3D am Computer zu erzeugen, etwa künstliche Schauspieler, sich durch die KI verändert. Polygonnetze, 3D-Szenendateien, Punktwolken werden nicht mehr so wichtig sein. Vielleicht werden wir real in 3D aufgenommene Personen rein Computergenerierte Szenen einsetzen können.

Schönherr: Brauchen wir mehr Computerpower, also Hardware, für diese künftigen KI-Anwendungen? Oder wäre es wichtiger, über KI-Software nachzudenken?

Zhang: Das ist eine philosophische Frage. Ich persönlich meine, dass die Hardware der Flaschenhals ist. Aber ich sehe auch, dass die meisten Forscher gar nicht so weit kommen, den Flaschenhals als solchen wahrzunehmen. Technisch ausgedrückt haben wir alle ähnliche Probleme mit dem NP-Problem der Komplexitätstheorie und noch keinen Weg gefunden, diese Komplexität in polynomialer Zeit zu lösen. Was ich aber auch sagen kann, ist, dass Deep Learning, also das Trainieren von KI-Software mit sehr vielen Daten, mit der Explosion der Computerpower einhergeht. Ohne unsere starken Grafikkarten, Prozessoren und 4K-Kameras hätten wir keine Chance gehabt, unsere Idee umzusetzen.

Äußerungen unserer Gesprächspartner geben deren eigene Auffassungen wieder. Der Deutschlandfunk macht sich Äußerungen seiner Gesprächspartner in Interviews und Diskussionen nicht zu eigen.