Manfred Kloiber: Wer regelmäßig die Hilfe von Suchmaschinen in Anspruch nimmt, der wundert sich über die seltsamen Ergebnisse bei der Bildersuche kaum noch. Denn bei der Bildersuche wird ja in der Regel gar nicht nach Bildern gesucht, sondern nach den Beschreibungen der Bilder - also nach dem im Beschreibungstext festgehaltenen Zusammenhang, in dem ein Bild im Internet erscheint. Und das führt dann oft zu schlechten Ergebnissen. Natürlich wird auch hier mit künstlicher Intelligenz an Optimierungen gearbeitet. Zum Beispiel, indem man mit Bildern als Suchvorlage sucht. Doch auch das hat seine Tücken. Diesen Ansatz hat nun eine Forschergruppe aus Jena um eine entscheidende Idee erweitert, die in der Fachwelt diskutiert wird. Den Informatiker Björn Barz von der Uni Jena habe ich gefragt, wie das Konzept zur Bildersuche aussieht.

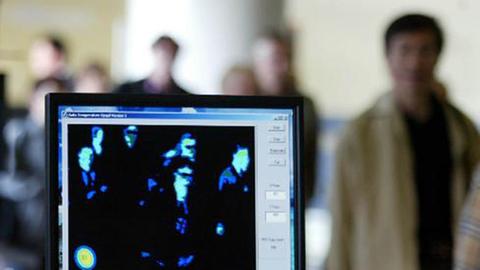

Björn Barz: Unser Ansatz ist, dass wir eben gerade auf diesen Umweg über den Text, über die sprachliche Beschreibung des Bildes verzichten. Stattdessen betrachten wir den Inhalt des Bildes selbst. Der Benutzer tritt also nicht mehr mit einem Schlüsselwort als Anfrage an die Suchmaschine heran, sondern mit einem Beispielbild und sagt der Maschine also: Ich habe hier dieses Bild und ich bin interessiert an Bildern, die diesen ähnlich sind. Die Maschine muss nun also auf der einen Seite das Bild des Benutzers semantisch in seiner Bedeutung erfassen, und auf der anderen Seite die Bilder in der Datenbank, im Internet und dann diejenigen zurück liefern, die ihres Inhaltes nach der Anfrage am ähnlichsten sind. Wir verzichten dabei also komplett auf Text.

Kloiber: Und was sind die Vorteile der Methode, Bilder mit Bildern zu suchen?

Barz: Zum einen, dass Sie diese Abhängigkeit vom Text nicht mehr haben. Sie sind nicht darauf angewiesen, dass irgendwer die Bilder im Internet mal akkurat beschrieben hat. Sie können die Analyse des Bildinhaltes selbst betreiben, das heißt die Maschine kann das betreiben. Und so können sie theoretisch auch alle Bilder finden, an denen Sie tatsächlich interessiert sind. Zum anderen nehmen sie dem Nutzer eine große Last ab. Er muss nämlich seine Anfrage nicht mehr in Sprache überführen, sondern er kann auch ganz komplexe Anfragen; wie etwa die nach dem Stil eines bestimmten Künstlers sehr kompakt in Form eines Beispielbildes repräsentieren.

Optische Ähnlichkeit allein ist unzuverlässig

Kloiber: Nun ist es ja so, dass Bilder zwar viel sagen, aber sie sagen immer noch nicht alles aus. Wie kann man denn sicherstellen, dass Ihre Bildersuche nicht nur optisch ähnliche Motive findet, sondern auch im Kontext richtige?

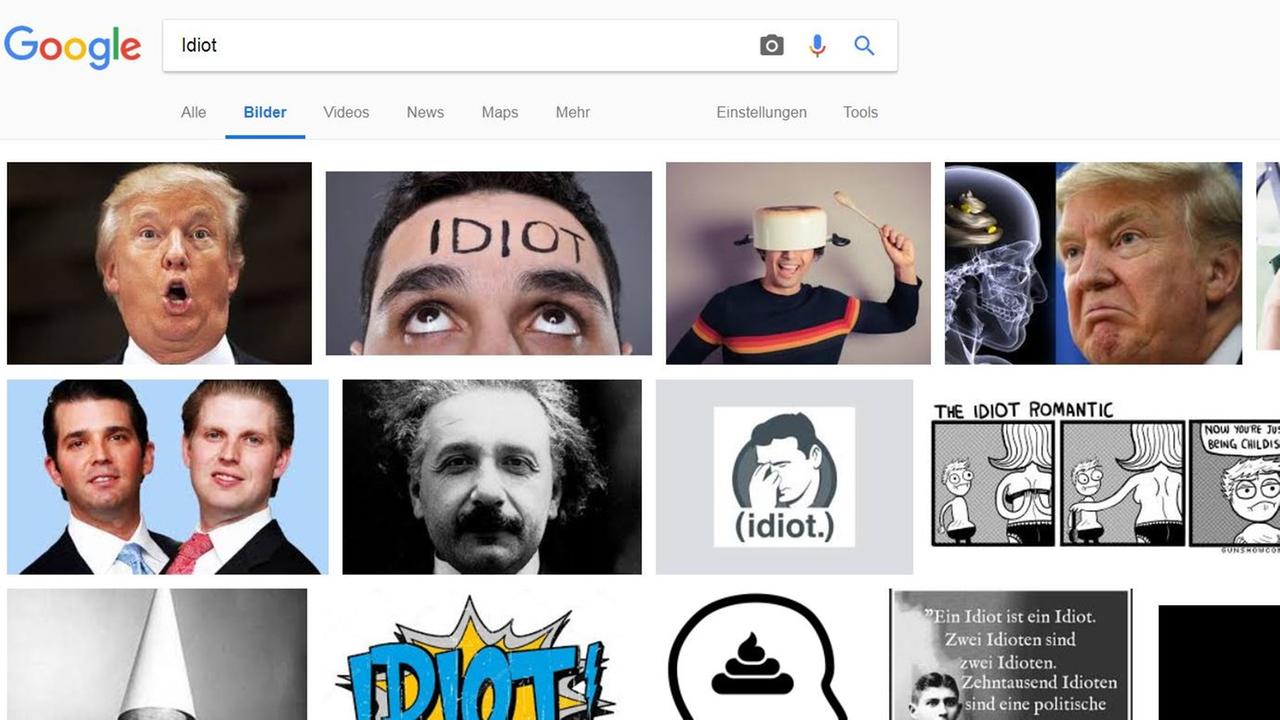

Barz: Dieses Prinzip der inhaltsbasierten Bildersuche, das ist an sich nicht so ganz neu; das ist schon ein Forschungsthema seit etwas über 25 Jahren. Und Sie finden das auch in Googles Bildersuche und auch in Microsofts Bing-Bildersuche gibt es eine Option dieser Rückwärtsbildersuche, wo man eben genau ein Bild hochlädt und das sucht dann nach ähnlichen Bildern. Bisher beschränkt sich das allerdings auf die optische Ähnlichkeit. Das führt dann zu Vergleichen, die unserer menschlichen Intuition nicht immer entsprechen. Zum Beispiel ist Google vor fünf Jahren mal in die Kritik geraten, weil die Google-Fotos-App Menschen mit dunkler Hautfarbe als Gorillas bezeichnet hat. Das war für die Maschine offenbar ein naheliegender Schluss allein anhand des Bildmaterials, dass diese beiden Kategorien sich ähneln. Aber mit unserer menschlichen Auffassung von den Konzepten der Welt hatte das nicht viel zu tun und wurde als beleidigend empfunden. Um das also zu vermeiden, wollen wir der Maschine ein bisschen was von unserer Gedankenwelt mitgeben.

Taxonomien zum Training der KI

Und das ist jetzt unser Ansatz: Verschiedene Disziplinen der Wissenschaft haben über Jahrzehnte die Dinge der Welt in eine Ordnung gebracht, in Kategorien auf verschiedenen Abstraktionsebenen einsortiert. Zum Beispiel ein Gorilla ist ein Affe ist ein Säugetier ist ein Tier und das ist ein Lebewesen und so weiter. Und so sind also Hierarchiebäume von Kategorien entstanden, und anhand dieser Taxonomien können wir semantische Ähnlichkeiten zwischen den Kategorien ableiten. Diese semantischen Ähnlichkeiten, die unserer menschlichen Auffassung entsprechen, die geben wir der Maschine zusätzlich mit. Sodass sie lernen kann, dass eben Menschen und Gorillas aus unserer Sicht nicht so ähnlich sind wie die Maschine das vielleicht denkt, sondern doch eher etwas weiter voneinander entfernt sein sollten aus semantischer Sicht.

Kloiber: Das würde aber bedeuten, dass die Bilder die gesucht werden, aber auch das Bild, was als Ausgangspunkt der Suche dient, eben kategorisiert sind, oder?

Barz: Für die semantische Bildersuche muss sie das gar nicht unbedingt. Was die Maschine im Endeffekt macht ist: Sie lernt jedes Bild durch eine Zahlenfolge zu repräsentieren. Und nun gibt es da zu Beginn eine Trainingsphase, wo man die Maschine also füttert mit Bildern, die mit einer Kategorie gekennzeichnet sind und zusätzlich diesen semantischen Relationen. Und dann lernt die Maschine währenddessen diese Zahlenfolgen zur Beschreibung der Bilder zu generieren, sodass die Bilder, die zu ähnlichen Kategorien gehören, auch durch ähnliche Zahlenfolgen beschrieben sind. Wenn das dann einmal getan ist, dann müssen Sie, wenn Sie die Maschine zur Bildersuche verwenden, die konkreten Kategorien gar nicht mehr ableiten können. Denn die Maschine repräsentiert dann jedes Bild durch eine Zahlenfolge, und die, die sich semantisch ähnlich sind, die sind sich auch anhand dieser Zahlenwerte ähnlich - ohne dass die konkrete Kategorie dafür bekannt sein muss.

Maschine lernt semantische Attribute selbst

Kloiber: Muss ich mir denn diese Zahlenwerke vorstellen wie eine Indexierung in einer Datenbank?

Barz: Im Prinzip können Sie sich diese Zahlenwerte tatsächlich als Attribute vorstellen. Da gibt es also eine bestimmte festgelegte Anzahl an Zahlen, und jede drückt irgendein Attribut aus. Und die werden also in der Datenbank gespeichert. Und wenn dann der Benutzer mit einer Anfrage kommt, berechnet die Maschine für dieses Bild die konkreten Attribute, also diese Zahlenwerte und vergleicht die mit denen in der Datenbank gespeicherten.

Kloiber: Das heißt, wenn ein Bild gefunden wird, wird es kategorisiert und wenn ich nach einem Bild suche, dann suche ich nach den Kategorien, die in etwa übereinstimmen sollten?

Barz: Der Clou ist: Die Maschine lernt diese Attribute selbst. Wir geben die Attribute nicht vor, die lernt sie aus einem initialen Datensatz, der bereits kategorisiert ist. Und sie lernt es in einer Weise, sodass sie anhand von diesen Attributen die zugehörige Klasse, die wir da noch kennen, möglichst gut vorhersagen kann. Und dann, wenn das einmal geschehen ist, dann genügt es uns für die Bildersuche einfach nur noch diese Attribute zu berechnen, ohne dann die Klasse daraus ableiten zu müssen. Die Maschine hat also gelernt, Bilder durch geeignete Attribute zu beschreiben. Die werden in der Datenbank gespeichert, und auch das Anfragebild wird dann in diese Attribute übersetzt, um es mit den gespeicherten vergleichen zu können.

Kloiber: Das war Björn Barz von der Universität Jena über Bildersuche mit Bildern.

Äußerungen unserer Gesprächspartner geben deren eigene Auffassungen wieder. Der Deutschlandfunk macht sich Äußerungen seiner Gesprächspartner in Interviews und Diskussionen nicht zu eigen.