CJ Carr: "Uns hat die Idee von dadaistischen Bots fasziniert, die sinnlose Kunst machen. Irgendwie fanden wir das lustig. Das hat uns angetrieben - und jetzt sind wir hier."

CJ Carr ist ein äußert sympathischer Nerd. Seine Haare sind genau so wirr wie seine Sprache. Er lacht viel, verliert sich ab und zu in Sätzen und wirkt manchmal so, als arbeite sein Kopf parallel schon wieder an neuen Projekten. Zusammen mit seinem Partner Zack Zukowski hat er vor Jahren die Dadabots ins Leben gerufen, ein neuronales Netzwerk, das Musik erzeugen kann. Er vergleicht es mit der Wettervorhersage, bei der ein Programm, basierend auf Beobachtungen der Tage vorher, das Wetter der kommenden Tage errechnet.

Eine neue Herangehensweise

Carr: "Wir benutzen ein ähnliches Modell und wenden es auf die Klangwellen an. Wir fragen uns: Wenn die Wellenformen der Musik ein bestimmtes Muster auf dem gesamten Album haben, was wäre dann eine zehntägige Vorhersage für dieses Album? Wohin würde der Klang? als nächstes gehen? Da gibt es natürlich keine eindeutige Antwort drauf, aber man könnte eine plausible Vorstellung davon entwickeln, was mit der Musik als nächstes passiert. Und das hört man dann."

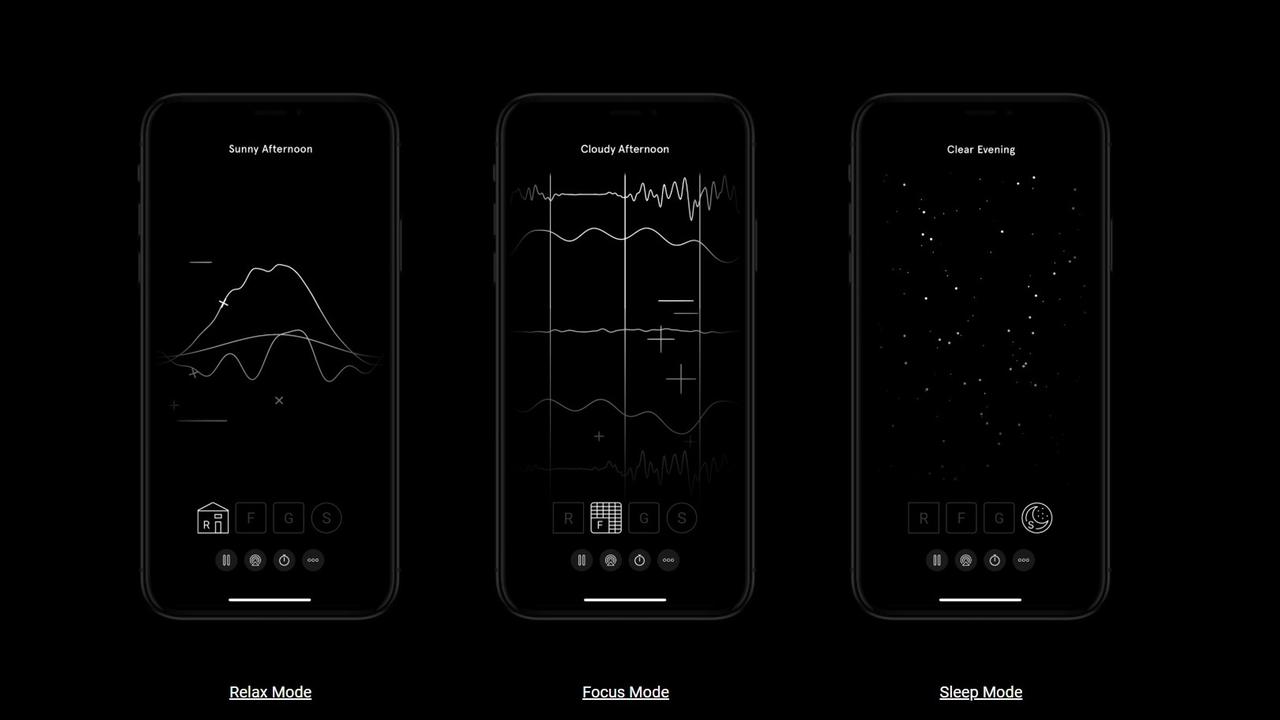

Die Herangehensweise unterscheidet sich stark von Künstlicher Intelligenz, die zum Beispiel Apps wie Endel, Jukedeck oder Amper verwenden. Diese Anbieter nutzen das musikalische Wissen von Entwicklern und Musikwissenschaftlern. Sie sagen der Künstlichen Intelligenz, welche Sound-Muster bestimmte Künstler oder Epochen der Musikgeschichte haben und speisen mit diesen Informationen die Künstliche Intelligenz.

Carr: "Wir haben einen völlig unkonventionellen Ansatz, den wir ‚Unbeaufsichtigtes Lernen‘ nennen. Das Netzwerk weiß überhaupt nichts über Musiktheorie. Es bekommt die rohen Wellenformen und registriert nur den Ausschlag davon, also wie sich Höhen und Tiefen abwechseln. Und dann schaut es noch auf die Abtastrate, mit der der Klang aufgenommen wurde."

Das neuronale Netzwerk macht sich also ein eigenes Bild von der Musik. Es beobachtet die Songs wie ein kleines Kind. So lernt es selber, Musik zu schreiben.

Experimente mit Beatles-Songs

Carr: "Es ist in der Lage, Schlagzeugsounds, die Klangfarbe des Gesangs oder Gitarren zu erkennen. Das ist bemerkenswert. Es ist gut in einigen Sachen! Bei anderen versagt es aber auch."

So wie bei Riffs oder eigenen Melodien. Da klingt die KI-Version schon sehr stark nach dem Original. Gefüttert wird die Künstliche Intelligenz mit Alben von bekannten Künstlern, etwa "One" von den Beatles.

Mit jedem Durchlauf starten die Dadabots einen neuen Versuch, selber Songs auf dieselbe Art und Weise zu schreiben. Anfangs entsteht meistens klanglich ein Chaos. "Deep The Beatles" heißt ein Album, das diesen Lernprozess dokumentiert. Song Nummer eins klingt so (Soundbeispiel). 19 Versuche später hört sich die Musik deutlich strukturierter an.

24 Stunden lang Death Metal

Wichtig ist CJ Carr dabei die Tatsache, dass Songs nicht einfach kopiert werden. Andere Künstliche Intelligenzen versuchen, menschliche Musik zu machen, kritisiert er. Bei den Dadabots dagegen höre man, wie eigenschöpferisch die Musik des neuronalen Netzes klingt. Wie gut das funktioniert, kann man sich aktuell bei YouTube unter "Relentless Doppelganger" anhören. Der Dadabots-Livestream produziert 24 Stunden lang Death Metal.

Am beeindruckendsten ist aber die Zusammenarbeit mit dem Beatboxer Reeps One. Der Engländer hat das Netzwerk tagelang mit seinen Sounds gefüttert. Die besten Reaktionen der Künstlichen Intelligenz wurden ausgewählt, mit anderer Musik unterlegt und zu einem Song verarbeitet. "Reeps One ft. A.I. – Second Self" heißt das Stück, das man sich auch als Video anschauen kann. Der Musiker steht in einem riesigen schalldichten Raum. Er beatboxt und wartet auf die Antwort der KI. Das neuronale Netzwerk erklingt, ein Kreis flackert dazu hell an der Wand, während Reeps One ihm zuschaut.

Beim Betrachten der Bilder hat man das Gefühl, die Künstliche Intelligenz erwacht zum Leben. Und genau das macht diesen Ansatz so interessant: Andere KI-Musikprogramme funktionieren nach strengen Regeln und Algorithmen. Ihnen wird gesagt, was sie zu tun haben. Dadabots aber lernen, indem sie selber beobachten. Es wird spannend sein, welche sie Musik nach der Sichtung vieler unterschiedlicher Stile in Zukunft noch schreiben werden.

Carr: "Reeps One hat das neuronales Beatboxing sozusagen als Embryo gesehen. Man kann sehen, wie es lernt und versucht, zu imitieren, aber auch wie es dabei kämpft. Man entwickelt da irgendwie Mitgefühl."