Arndt Reuning: "DeepMind", so heißt das Tochterunternehmen von Google, das auf die Entwicklung von KI, von "Künstlicher Intelligenz" spezialisiert ist. Und die Programmierer dort konnten in den letzten Jahren regelmäßig spektakuläre Erfolge beim Wettkampf "Mensch gegen Computer" präsentieren: Zuerst bei den klassischen Denkspielen Schach und Go, dann beim Computer-Strategiespiel "StarCraft" – gegen die "DeepMind"-KIs haben selbst die besten menschlichen Profi-Spieler keine Chance mehr. In der aktuellen Ausgabe des Fachblatts "Science" stellen DeepMind-Programmierer ihren neuesten Streich vor: Eine KI, die den 3D-Shooter "Quake 3" spielt, natürlich wieder einmal auf "übermenschlichem" Niveau. Bei mir ist mein Kollege Michael Gessat – diese Shooter mit der Spielfigur in der Ich-Perspektive, manche Leute sprechen da ja auch einfach von "Killerspiel", die gelten ja nicht als intellektuell übermäßig komplex – wo ist denn da die Herausforderung für eine KI?

Michael Gessat: In der Tat ist "Quake 3" zunächst einmal sogar ein relativ simpler 3D-Shooter – das Spiel stammt ja aus dem Jahr 1999; und inzwischen sind natürlich aktuelle Spiele des Genres von der Grafik und den Bewegungsmöglichkeiten der Spielfigur her deutlich komplizierter geworden. Grundsätzlich läuft man ja in so einem Shooter in einer 3D-Landschaft oder einem Gebäude herum, man selbst schießt mit verschiedenen Waffen mit Nah- oder Fernwirkung und unterschiedlicher Schadenswirkung auf Gegner und wird von denen unter Beschuss genommen. Die "DeepMind"-Programmierer haben ihre KI aber hier eine ganz spezielle Shooter-Variante spielen lassen, die heißt "Capture the Flag", und da spielen Teams mit- bzw. gegeneinander. Ziel ist es, die gegnerische Flagge zu erobern und in die eigene Basis zu tragen, dann gibt es jeweils einen Punkt.

Koordiniert und kooperativ

Reuning: Das heißt, bei "Capture the Flag" geht es sehr stark um die Kooperation mit den eigenen Teammitgliedern; und ein gegnerisches Team, das ebenfalls koordiniert vorgeht, versucht, das zu durchkreuzen?

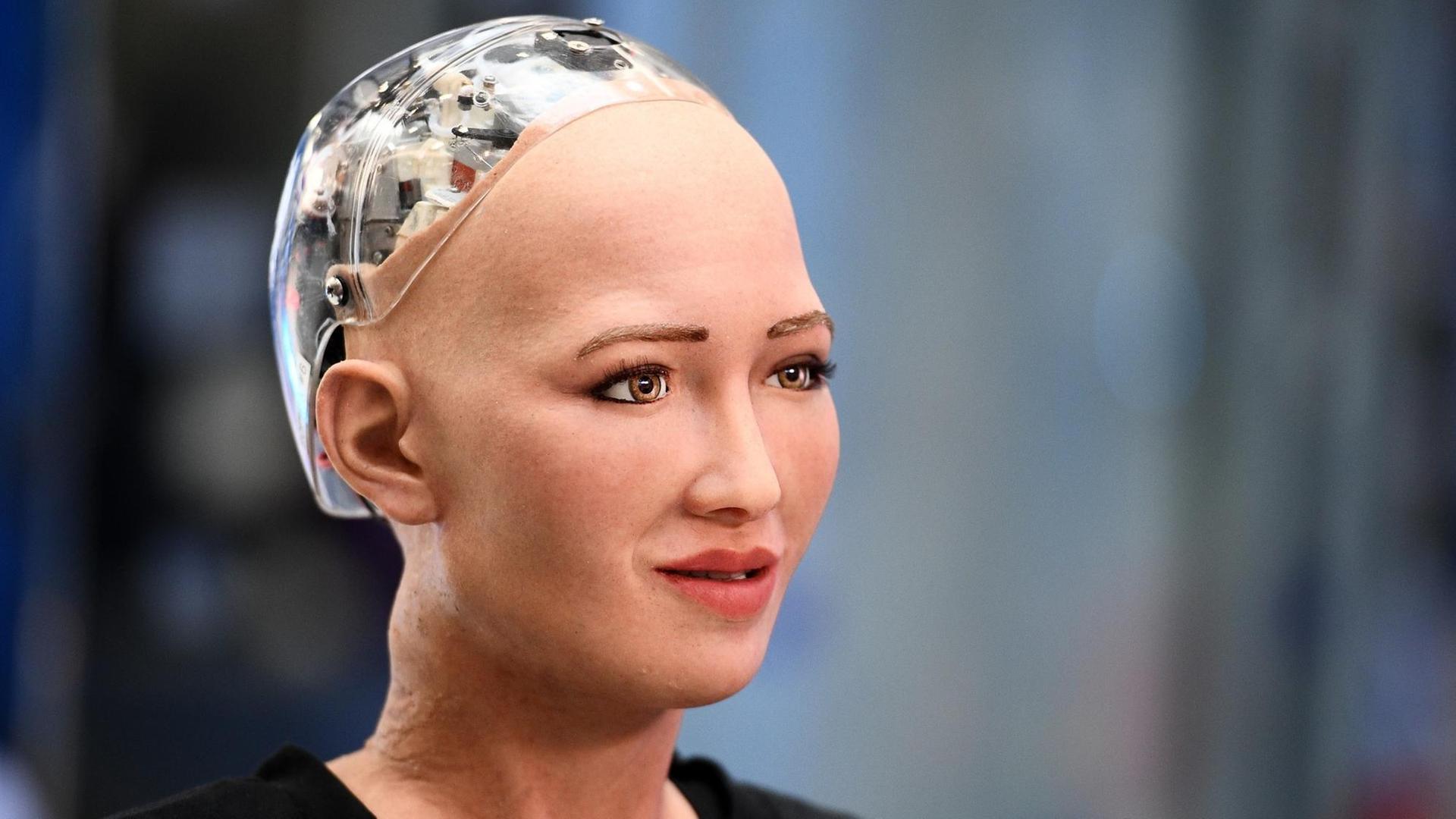

Gessat: Ganz genau, und das ist eine sehr komplexe Herausforderung, weil ja alle Spieler autonom sind und autonom Entscheidungen treffen. Die Programmierer haben nun ihre KI-Software – die beruht ja auf einem sogenannten künstlichen neuronalen Netz – zunächst mal auf die gleiche Weise trainiert wie seinerzeit bei dem Go- oder Schachprogramm: Durch reines learning by doing. Das neuronale Netz spielt ohne jedes einprogrammiertes Vorwissen einfach los, hunderttausende Male. Und lernt durch Erfolg beziehungsweise Misserfolg. Man spricht hier von "Reinforcement Learning". Kleines Beispiel: Wenn ein Gegner auf mich schießt, ist es offenbar eine gute Idee, seitwärts auszuweichen, das behalte ich bei.

Reuning: Und diese Methode funktioniert also von solchen ersten Spiel-Basics bis hinauf zur komplexen Strategien?

Gessat: Offenbar. Das Training ist ja eine Art evolutionärer Prozess, die Programmierer haben verschiedene Instanzen und Varianten dieser kleinen neuronalen Netze; sie sprechen hier von "Agents", immer wieder untereinander antreten lassen, und dann kristallisierten sich eben allmählich die besten heraus. Und diese "For-the-Win"-Agents spielen besser als menschliche Profispieler, und zwar sowohl in einem reinen Agenten- als auch in einem gemischten Mensch-Maschine-Team.

Strategien wie menschliche Spieler

Reuning: Spielen die Agents denn irgendwie anders als Menschen, kann man die am Verhalten erkennen?

Gessat: Interessanterweise entwickeln die ganz ähnliche Strategien wie menschliche Spieler, beispielsweise ins leere gegnerische Camp zu laufen und dort abzuwarten, bis die Flagge dort nach dem Abschuss eines Flaggenträgers wieder auftaucht. Was ich ganz besonders spannend finde: bei den Schach- und Go-Algorithmen, da blieb die KI ja letztlich eine Black Box, da konnten die Programmierer selbst nicht genau sagen, wie der Algorithmus zu einer konkreten Entscheidung kommt. Hier nun haben sie in die Agents hineingeschaut und konnten die neuronalen Zustände oder Verschaltungen mit ganz konkreten Spiel-Zuständen in Verbindung setzen. Und da haben sie zum Beispiel festgestellt: Bei den erfolgreichen Agents war die essenzielle Information "ist die Flagge gerade im eigenen oder gegnerischen Besitz?" höchst effizient in einem Neuron kodiert - das erinnert schon sehr stark an biologische Vorbilder.

Reuning: Mal über den Tellerrand geschaut: Ist die Methode, dieses selbstverstärkende Lernen von KI-Agents irgendwie übertragbar auf andere Szenarien, auf die Realität womöglich?

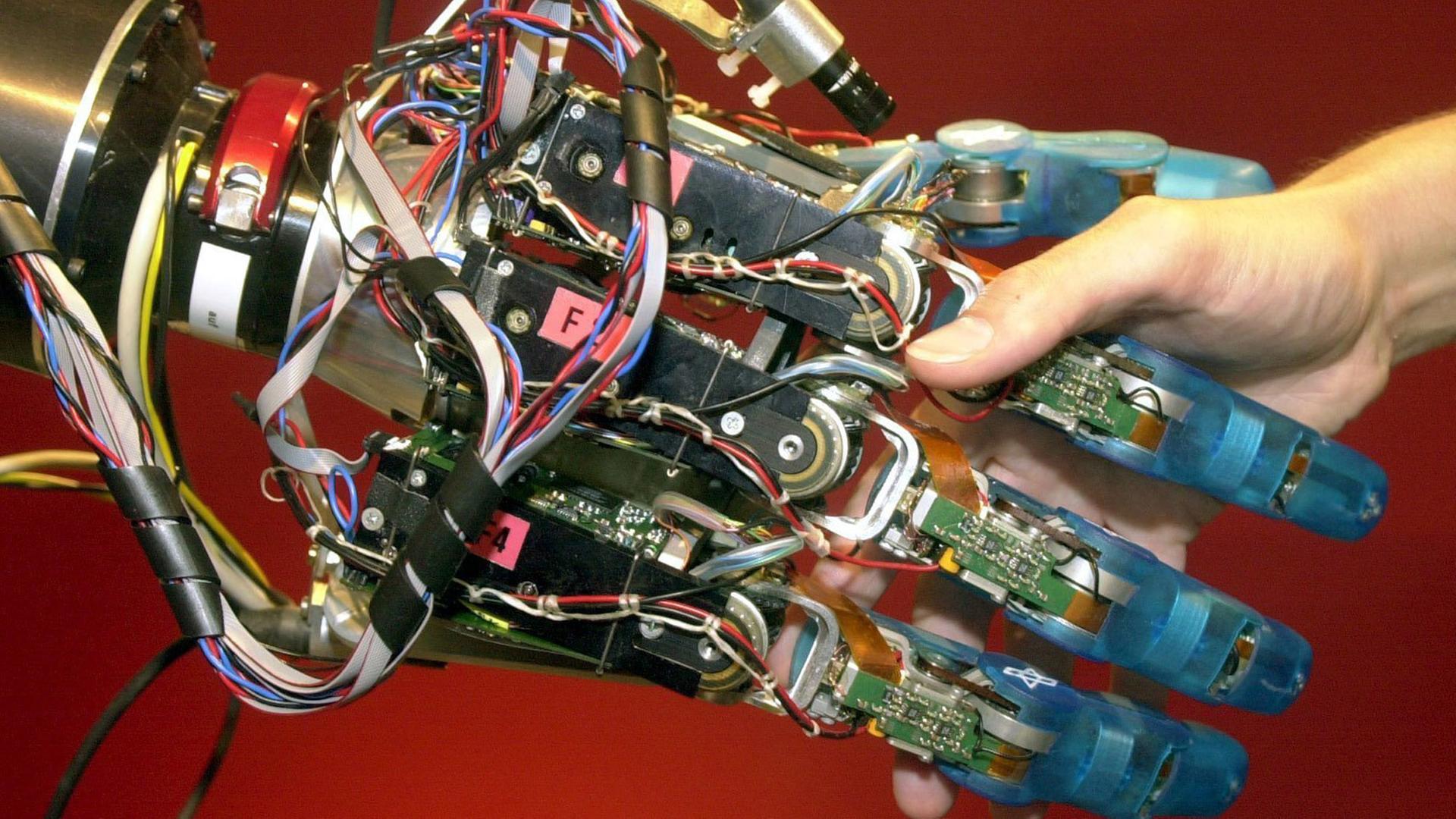

Gessat: Der Hauptautor des Science-Papers hat sich auf diese Frage extrem bedeckt gehalten und das so formuliert, dass da sicher einige Komponenten auf andere Szenarien übertragbar sein könnten. Ich selbst würde einmal spekulieren; letztlich ist das eine Frage der Zeit und Rechenkapazität, das Trainings-Szenario der Realität anzunähern. Und attraktive Einsatzgebiete für autonom und kooperativ handelnde Agents oder Roboter fallen einem auch sofort ein: Rettungs- oder Weltraummissionen, aber leider auch kriegerische Auseinandersetzungen.