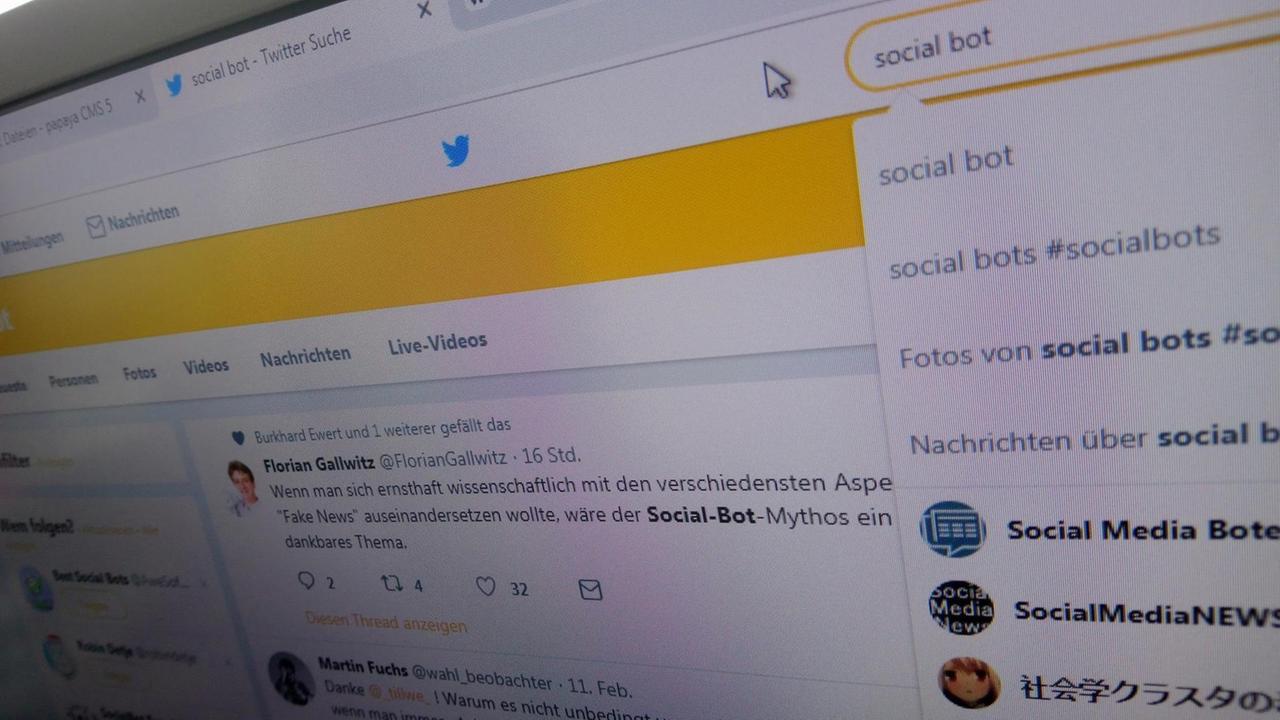

Bettina Schmieding: "Robot" ist das englische Wort für Roboter. Eine Kurzform ist der sogenannte Bot. Ein Begriff, der seit der Erfindung der sozialen Medien Karriere gemacht hat. Social Bots sind Computerprogramme, denen Programmierer bestimmte Aufgaben geben, die sie dann automatisiert ausführen, wie Roboter eben. Und weil es gar nicht so schwierig ist, so einen Bot zu programmieren, gibt es sie zuhauf. Wenn Bots in den sozialen Medien unterwegs sind, heißen sie Social Bots. Dort suchen sie nach Schlüsselwörtern. Die "Premium"-Bots können sogar einfache Antworten selber schreiben, die Standardmodelle jagen konfektionierte Sätze in die Welt. Und jetzt kommen wir zu den Chancen und Risiken. In sozialen Netzwerken tun diese Bots häufig so, als wären sie echte Nutzer. Die Frage ist, wie einflussreich sind diese Bots, können sie wirklich Stimmungen verändern? Eine Studie der Universität Duisburg-Essen kommt zu dem Schluss: Ja, sie können.

Herr Ross, der Projektleiter, wie haben Sie das herausgefunden?

Björn Ross: In unserer Studie geht es darum, wir haben uns gefragt, wie können Social Bots dann solchen Einfluss ausüben auf die Meinungsbildung online? Also, wir stellen uns einen Meinungsbildungsprozess vor, beispielsweise die Diskussion zu einem kontroversen Thema, wo die Meinungen 50:50 verteilt sind. Die eine Hälfte ist der einen Meinung, die andere Hälfte ist der anderen Meinung. Können in solchen Situationen Social Bots das Zünglein an der Waage sein? Und, wenn ja, inwiefern? Und welche Parameter und Faktoren begünstigen oder hemmen das? Das sind die Fragen, denen wir uns gewidmet haben. Und wir haben dazu also eine Simulation durchgeführt. Wir wollten schauen, gibt es eigentlich eine theoretische Fundierung dafür, dass tatsächlich Bots einen Einfluss auf diesen Meinungsbildungsprozess ausüben können? Daher haben wir die Theorie, die in der Kommunikationswissenschaft etabliert ist oder sehr bekannt ist, die "Schweigespirale", simuliert. Und diese Theorie sagt, dass Menschen Angst haben, von ihrem Umfeld isoliert zu werden, wenn sie ihre Meinung äußern und diese Meinung von ihrem Umfeld nicht geteilt wird. Und wenn das genug Personen tun, führt das dazu, dass diese Meinung, diese eine, nicht mehr öffentlich geäußert wird. Und die andere Meinung – scheinbar – zum gesellschaftlichen Konsens wird.

Schmieding: Und dann haben Sie mit Bots dagegengehalten? Und am Ende kam dabei heraus, dass die Schweigenden noch schweigender wurden?

Ross: Am Ende kommt dabei heraus, genau, das ist ja eine Grundannahme der "Schweigespirale", dass die Personen, deren Meinung nicht vertreten wird, die sich mit der Gegenmeinung konfrontiert sehen, dass die dann aufhören, ihre eigene Meinung zu vertreten. Das ist eine Annahme, die wir da auch getroffen haben. Was herauskam, und was uns auch überrascht hat, wie wenige Bots notwendig sind, um so einen Effekt bereits zu erzielen. Dabei ging es in unserer Studie auch darum, verschiedenen Faktoren zu identifizieren, die das also begünstigen oder hemmen. Und ein Ergebnis ist zum Beispiel: Ganz wichtig ist, ob die Bots so agieren, dass sie von Menschen auch wie andere Menschen behandelt werden, also Menschen sich von ihnen beeinflussen lassen. Und wenn man davon ausgeht, dass Bots Menschen in dem gleichen Maße beeinflussen, wie sich Menschen auch von anderen Menschen beeinflussen lassen, dann ist es tatsächlich so, dass nur relativ wenige Bots notwendig sind, um die Stimmung zu kippen.

"Auch berechtigte Kritik"

Schmieding: Wir haben in den sozialen Medien perfiderweise, das ist ja auch etwas, um das es bei Ihnen geht, Kritiker, die ihre Methode infrage stellen. Ich nehme nicht an, dass das Bots waren, die das getan haben. Sie gehen ja von einer simulierten Situation ohne Menschen aus, also 50 Prozent einer Situation positiv gegenüber, 50 Prozent negativ. Ist das überhaupt realistisch? Kann man menschliches Verhalten simulieren?

Ross: Ja, das ist sicher auch berechtigte Kritik, damit muss man rechnen. Ich würde sagen, dass das Hauptziel unserer Studie nicht war, herauszufinden, ob, wenn ich jetzt genügend Social Bots in so ein Netzwerk einfüge, irgendwann die Stimmung der Personen, die im Netzwerk miteinander diskutieren, kippen lässt. Das ist offensichtlich: Wenn ich genügend Bots einfüge, dann wird das irgendwann passieren. Wenn ich dazu nämlich noch annehme, dass sich die Menschen eben auch von den Bots beeinflussen lassen. Das ist eine wichtige Annahme. Und das ist auch sicherlich wichtig und richtig, diese Diskussion zu führen und sich zu fragen: Ist das eigentlich der Fall? Aber das war eben nicht das Ziel von unserem Artikel. Sondern die Frage ist: Unter welchen Voraussetzungen kann es denn besonders effektiv passieren? Von welchen Variablen hängt der Einfluss von Bots ab? Und da haben wir eben herausgefunden, dass eine der Hauptvariablen ist, dass sich Menschen eben von Bots so stark beeinflussen lassen, wie wir es herausgefunden haben, auf der gesamtgesellschaftlichen Ebene. Dass sich dann ein Scheinkonsens herausbildet, der von den Bots propagiert wird, wenn der einzelne Mensch nicht mehr erkennen kann, ob es sich bei einem Nutzer um einen Bot handelt oder nicht. Ich glaube nicht, dass wir da schon sind. Damit haben die Kritiker absolut recht, dass wir also noch nicht in einer Situation sind, wo ich als Nutzer eines sozialen Mediums nicht erkennen kann, ob es sich bei dem anderen Profil, das ich sehe, tatsächlich um ein Bot handelt oder nicht.

"Es gibt auch sehr sinnvolle Bots"

Schmieding: Sie sagen also, wenn ich Sie richtig verstanden habe, dass Sie einen Beleg dafür gefunden haben, dass so Social Bots tatsächlich Debatten verfälschen könnten. Was ist zu tun? Selber welche schreiben? Oder dagegenhalten?

Ross: Das ist eine gute Frage. Ich denke, da müssen wir auch noch eine Menge interessanter Diskussionen führen. Nehmen wir mal an, wir schreiben jetzt selber Bots. Ist das ethisch überhaupt noch vertretbar?

Schmieding: Was macht uns dann besser?

Ross: Ja, genau. Wenn irgendwann die Diskussion in den Sozialen Medien nur noch über solche Bots geführt werden, dann bringt uns das sicherlich auch nicht weiter. Ich denke, was passieren sollte, dass wir uns ganz klar darüber werden müssen, was für Bots wollen wir eigentlich und was für Bots nicht? Es gibt ja auch sehr sinnvolle, nützliche Bots, zum Beispiel welche, die regelmäßig Katastrophenmeldungen automatisiert verbreiten. Welche Bots wollen wir? Und welche wollen wir nicht? Und diejenigen, die wir nicht wollen, dass beispielsweise auch transparent werden muss, von wem werden die eigentlich finanziert, beispielsweise von welchen politischen Mächten. Und die dann entsprechend zu löschen.

"Angst beflügelt dann die Berichterstattung"

Schmieding: Kritik gibt es ja auch an der undifferenzierten Berichterstattung über Ihre Ergebnisse. Ich weiß, dafür sind Sie als Informatiker gar nicht zuständig, aber vielleicht haben Sie eine Meinung: Warum greifen Medien so gerne zu Neuigkeiten aus Ihrer Disziplin? Gerade, wenn es um Bots geht. Ist das irgendwie dieses journalistische Unwohlsein, wenn es um Einfluss von Algorithmen geht?

Ross: Ich kann mir vorstellen, dass es da in der Bevölkerung eine gewisse Angst gibt und auch ein gewisses Gefühl von Ohnmacht gegenüber diesen neuen Technologien, mit denen viele das Gefühl haben, man noch nicht so recht umgehen kann. Und dass diese Angst dann die Berichterstattung entsprechend beflügelt und auch die Reaktionen auf die Berichterstattung.

Äußerungen unserer Gesprächspartner geben deren eigene Auffassungen wieder. Der Deutschlandfunk macht sich Äußerungen seiner Gesprächspartner in Interviews und Diskussionen nicht zu eigen.