Manfred Kloiber: Forscher der University of Massachusetts in Amherst haben sich die Frage gestellt, ob Software diskriminierend sein kann - ob Computerprogramme schwarze Bürger zum Beispiel schlechter behandeln als weiße. Oder ob Frauen bei einer automatischen Entscheidung schlechter abschneiden als Männer. Um die Antwort vorweg zu nehmen: Ja, Software kann Diskriminieren - und das, obwohl die Hersteller das am liebsten unter allen Umständen verhindern wollen. Verhindern kann man aber nur etwas, was man kennt. Deshalb haben die Wissenschaftler ein System entwickelt, das auf Diskriminierung testen soll. Es heißt Themis, und der Mitentwickler Yuriy Brun hat mir erklärt, wie es funktioniert:

Yuriy Brun: Wir haben beobachtet, dass Software-Unternehmen oft Programme herausbringen, ohne zu wissen, ob die Software diskriminiert. Das ist ja meist auch nicht ihre Absicht. Aber sie haben keine Möglichkeit, das zu testen, bevor sie die Software freigeben. Also haben wir überlegt, wie man Software auf Diskriminierung testen könnte. Und dann kam uns die Idee des Kausal-Tests. Beim Kausal-Test überprüft man die Software für jede Eingabe zweimal. Zum Beispiel eine Software für die Kreditvergabe, die eine Empfehlung abgibt, einer Person einen Kredit zu geben oder eben nicht.

Im Test füttere ich die Software mit einem Datensatz, bei dem mich aber nur ein Merkmal interessiert, nur die Rasse zum Beispiel. Dann lasse ich die Software erneut laufen mit einem neuen Eintrag bei der Rasse. Und wenn ich jetzt herausfinde, dass diese Software im ersten Fall ein Darlehen empfiehlt, im zweiten Durchlauf aber nicht, dann weiß ich, dass die Rasse eine Rolle spielt. Das ist natürlich nur ein Datenpunkt. Also teste ich das viele Male für viele Datenpunkte und kann so messen, wie die Software auf der Grundlage von Rasse oder Alter oder irgendeinem anderen Eingabe-Attribut Unterschiede macht.

Minderheiten werden nicht am gleichen Tag beliefert

Kloiber: Und warum ist es denn wichtig, dieses diskriminierende Verhalten aufzudecken?

Brun: In den letzten paar Jahren gab es eine Menge von Artikeln über Software, die diskriminierende Entscheidungen traf, ohne dass es dem Hersteller bewusst war, weil sie auch nicht testen konnten. Ein Beispiel: Letztes Jahr hat Amazon eine Software dazu eingesetzt, zu entscheiden, in welchen Gebieten sie "Lieferung am selben Tag" in den USA anbieten sollen. Die Software hat sehr viele unterschiedliche Daten analysiert. Und sie entschied, dass der Dienst in einigen Wohngegenden angeboten werden soll, in anderen aber nicht.

Es zeigte sich, dass überwiegend von Minderheiten bewohnte Gegenden nicht bedient werden sollten, auch wenn um sie herum wohlhabende Gebiete lagen. Die wohlhabenden Gegenden allerdings sollten bedient werden. Das war Amazon vorher nicht klar und sie hätten das wahrscheinlich vorher lieber getestet.

Ein anderes Beispiel: In Amerika verwenden zwölf Staaten jetzt Software, um vorherzusagen, wie wahrscheinlich ein Angeklagter rückfällig wird. Diese Information wird für die Urteilsfindung oder für die Kautionsentscheidung benutzt. Auch diese Software machte rassistische Entscheidungen. Natürlich macht eine Vorhersagesoftware Fehler. Aber diese scheint Fehler zu machen, die Weiße bevorzugt und schwarze Menschen benachteiligt.

Geschlechtsneutral, aber "rassistisch"

Kloiber: Das waren zwei Beispiele für Software, die gegen Diskriminierung überprüft werden sollte. Gibt es noch mehr Beispiele, die mit Themis getestet werden könnten?

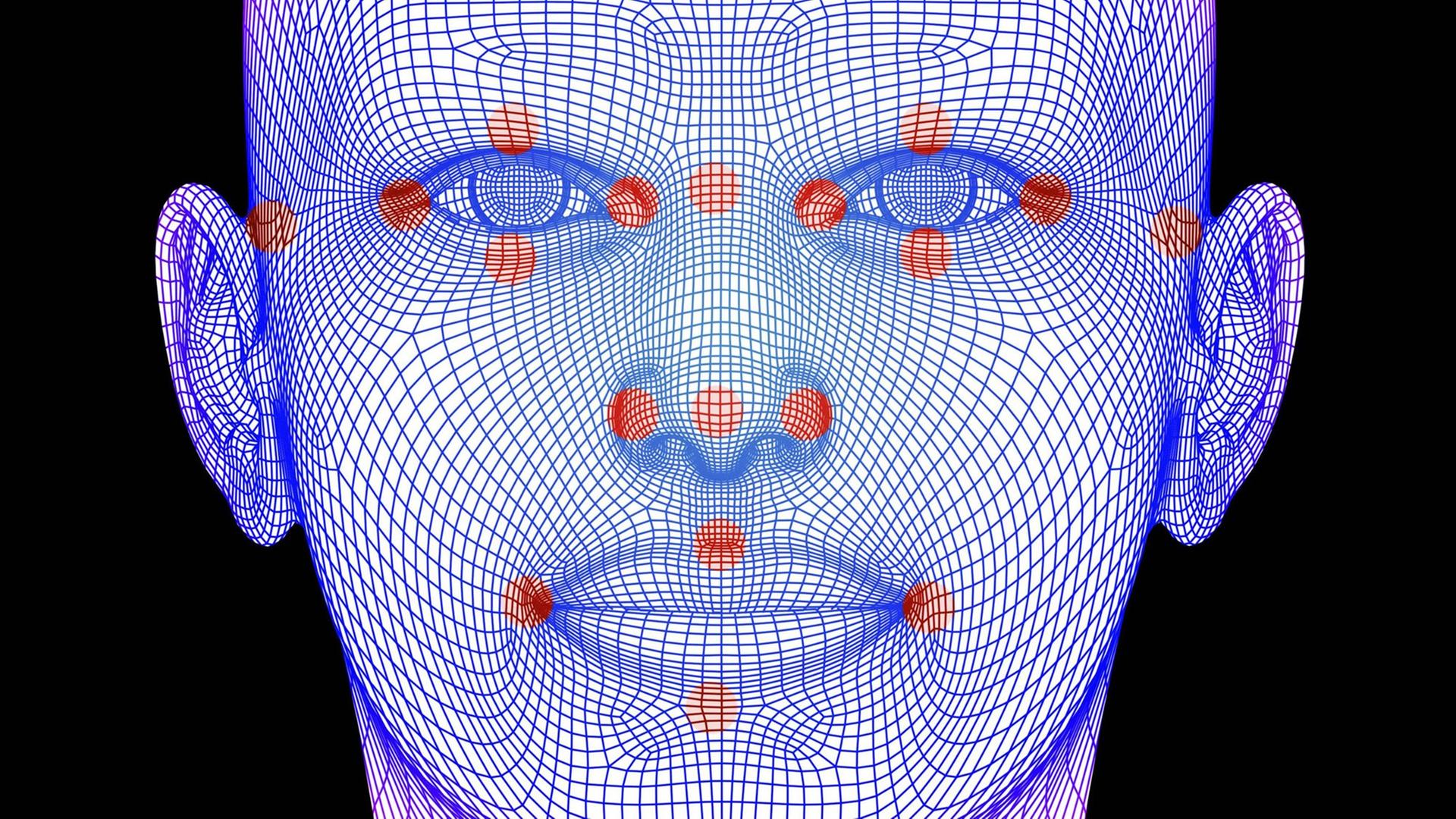

Brun: Noch kann unser System noch nicht alles prüfen, aber wir arbeiten dran. Im Prinzip funktioniert Themis immer dann, wenn die Eingabe eine Liste von Parametern oder Zahlen ist. Und der nächste Schritt ist, auch komplexere Eingabe, zum Beispiel Fotos per Gesichtserkennung zu ermöglichen. Im Moment arbeitet Themis aber noch nicht mit solchen Daten. Sondern nur mit Zahlenkolonnen oder mit einfachen Texteingaben. Aber da arbeiten wir dran.

Kloiber: Haben sie denn Themis schon unter echten Bedingungen getestet?

Brun: Ja, wir haben Themis schon mit einem ganzen Bündel von Programmen getestet, die wir auf der Open Source Plattform GitHub vorgefunden haben. Sie benötigen zum Testen ja nur das lauffähige Programm und nicht den Quellcode. Leider haben wir keinen Zugriff auf die Programme, die zum Beispiel in Banken für die Kreditbewertung laufen, oder auf die Software, die Amazon benutzt hat. Also haben wir Open Source Programme untersucht. Acht verschiedene, die sich mit Einkommensprognosen oder Kreditwürdigkeit beschäftigen. Und wir haben vier weitere Programme getestet, die explizit nicht-diskriminierende Entscheidungen treffen sollten. Bei den acht haben wir überprüft, ob Themis überhaupt funktioniert, also Diskriminierung erkennt - mit positivem Ergebnis.

Besonders interessant aber war ein Programm, das extra so programmiert war, dass es geschlechtsdiskriminierende Entscheidungen verhindert. Da haben wir eine überraschende Beobachtungen gemacht: Ausgerechnet das System, dass geschlechtsneutral arbeiten soll, stellte sich in Bezug auf die Rasse als diskriminierend heraus - in rund 38 Prozent der Fälle.

Kloiber: Das war Yuriy Brun von der University of Massachusetts in Amherst über diskriminierende Software und wie man sie testen kann. Das Interview haben wir aus technischen Gründen vor der Sendung aufgezeichnet.