"Stellen Sie sich ein gigantisches Raumschiff vor, so groß, dass die ganze Menschheit darin Platz hat. Und obwohl die Konstruktion noch nicht fertig ist, hat das Einsteigen schon begonnen. Alle sind aufgeregt wegen der bevorstehenden Reise."

Vergangene Woche auf einer NATO-Konferenz in Estland. Jaan Tallinn, Hightechinvestor und Miterfinder der Kommunikationsplattform Skype, hat das Schlusswort. Viele der versammelten Militärs, Techniker und Wissenschaftler wirken ein wenig verblüfft.

"Irgendetwas stimmt nicht. Das Projekt verschlingt Milliarden Dollar und Millionen Arbeitsstunden. Doch da gibt es eine kleine Gruppe von Leuten, die verzweifelt auf ein Problem hinzuweisen versucht: Niemand arbeitet an einem Steuerungsmechanismus."

Das Riesenraumschiff ohne Lenker – eine Metapher für den sich beschleunigenden Fortschritt auf dem Gebiet der KI, der Künstlichen Intelligenz. Tatsächlich reden KI-Forscher gern vom Takeoff. So bezeichnen sie den Moment, da ihre Maschinengeschöpfe wirklich selbstständig handeln können.

Klischee aus Science-Ficition-Filmen

Schon ist der Mensch daran gewöhnt, dass Maschinen sein Auto montieren, im OP mitoperieren und ihn beim Schachspiel besiegen. Bald sollen Autos selbst zu intelligenten Maschinen mutieren, die ihre menschliche Fracht eigenständig chauffieren. Immer schlauere Roboter sollen für den Menschen bauen, schleppen, kochen, investieren, ihn unterrichten, unterhalten, pflegen. Und töten?

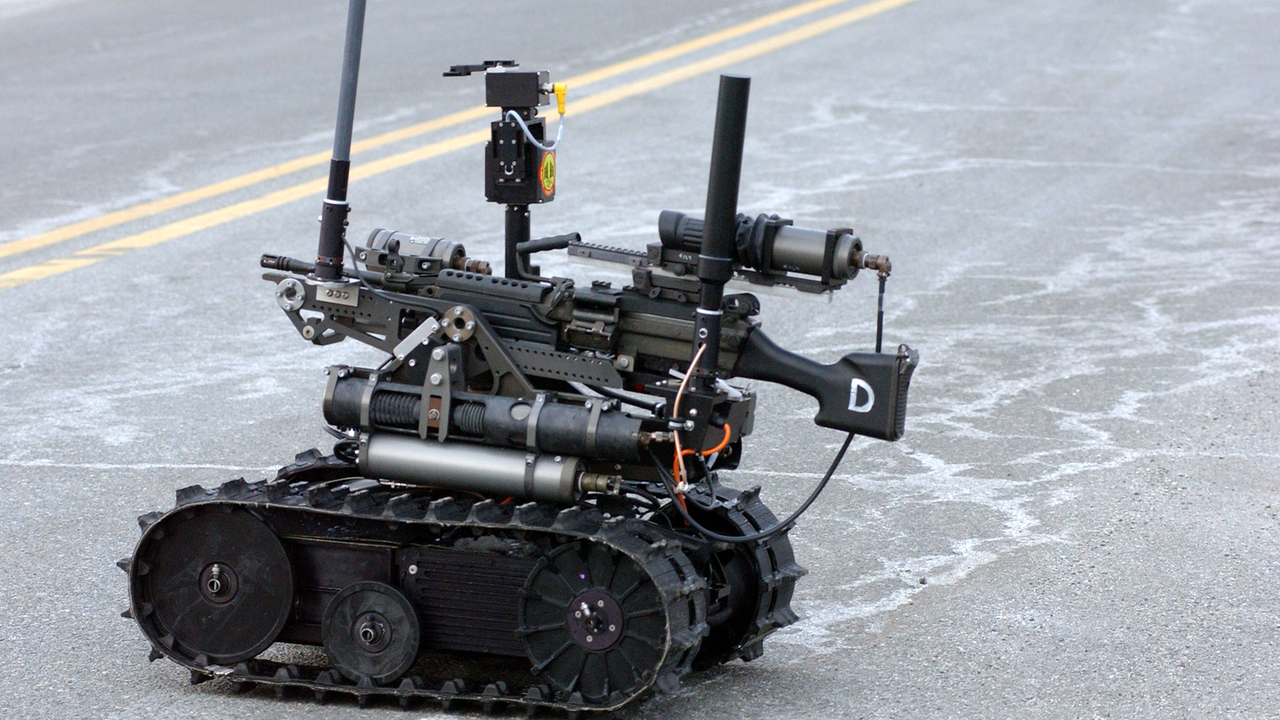

Bewaffnete Kampfroboter: Das wirkt fast schon wie ein Klischee aus Science-Fiction-Romanen und Hollywood-Produkten. Was heute noch wie ein Märchen klingt, kann morgen Wirklichkeit sein. Schon 1966 ließ das deutsche Fernsehen die Raumpatrouille Orion ausschwärmen. Schwarzweiß, aber interstellar.

"Mein Gott, Hasso, was war das für ein Wesen? Auf jeden Fall kein Mensch. Wie die Strahlen einfach durch ihn hindurchgingen."

1984 hatte Arnold Schwarzenegger sein Debüt als Killer-Roboter, als Terminator. Es gibt sie schon: die ersten weitgehend selbstständig agierenden Sicherheitskräfte. Chinas Nationale Verteidigungsuniversität präsentierte im April Anbot, den elektronischen Polizisten – einen weißen Roboter mit blauem Leuchtstreifen, 1,49 Meter groß, 78 Kilo schwer, bis zu 18 Stundenkilometer schnell. Seine Form erinnert ein wenig an eine russische Matrjoschka-Puppe. Seine Batterie reicht für acht Stunden. Bei Ermüdungserscheinungen sucht sich der Roboter selbstständig eine Steckdose.

"Anbot" geht in China auf Streife

Anbot geht ganz autonom auf Streife, nimmt dabei seine Umgebung per intelligenter Videoanalyse wahr. Auf seinem Touchscreen befindet sich ein Notrufknopf. Wobei der Bürger sich gut überlegen sollte, dem Elektropolizisten zu nahe zu treten. Denn der kann Staatsgewalt ganz physisch ausüben, mit seinem eingebauten Elektroschocker – "zum Schutz gegen Gewalt und Unruhen", wie die chinesische Volkszeitung begeistert meldet.

Südkorea entwickelt den Robo-Guard, der Gefängnisse bewachen soll. Und hat an der Grenze zu Nordkorea bereits den SGR1 aufgestellt, einen Roboter von Samsung, der Wesen aus Fleisch und Blut erkennen und auf sie feuern kann. Bislang, heißt es, müsse ein Schuss noch von Menschenhand bestätigt werden. Auch Israel arbeitet an solchen Systemen.

Autonome Waffen gelten als der nächste große technologische Schritt, als dritte militärische Revolution – nach der Erfindung des Schießpulvers und der Atombombe. Wobei man unterscheiden muss zwischen automatisch und wirklich autonom. Es gebe da eine Menge Verwirrung, meint etwa Dr. Missy Cummings von der Duke University, eine ehemalige US-Kampfpilotin.

"Die Predator-Drohne ist ein automatisiertes Gerät, das mit einer Reihe klarer Steuerungsmittel arbeitet. Sie tut nur, was der Operator ihr sagt. Die X47 dagegen ist meiner Meinung nach mehr ein autonomes System, das beginnt, selbst Urteile zu fällen. Theoretisch könnte man der X47 sagen: Gehe auf diese Mission, finde den Bösewicht, töte ihn. Und ich will nichts von Dir hören, bis Du wieder zurück bist."

Seit 2002 fliegen die USA Angriffe mit Kampfdrohnen wie Predator und Reaper. Doch diese Geräte sind nur unbemannte, ferngesteuerte Automaten. Sie feuern auf Befehl von Menschen. Auch, wenn diese oft Tausende Kilometer entfernt sitzen.

Die X47B aber ist eine Kreuzung aus Drohne, Roboter und Kampfjet. Ihre Form kommt unserer Idee von einer fliegenden Untertasse ziemlich nahe. Sie kann ohne Pilot von einem Flugzeugträger abheben und auch auf diesem landen – ein extrem schwieriges Flugmanöver, das 2014 erstmals gelang.

LAWS – so der Fachbegriff, eine Abkürzung für Letale Autonome Waffensysteme – entscheiden selbst, wie sie ihre Mission erfüllen. Eigenständig dringen sie in gegnerisches Territorium ein – am Boden, in der Luft, zu Wasser, im Weltraum und auch im Cyberspace. Sie treffen dort auf Basis ihrer Beobachtungen Entscheidungen und verrichten autonom ihren zerstörerischen Auftrag. Etliche Staaten arbeiten bereits an autonom agierenden Robotern, Minipanzern, Schiffen, U-Booten und Flugzeugen. In die Zukunft der elektronischen Kriegführung wird vor allem in den USA viel Geld investiert.

Polizeiroboter in der Entwicklung

Doch auch Firmen forschen verstärkt an autonomen Systemen aller Art. Das Unternehmen Knightscope etwa verspricht vollmundig, mit seinem Polizeiroboter die Kriminalitätsrate zu halbieren. Der Apparat werde Verbrechen vorhersagen und verhindern können.

"Das ist Ihre Chance, in die nächste, neue, heiße Silicon-Valley-Firma zu investieren."

US-Verteidigungsminister Ashton Carter reist jetzt oft ins Silicon Valley, um sich Hightech-Hilfe zu holen, vor allem auf den Gebieten Robotik, Datenverarbeitung und Cybersicherheit. Carter sagt:

"Wir müssen auf einen Hightech-Feind vorbereitet sein."

Auch die berühmte US-Militärforschungsagentur DARPA, die einst das Internet erfinden ließ, arbeitet intensiv an autonomen Kampfsystemen. Die Ziele eines Projekts namens CODE etwa sind klar formuliert:

"So wie Wölfe in koordinierten Rudeln mit minimaler Kommunikation jagen, sollen mehrere unbemannte Flugkörper kollaborieren, um ein Ziel zu finden, zu identifizieren und anzugreifen."

Einschränkender Zusatz:

"Alles unter dem Kommando eines einzelnen menschlichen Aufsehers."

Auch Russland testet nach eigenen Angaben allerlei neues Kriegsgerät, etwa die sogenannte Platform-M: Ein Minipanzer mit Feuerkraft, der allerdings noch ferngesteuert wird. Ende 2015 sollen sechs Platform-M- und vier Argo-Systeme in Syrien eingesetzt worden sein. Der Angriff sei in Syrien koordiniert, die Steuerung der Maschinen in einem Kommandozentrum in Moskau vorgenommen worden.

"Na, bei den autonomen Systemen ist, glaube ich, jetzt wirklich der kritische Punkt: Was machen wir? Wo geht die Reise hin?"

Das Unbehagen wächst

Meint Robin Geiß, Professor an der Universität Glasgow, Experte für Militärtechnologie und internationales Recht. Das Unbehagen wächst. Im Mai 2013 präsentierte Christof Heyns, UN-Sonderberichterstatter für außergerichtliche und willkürliche Hinrichtungen, im UN-Menschenrechtsausschuss eine kritische Zwischenbilanz:

"Selbst wenn man annimmt, dass LARs – Letale Autonome Roboter – den Anforderungen des internationalen Menschenrechts gerecht werden könnten und außerdem bewiesen werden könnte, dass sie im Durchschnitt und in ihrer Gesamtheit Leben retten werden, muss gefragt werden, ob es nicht grundsätzlich falsch ist, autonome Systeme entscheiden zu lassen, wen sie wann töten. Fällt die Antwort negativ aus, kann keine andere Überlegung den Einsatz von LARs rechtfertigen, gleichgültig, auf welchem Niveau technischer Kompetenz sie operieren."

Es gebe, heißt es im Bericht, die "verbreitete Sorge", LARs könnten den Wert menschlichen Lebens an sich herabsetzen. Und – nimmermüde und allzeit bereit – die Gefahr permanenter militärischer Konflikte steigern. Die Forderung: ein Moratorium für das Testen, Produzieren, den Erwerb und die Stationierung solcher Systeme bis zu einer internationalen Übereinkunft.

"Ich wünsch mir so ein Teilverbot", meint auch Jurist Geiß, "womit sichergestellt wird, dass kritische Funktionen – über menschliche Rechtsgüter, über menschliches Leben, Leben und Tod – dass solche Entscheidungen immer in menschlicher Kontrolle verbleiben."

Seit 1955, als der Begriff zum ersten Mal fiel, hat die künstliche Intelligenz große Fortschritte gemacht. Anno 2050, mutmaßen Experten, könnte die KI menschliches Niveau erreicht haben. Schon debattieren KI-Forscher den großen roten Knopf – eine Sicherheitseinrichtung, die dem Menschen jederzeit ermöglichen soll, das Treiben eines Roboters zu stoppen, auch wenn der sich noch so clever dagegen wehrt.

Befürworter einer zunehmenden Automatisierung argumentieren: Solche Systeme seien weit effizienter und präziser als Soldaten aus Fleisch und Blut. Und deshalb letztlich sogar humaner. Schöner Nebeneffekt für Strategen: Es gibt auf ihrer Seite keine Särge, keine Witwen, keine schluchzenden Eltern und Kinder. Dies erleichtert den Einsatzbefehl. Schon beim andauernden Drohnenkrieg der USA gegen Ziele in Pakistan, Afghanistan, Somalia und dem Jemen wird das deutlich: Ohne eigene Opfer sinkt die Hemmschwelle.

Schützenhilfe leistet etwa Thomas Rid vom Department of War Studies am Londoner King's College, einer Kaderschmiede für Kommandeure. Rid, Autor des aktuellen Buches "Maschinendämmerung", hat sich mit Technikgeschichte beschäftigt. Und streicht die Vorteile der neuen Technologie heraus:

"Und die bemannten Flugzeuge hatten ein Riesenproblem, nämlich dass so viel Information auf den Piloten hereinbrach, dass er damit nicht mehr klarkam. Das Problem war: Es gab nur einen Piloten, manchmal eine zweite Person im Cockpit. Aber heute ist die Situation eine völlig andere. Wenn Sie so eine unbemannte Plattform haben, die da fliegt, dann ist da nicht mehr Autonomie im Spiel – ich provozier Sie mal –, sondern weniger Autonomie. Warum? Weil da mehr Leute drinsitzen – natürlich per Computer rein gebeamt, wenn Sie so wollen – als in einem bemannten System zuvor. Da gibt es nachrichtendienstliche Offiziere, der Pilot, Leute für die unterschiedlichen Sensorplattformen, die da alle mitfliegen. Sitzt sogar ein Anwalt daneben, den hatten Sie vorher im Cockpit nicht dabei. Das heißt: Nicht die Autonomie ist das Problem, sondern gewissermaßen die Organisation dieser ganzen Leute und Verantwortlichkeiten in Echtzeit."

20.000 Unterschriften gegen autonome Waffensysteme

Fraglich, inwieweit dies für vollautonome System noch gilt. Viele Forscher plagen Zweifel. 2015 warnten über tausend Wissenschaftler aus dem Bereich der Künstlichen Intelligenz per offenem Brief: Autonome Waffen seien greifbar nah. Diese dritte militärische Revolution müsse gestoppt werden.

"Ein militärisches KI-Wettrüsten zu beginnen, ist eine schlechte Idee und sollte durch ein Verbot offensiver autonomer Waffen verhindert werden."

Die Forscher begännen, eigenständiger zu denken, findet auch Aktivist Jaan Tallinn, der sich bereits an das Manhattan Project in Zweiten Weltkrieg erinnert fühlt: die Konstruktion der Atombombe. Viele beteiligte Wissenschaftler warnten damals vor den verheerenden Folgen der eigenen Arbeit.

"Wunderbar ist auch, dass der Gruppendruck schwindet. Mehr und mehr KI-Forscher scheren aus und sagen: Die Kontrolle von künstlicher Intelligenz ist wichtig und wurde vernachlässigt."

Bis heute haben über 20.000 den Appell unterschrieben, neben vielen KI-Forschern auch Wissenschaftsprominenz wie Stephen Hawking, Daniel Dennett oder Noam Chomsky, Direktoren von Google, Facebook, Microsoft, und etliche High-Tech-Pioniere.

Steve Wozniak, Mitgründer von Apple Computers, scherzte im amerikanischen Fernsehen, er beginne, die Welt plötzlich mit den Augen seines Hundes zu betrachten, sehe sich manchmal als künftiges Haustier einer Roboter-Superrasse. Die ihm wenig sympathisch sei.

"Diese Maschinen haben nicht gelebt. Sie sind nicht am Strand herumgelaufen, hatten keine tollen Tage, keinen Spaß. Sie haben sich nicht verliebt und Kinder bekommen."

Roboter, meint er, würden uns wohl niemals ähnlich werden. Maschinen, meint Wozniak könnten lernen, vieles sehr gut zu erledigen. Aber sie seien noch lange nicht fähig, die Gründe dahinter zu verstehen. Ausgerechnet Pioniere der Hightech-Welt zeigen also Skrupel. Elon Musk, Raumfahrtunternehmer und Gründer von Tesla Motors, spitzt noch weiter zu:

"Ich denke, wir sollten sehr vorsichtig sein mit Künstlicher Intelligenz. Wenn ich abschätzen soll, worin unsere größte existenzielle Bedrohung besteht: Das ist sie vermutlich. Ich glaube, wir brauchen hier behördliche Aufsicht – national und international, um sicherzustellen, dass wir nicht etwas sehr Dummes machen. Mit KI beschwören wir den Teufel."

Wird eine moraische Linie übertreten?

Seit Jahren engagieren sich das International Committee for Robot Arms Control, ICRAC, und eine Kampagne zum Stopp von Killerrobotern für ein Verbot von KI-Waffensystemen. Motor sind die Menschenrechtsorganisation Human Rights Watch, Juristen, Wissenschaftler und Friedensinitiativen von Nordamerika bis Japan. Einer von ihnen ist der Kanadier Ian Kerr, Professor für Ethik, Recht und Technologie.

"Selbst, wenn autonome Waffen vom Design wie von der Zielprogrammierung her gutwillig wären, geschieht hier etwas Fundamentales. Wir treffen eine moralische Entscheidung, Maschinen eine Entscheidung zu übertragen, die bislang ausschließlich menschlicher Entscheidung vorbehalten war: andere Menschen ins Visier zu nehmen und zu töten."

Diese moralische Linie zu übertreten, glaubt Kerr, wäre wie russisches Roulette.

"Solche Systeme werden ja für den Krieg vorbereitet", sagt Jürgen Altmann, Physiker und Friedensforscher an der TU Dortmund, ebenfalls aktiv bei ICRAC, "einschließlich für den mindestens Präemptionskrieg – das heißt: Der Krieg, den man beginnt, weil man denkt, es geht sowieso gleich los. Vielleicht aber auch für den Präventionskrieg, weil man denkt: Diese oder jene Macht, die muss ich jetzt mal militärisch niederringen, weil in zehn Jahren ist sie mir vielleicht überlegen oder wird mir zu gefährlich."

Altmann warnt vor allem vor einem rasanten Anstieg des Tempos. Im voll automatisierten Krieg gehe es um Millisekunden.

"Also wird es die Nervosität steigern. Und das wird auch noch die Unsicherheit und den empfundenen Druck, schnell zurückzuschlagen, erhöhen."

Beratungen in Genf

Seit Mai 2014 beraten in Genf im Rahmen der CCW, der UN-Konvention zu konventionellen Waffen, Delegationen aus mehr als 80 Staaten über die ethischen, rechtlichen und militärischen Folgen autonomer Waffen.

"Bislang haben mehr Staaten gesagt, dass es eine schlechte Idee ist. Aber es gibt welche, die die Tür weit offenlassen wollen, um diese Möglichkeiten weiter zu verfolgen", meint Stephen Goose, Direktor der Arms Division von Human Rights Watch. Die deutsche Regierung dagegen hat sich zuletzt per Koalitionsvertrag festgelegt:

"Deutschland wird für die Einbeziehung bewaffneter unbemannter Luftfahrzeuge in internationale Abrüstungs- und Rüstungskontrollregime eintreten und sich für eine völkerrechtliche Ächtung voll automatisierter Waffensysteme einsetzen, die dem Menschen die Entscheidung über den Waffeneinsatz entziehen."

Tatsächlich tun sich aber auch die deutschen Vertreter schwer, in Genf ein Verbot dieser Systeme zu fordern. Trotzdem, meint Goose, sei Genf sinnvoll.

"Hier sind die USA, Russland, China vertreten, Israel, Südkorea – alles Staaten, wo wir uns besondere Sorgen machen. Wir wollen ihre Position hören und sicherstellen, dass sie wirklich informiert werden über die Gefahren dieser Systeme. Aber wir müssen einfach schärfer rangehen hier in der CCW."

Bei der dritten Genfer Runde zu tödlichen autonomen Waffensystemen im April sprachen sich 14 Staaten für ein präventives Verbot aus, darunter Chile, Cuba, Mexiko, Pakistan und der Vatikan. Robin Geiß:

"Ich bin zaghaft optimistisch, dass es tatsächlich gelingen könnte, diesen Teilbereich – Entscheidungen über Leben und Tod – wirklich zu regulieren und von autonomer Entscheidungsfindung auszunehmen. Aber es ist schon so, dass technologisch führende Staaten, allen voran die USA, die hier auch technologisch schon weit fortgeschritten sind, sich hier jedenfalls Handlungsoptionen offenhalten wollen."

Und auch Skype-Erfinder Jaan Talinn versuchte sich am Ende seiner Rede vor der NATO-Versammlung in vorsichtigem Optimismus:

"Stellen Sie sich noch einmal das gigantische Raumschiff vor. Seit 50 Jahren in Arbeit. Die Kinder sind schon an Bord. Zehntausende von Ingenieuren arbeiten an den Maschinen und tanken es auf. Und eine kleine, aber wachsende Gruppe arbeitet nun auch an der Lenkung. Wann wird es starten? Wird die Lenkung rechtzeitig fertig sein? Der Start hart oder weich sein? Könnte das Ding einfach explodieren? Wird es uns, falls alles klappt, an einen schönen Ort bringen? Keiner weiß es. Hoffentlich bekommen wir es hin mit diesem metaphorischen Raumschiff."