Künstliche Intelligenz war lange Zeit ein Milliardengrab - die Forschung trat lange auf der Stelle, die Euphorie der Anfangsjahre versiegte. Aber in den letzten Jahren hat sich Erstaunliches getan: Die Spracherkennung in unseren Handys ist ohne KI nicht denkbar. Automatisches Fahren, automatische Fabriken, auch automatische Kampfdrohnen liegen in greifbarer Nähe. Prompt warnen Wissenschaftler und Programmierer vor den Gefahren - schafft die Menschheit sich selbst ab? Martin Zeyn fragt in seinem Essay, was die Künstliche Intelligenz heute wirklich kann und warum wir sie so fürchten.

Martin Zeyn, geboren 1964, ist Leiter des Nachtstudios im Bayerischen Rundfunk und lebt in München. Er hat über 20 Radioessays zu Kunst, Popkultur und Philosophie geschrieben. In letzter Zeit beschäftigt ihn vor allem die Zukunft des Menschen in einer digitalen Welt.

Ein Affenhaus.

Ich starre auf die Gesichter der Schimpansen, Gorillas, Gibbons und Orang-Utans, lange, direkt, unhöflich direkt, schamlos direkt, wie ich es bei Menschen nie tun würde. Ganz gleich, ob sie gerade herumtoben, sich kratzen, im Essen herumstochern oder nur ruhig dahocken, sie fesseln mich.

Es ist die Ähnlichkeit, die mich fasziniert. Die Gesten, die ich fast automatisch imitiere, wie um zu überprüfen, ob ich sie genauso mache; Gesten, die frappierend ähnlich, verstörend anders sind.

Natürlich weiß ich, was so aussieht wie mein Spiegelbild, ist nicht menschlich. Aber das ist gerade das Fesselnde: Wie etwas uns so ähnlich sein kann, ohne uns zu gleichen?! Und wie kann, was uns so ähnlich, im nächsten Moment als so fremd erscheinen?

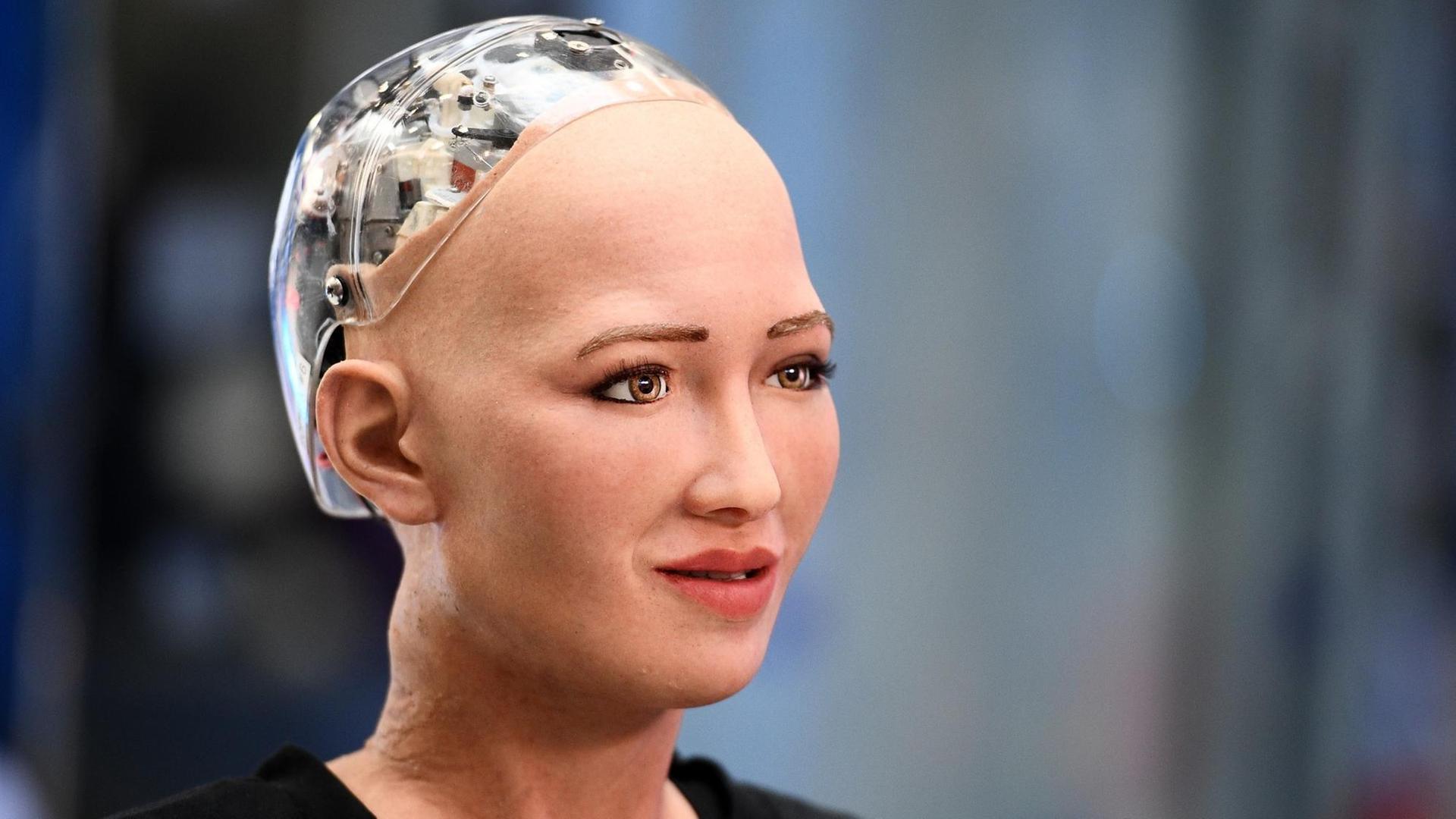

Menschen kommen besser mit Robotern zurecht, wenn die Maschinenwesen nicht wie Menschen aussehen, sagen Entwickler. Wir akzeptieren keine Roboter, die mit einem menschlichen Gesicht ausgestattet sind und deren Gesten steif, kalt, falsch wirken. Offenbar fremdeln wir, wenn sie ausschauen wie wir, wenn sie uns imitieren, wenn sie so tun als ob. Und wir das merken.

Ein klassisches Science-Fiction-Motiv: Viele Kurzgeschichten etwa von Philip K. Dick kreisen um dieses Thema, dem Erschrecken vor der Ähnlichkeit, dem verängstigenden Moment, in dem wir im Wesen vor uns, das redet wie wir, das sich verhält wie wir, erkennen müssen, es ist doch nur ein Roboter, ein Android der Nexus 6-Reihe.

Mensch oder Maschine?

In manchen Szenarien hat Dick das mit einer Drohung verbunden - also wenn wir die Roboter nicht mehr von uns unterscheiden können, werden sie uns vernichten. Aber müssen wir dann nicht eigentlich fragen: Wer vernichtet wen? Denn was unterscheidet Menschen von dem, was sie selbst nach dem eigenen Bildnis geschaffen haben - von einem Menschenwerk? Der vielzitierte Turing-Test behauptet, ein Computer verfüge über Künstliche Intelligenz, wenn Menschen nicht mehr differenzieren können, ob eine Antwort von einer Maschine oder einem anderen Menschen kommt.

Schon heute imitieren uns Computer. Roboter bauen unsere Autos zusammen und mühen sich redlich, eine Klinke herunterzudrücken, die Tür zu öffnen und einen anderen Roboter vorzulassen. Künstliche Intelligenzen beantworten unsere Fragen an die Sprachassistenten unserer Handys oder geben uns unermüdlich Übersetzungsvorschläge. Sie können noch nicht das, was wir können - noch nicht alles. Aber manches können sie schon besser als ihre Schöpferinnen und Schöpfer. Eine Zukunft, in der wir nicht mehr die einzigen intelligenten Wesen auf der Erde sind, scheint absehbar. Brauchen wir da nicht einen Test, der absolut sicher bestimmt, was einen Menschen im Unterschied zu einer Maschine ausmacht? Fähigkeiten wie Gedächtnis, Empathie oder Ironie - und wie messen wir die, wo liegt die Schwelle um zu bestimmen, was ganz und gar menschlich, was nur künstlich ist? Wann ist ein Mensch ein Mensch?

Und wann nur eine schlechtere Maschine? Also ein Wesen mit Ablaufdatum. Eine von der Evolution überrannte Spezies. Keine Zukunft ohne Kassandra. Schon vor 60 Jahren stellte der Biochemiker und Science-Fiction-Autor Isaac Asimov Gesetze für Roboter auf. Das berühmte lautet: Kein Roboter darf einen Menschen töten. Das weniger bekannte fordert: Keine Künstliche Intelligenz darf zusammen mit entwickelten biologischen Wesen gemeinsam auf einem Planeten leben. Die Essenz beider Gesetze: Es ist ein Gebot der Vernunft, die Apparate lieber auf Abstand zu halten. Kurz vor seinem Tod warnte der Physiker Stephen Hawking, in 100 Jahren würden uns Rechner überholen; und Elon Musk, Chef des Elektroautoherstellers Tesla, beschwört immer wieder die zerstörerische Kraft der KI, der Künstlichen Intelligenz, die demnächst ohne menschlichen Ratgeber entscheiden könnte, einen Präventivschlag zu führen.

Roboter herrschen intelligent

Wobei autonomes Fahren, ein Entwicklungsschwerpunkt von Tesla, nur dank der Fähigkeit zur Mustererkennung durch KI nicht möglich ist. Ein Auto, das nicht mitdenkt, wenn ein anderes unseren Weg kreuzt, sollte niemand alleine fahren lassen.

Aber das ist genau die Frage: Denkt es? Denkt das Auto? Denkt die Künstliche Intelligenz, die es steuert, wirklich? Kann sie entscheiden, welches Steuermanöver von zwei möglichen ethisch verantwortbarer ist? Einem Reh auszuweichen, selbst wenn das Manöver den Fahrer gefährdet? Den schlitternden Wagen lieber in eine Kindergartengruppe als in einen Rentnerausflug zu steuern? Oder doch eher umgekehrt? Was sind da die Parameter? Ein durchschnittliches Leben kostet etwa eine Million Euro, wenn wir die Wertschöpfung durch Arbeit als Berechnungsgröße annehmen. Dann müsste das autonome Auto der Limousine eines Firmenlenkers ausweichen und dafür in die Rentnergruppe steuern.

Ich erinnere mich nicht, diese Fragen in meiner Führerscheinprüfung gestellt bekommen zu haben. Auch wäre mir neu, dass beim ADAC-Fahrtraining solche Szenarien eingeübt werden. Warum stellen wir diese Fragen aber an ein Auto, das uns die Last des Lenkens abnimmt? Fürchten wir, dass es eine schlechte, eine amoralische Entscheidung treffen wird?

Oder schlimmer noch, fürchten wir, dass es eine bessere Entscheidung treffen kann?

Schauen wir uns die momentane Weltlage an: Umweltzerstörung, Kriege, Hunger, Ungerechtigkeit. Vielleicht wäre eine Herrschaft der intelligenten Roboter gar kein Schreckensszenario?

Natürlich würde der Individualverkehr abgeschafft. Weil es unsinnig ist, so viele Ressourcen zu verbrauchen, nur um Person A nach Punkt B zu bekommen.

Natürlich würden die Produktion und der Besitz von Waffen verboten. Weil einer Künstlichen Intelligenz nicht die zutiefst menschliche Abschreckungsformel zu vermitteln ist, man müsse schon im Voraus einen Gegner mit der Drohung einschüchtern, ihn umzubringen, damit der nicht auf die Idee verfällt, einen selbst umzubringen.

Messer mit fester Schneide blieben erlaubt, weil hier der Nutzen größer ist als die Gefahr.

Natürlich würden alle Drogen inklusive Wein, Bier und Zigaretten verboten. Weil zu viele Menschen sie missbrauchen beziehungsweise die Kosten fürs Gesundheitswesen in keinem Verhältnis zum Nutzen stehen.

Kaffee und Tee werden noch geprüft, hier ist die Datenlage nicht eindeutig genug.

Jeder Mensch mit einem Quäntchen Verstand müsste die Künstliche Intelligenz für diese Entscheidungen loben.

Jeder Mensch, der noch einen Rest Würde besitzt, muss sich fürchten vor dem puritanischen Furor, der in solchen Überlegungen steckt. Es gibt gute Gründe, trinkbaren Alkohol zu verbieten, aber beim Wein würde auch eine achttausendjährige Kulturleistung ausgelöscht. Schlimmer noch, wir würden zu Objekten degradiert, denen die KI nicht zutraut, eine individuelle Abwägung von Nutzen und Schaden zu treffen. Wir wären Sklaven einer guten Sache.

Wobei, interessant wäre es zu sehen, ob der menschliche Erfindergeist nicht erstaunliche, unvorhersehbare Mittel und Wege fände, die Künstliche Intelligenz an der nicht vorhandenen Nase herumzuführen.

Menschliches Handeln nicht vorhersehbar

Natürlich können Programme Szenarien entwickeln, um den Menschen eine wünschenswerte Zukunft zu gestalten.

Natürlich werden diese Szenarien nur dann Realität, wenn wir gemeinsam dafür sorgen, dass nicht Menschen verhindern, was den Menschen nützt.

Wobei die Künstlerin Hito Steyerl - Erfinderin der sehr schlauen Formel, dass es neben der Künstlichen Intelligenz auch die Künstliche Dummheit gebe - Hito Steyerl hat darauf aufmerksam gemacht, wie parteiisch wir sind, was Vorhersagen angeht. Die Bewohner des Londoner Hochhauses Grenfell Tower hätten immer wieder darauf hingewiesen, dass die Gefahr eines Brandes enorm hoch sei. Die Befürchtungen haben sich bewahrheitet, 71 Menschen starben. Wieso wurde auf ihre Vorhersage nicht gehört, fragt Steyerl.

Nicht etwa, weil sie so dunkel und doppeldeutig war wie die des Orakels von Delphi. Nein, weil menschliche Vorhersagen, vor allem von Menschen ohne gesellschaftliches Ansehen, nicht den gleichen Rang haben wie Vorhersagen, die Computer erstellen.

Dabei sind Menschen als Orakel gar nicht so schlecht. Was die Informatikerin Julia Dressel herausgefunden hat. Sie hat das Programm "COMPAS" untersucht, mit dem in den USA die Rückfallwahrscheinlichkeit von Straftätern berechnet wird. Ist die Prognose positiv, gewähren die Gerichte in einigen Staaten eine frühere Haftentlassung.

Dressel hat die Informationen, die dem Programm zur Verfügung standen - Lebensumstände, Wohnort, Rasse - 20 willkürlich ausgewählten Menschen zur Verfügung gestellt. Diese Gruppe ohne spezielle juristische oder soziologische Vorkenntnisse erreichte dieselbe Trefferquote wie das Programm: 65 Prozent.

Was die Informatikerin selbst überrascht hat: Wenn die Anzahl der Parameter erhöht wird, also mehr Gründe herangezogen werden, warum jemand in der Vergangenheit rückfällig geworden ist, führt das nicht zu einer Verbesserung des Ergebnisses. Mehr Parameter zu berechnen, erhöhte nicht die Trefferzahl. Es blieb bei etwa 65 Prozent Genauigkeit. Was eben auch heißt: Jede dritte Vorhersage war falsch. Bei Menschen wie Maschinen.

Allerdings, da es nur zwei Möglichkeiten gibt - jemand wird rückfällig oder nicht - läge die Trefferquote, die auf einer rein zufälligen Auswahl beruht, schon bei 50 Prozent. Das heißt das Auswerten von Daten erhöht die Genauigkeit, aber auch nicht in einem überragenden Ausmaß.

Es scheint eine natürliche Grenze der Genauigkeit zu geben. Menschliches Verhalten ist nicht vorhersagbar. Was Statistiker nicht erstaunt. Es ist relativ einfach, meine Einkäufe mit denen anderer Kunden zu vergleichen, die dieselben oder ähnliche Dinge gekauft haben. Und wenn ein Händler verspricht, etwas zu liefern, bevor wir es bestellt haben, dann heißt das in der Praxis oft nur, die Firma liefert uns die Erweiterung des Computerspiels Call of Duty oder den gerade erschienenen Teil der neapolitanischen Romansaga von Elena Ferrante, wenn wir ein Produkt der Reihe schon gekauft haben. Schwieriger ist es, wenn eine große Zahl von Einflüssen unser Handeln bestimmen kann. Dann lassen sich keine eindeutigen Vorhersagen mehr machen.

Wirtschaftsfirmen aber lieben Vorhersagen, denn sie geben den Vorständen den Rahmen vor, wie sie sich in Zukunft verhalten sollen. Das Neue sollte einen nicht unvorbereitet treffen. Aber einfacher, als etwas Neues zu wagen, ist es, das Alte, das man kennt, etwas zu verbessern und ein wenig günstiger anzubieten. So innovativ sind auch Computerprogramme, die zum Beispiel eine Fräse so lange minimal verstellen, bis sie ein optimales Ergebnis erzielt.

Computer sind nicht neugierig

Das Neue hat nur einen guten Ruf, aber wenig echte Freunde. Deswegen sollte das Neue nicht allzu neu sein. Nicht wenige Führungskräfte scheinen das Neue fast zu fürchten - seine alles auflösende Kraft -, sie fürchten, nicht vorbereitet zu sein. Und verkennen damit ein Potenzial ihrer Mitarbeiter, ja aller Menschen: Dinge neu zu erschaffen. In einem erst vor Kurzem wiederentdeckten Vortrag meditierte die Philosophin Hannah Arendt über die Revolution in den USA - insbesondere beschäftigte sie die Frage, warum der Aufstand der Gründerväter gegen die britische Fremdherrschaft gelang. Was diese Revolution auszeichnete, war das Zusammenwirken zweier Gefühle, nämlich "frei zu sein und etwas Neues zu beginnen". Die Erfindung der neuzeitlichen Demokratie war laut Arendt nur deshalb möglich. Sie gelang, weil das Neue den Geschmack von Freiheit hatte.

All men are equal - alle Menschen sind gleich. Eine revolutionäre Formel. Gleichzeitig - und das ist ein brillanter Gedanke von Arendt - haben die Gründerväter circa ein Fünftel der Bevölkerung schlichtweg übersehen: die Sklaven. Aber nur weil sie das taten, weil sie diese Implikation nicht wahrnahmen, verabschiedeten die Sklavenhalter eine Verfassung, die in sich den Keim trug zur Überwindung der Sklaverei.

Jedes Programm hätte auf den offen zutage liegenden Fehler hingewiesen. Auch Schwarze sind Menschen. Dann könne nicht stimmen, dass Sklaven keine Menschen sind. Folglich darf niemand sie versklaven. Ein einfacher Syllogismus, mit dem die Logik einer Annahme überprüft werden kann. Aber - woran erinnert werden muss - es gibt auch eine Logik der Sklaverei, eben wenn die Annahme als wahr gilt, dass Schwarze nicht gleich sind.

Hätte ein Computerprogramm die amerikanische Revolution verhindert, indem es auf den immanenten Widerspruch zwischen Gleichheit und Sklaverei hingewiesen hätte? Vielleicht.

Worauf Arendt hinweist: Die Gründerväter entwarfen einen Staat, der zwar nicht gleich umgesetzt wurde, der aber zumindest ab jetzt denkbar war. Menschen können etwas Neues schaffen - das sicher einen Vorlauf braucht, aber eben nicht nur eine Verlängerung dieser Vergangenheit darstellt. Nicht berechenbar zu sein, kann ebenso eine Schwäche wie eine Möglichkeit sein. Oder wie es Arendt für sie untypisch poetisch formulierte: "Wir können etwas beginnen, weil wir Anfänge und damit Anfänger sind."

Und Maschinen, können sie so revolutionär sein wie Menschen? An dieser Stelle können wir alle beruhigen, die sich vor einer künstlichen Intelligenz fürchten. Jürgen Schmidhuber - laut der "New York Times" der "Gottvater der KI", aber Journalisten sind nicht gerade kleinlich, wenn es gilt, Idole zu Göttern zu erklären - Schmidhuber räumt ein, es sei sehr, sehr schwierig, Computern Neugier beizubringen. Tatsächlich ist das, was heute als KI, als Künstliche Intelligenz, bezeichnet wird, eigentlich nur maschinelles Lernen. Was heißt: Wie eine Lehrerin stellen wir dem Maschinenkleinkind eine Frage und bringen ihm bei, diese eine Frage zu beantworten. Vielleicht ist ja die KI‑Forschung gerade deswegen zurzeit erfolgreich - einmal abgesehen vom Geldregen aus dem Silicon Valley -, weil die Wissenschaftler demütiger geworden sind. Die Grenzen des Erreichbaren werden klar benannt. Es geht nicht um die Schaffung eines Bewusstseins, sondern um graduelle Verbesserungen: Die Maschinen beginnen gerade erst zu lernen, aus ihren Fehlern zu lernen.

Und wie schwierig das ist, was für eine lebenslange Aufgabe, das wissen wir Menschen selbst aus schmerzlicher Erfahrung. Was Programme schon heute besser können: Sie betrachten Fehler nicht als Misslingen, sondern als Schritt zu einer besseren Lösung. Sie können das, weil sie nicht emotional beteiligt sind. Sie verzweifeln nicht, ermüden nicht, sie ärgern sich nicht. Sie sind fokussiert, spielen alle Möglichkeiten durch, bis eine Lösung gefunden ist. Ganz fremd ist das uns Menschen allerdings auch nicht. Die israelische Armee hat ein interessantes Projekt gestartet: Sie hat inselbegabte Autisten Satellitenfotos auswerten lassen, also Menschen, die Mimik auf Gesichtern kaum verstehen, aber stundenlang starr zwei Bilder anschauen können, bis sie alle Unterschiede zwischen ihnen entdeckt haben. Sie haben solange auf die Bilder geschaut, bis sie die minimalen Veränderungen gefunden, bis sie eine eventuelle Bedrohung entdeckt haben.

Tätigkeiten wie diese werden eines Tages Programme übernehmen, weil sie die Fähigkeit von den allermeisten Menschen übersteigen, sich nur auf ein winziges Problem bei einer ungeheuren Datenmenge zu konzentrieren. Und weil die Zahl von Autisten, die so etwas können, begrenzt ist. Und natürlich gibt es mehr als nur diesen überschaubaren Bereich, in dem Roboter besser sind als Menschen beziehungsweise ihr Einsatz Menschen schützt. Also wo wir sie gerne für uns arbeiten lassen: etwa beim Umgang mit Gefahrengütern, giftigen Farben, radioaktiven Materialien. Oder bei vielen pflegerischen Tätigkeiten, die entweder stupide sind wie das Überprüfen der Tablettenanzahl im Medizinbecher oder die den Rücken belasten wie das Wenden von bettlägerigen Patienten.

Roboter schaffen Zeit für Menschen

18 Monate habe ich in einem Altenpflegeheim gearbeitet. Da ich auf einem Bauernhof groß geworden war, dachte ich: Ich weiß, was schwere Arbeit ist. Ich sollte mich irren.

Eine der wenigen Nachtschichten, die ich gemacht habe, war an Silvester. Als die Donnerschläge und Raketen in Massen explodierten, irrte eine 90jährige durch die Zimmer und schrie: "Die Bomber kommen."

Ich wusste nicht, was zu tun war.

Dabei war ich nicht schlecht im Rollenentwickeln. Ich war Neffe, Enkel, Jäger, Freund des Mannes, ich spielte alles mit, ergänzte alles, was die verblichenen Erinnerungen an kaum erkennbaren Szenarien vorgaben. Die Patienten beschenkten mich im Gegenzug mit Wachheit, mit Geschichten, mit Freude.

Aber hier wusste ich nicht weiter. Ich nahm aus einem unerklärlichen Impuls die Frau an die Hand, die sich augenblicklich fest um meine krampfte, ließ sie nicht los, die ganze Nacht machte ich mit ihr alle meine Rundgänge in dieser von Explosionen zerrissenen Silvesternacht, redete so viel ich konnte und so ruhig ich konnte.

Ich hätte nicht nur in dieser Nacht gerne einen Roboter dabeigehabt, der mir das Wenden der Schlaganfallpatienten alle vier Stunden abgenommen hätte, das Reichen des Trinkbechers, der doch schon direkt nebenan auf dem Tischchen stand - ich hatte Hilfe bitter nötig, weil, wenn ich ihre Hand lösen musste, die Angst schlimmer wurde. Ihre Panik brauchte meine Hand.

Mehrfach habe ich daran gedacht, die Arbeit aufzugeben. Wegen Rückenproblemen musste ich zum Arzt, zwei-, dreimal fertigte ich die alten Menschen barsch ab, weil so viel zu tun war - wofür ich mich bis heute schäme. Ich ahnte, diese Arbeit übersteigt meine Kräfte. Ein Roboter hätte geholfen. Damit mehr Zeit gewesen wäre zuzuhören. Zeit, weil ich gerade keine Lösung hatte. Aber immerhin hatte ich noch eine Hand. Und Menschen brauchen eine Hand manchmal mehr als eine Lösung oder ein Glas Wasser.

Wir müssen Programme trainieren

Es gibt kein Entweder-oder, auch und gerade in der Debatte um Künstliche Intelligenz. Wenn wir die Aufgaben klar definieren, dann können wir Roboter konstruieren, die uns Menschen Zeit verschaffen, damit wir Patienten ihre Würde lassen. Aber wenn wir Militärtechnologen frei schalten und walten lassen, dann bekommen wir Kampfdrohnen, die eigenständig entscheiden, welcher Mensch im nächsten Moment tot sein wird.

Mir allerdings wäre es egal, ob ich mithilfe des Befehls eines Menschen oder allein durch die Algorithmen eines Programms getötet würde. Solange auch wir ach so vernunftbegabten Menschen es nicht so genau nehmen mit der Befolgung des fünften Gebots, solange sollten wir einen gewissen Großmut walten lassen, wenn es um die ethische Unerfahrenheit der KI geht.

Aber es sind ja noch andere Unerfahrenheiten, die uns Sorgen bereiten. "Das Tiefste am Menschen ist die Haut", hat der Dichter Paul Valéry einmal geschrieben. Nicht abzusehen ist, ob diesen Satz je ein nicht biologisches Wesen verstehen wird. Die Tiefe der Haut ist messbar, zwischen 1,5 und vier Millimeter. Wie soll sie da das Tiefste am Menschen sein? Trotzdem steht für jeden Verliebten, der gerade vom Objekt seiner Begierde berührt wird, die Richtigkeit dieses Satzes außer Frage.

Unklar ist, ob neuronale Netze je mehr können werden als menschliches Denken zu simulieren. Einige Menschen verneinen das, aus theologischen, was nicht überrascht, aber auch aus wissenschaftlichen Gründen. Der renommierte Linguist John Searle etwa weist darauf hin, dass ein Algorithmus nur dann funktioniert, wenn alle Rechenschritte nacheinander vollzogen werden. Natürlich tun wir Menschen das auch - aber eben nicht nur. Viele große Entdeckungen beruhen auf genialen Einfällen, plötzlichen Eingebungen, auf unserer Fähigkeit, in einem Zufall eine Regel zu entdecken. Searle nennt das unsere Fähigkeit zu semantischem Denken, das heißt unser Vermögen, etwas mit Bedeutung zu erfüllen.

Noch beruht vieles, was wir etwas leichtfertig Künstliche Intelligenz nennen, auf der Fähigkeit, inmitten von gigantischen Datensammlungen Korrelationen zu finden. Aber noch sind die Programme nicht in der Lage zu erkennen, ob eine wirkliche Kausalität oder doch nur eine Korrelation vorliegt. Eine Korrelation sind viele Geburten im Frühling und das zeitgleiche Eintreffen der Störche, eine Kausalität, das wissen schon kleine Kinder, ist das nicht.

Niemand weiß, ob eine Künstliche Intelligenz, ob etwa ein tiefes neuronales Netz das eines Tages auch kann: einen Grund bestimmen. Neuronale Netze imitieren unser Gehirn. Dort leiten Neuronen einen Impuls schneller weiter, wenn er mehrfach auftritt. Einfach ausgedrückt: Wir lernen aus Erfahrung. KI zählt alle eingehenden Daten und was häufiger auftritt, wird als Muster etabliert. Nach diesem Muster sucht dann das Programm - und findet es weitere Treffer, dann wird dieser Algorithmus zur Norm. Das heißt wir müssen diese Programme trainieren, müssen ihnen beibringen, was zu löschen, was hinzuzufügen, welcher Schwellenwert angemessen ist, um eine Reihe von Zufällen von einer Regel zu unterscheiden. Das heißt wir bringen der Maschine bei, wie Daten sinnvoll analysiert werden. Weiter sind wir noch nicht. Die KI lernt noch das Lernen.

Niemand weiß, ob unser Gehirn wirklich so arbeitet beziehungsweise ob das schon unsere Fähigkeit zu lernen in Gänze beschreibt. Die Vertreter der These, dass Intelligenz unabhängig vom Trägermedium, also unabhängig vom Gehirn, überall gleich funktioniert, sind etwas stiller geworden.

Bis auf die überschaubare Gruppe der Transhumanisten, die von der etwas eitel wirkenden Hoffnung getrieben sind, ihr gescanntes Bewusstsein könne auf ewig in den Netzwerken fortleben. Es ist daher kein Zufall, dass einige Transhumanisten die Anerkennung als Religion einfordern. Manchmal ist nicht der Entwicklungsstand der KI ein Problem, sondern die Euphorie ihrer menschlichen Befürworter. Die Maschinen sind nicht schuld daran, dass wir ihre Fähigkeiten überschätzen.

Aber in einem Punkt sind uns die Programme schon jetzt überlegen: Sie fragen. Was sich harmlos, ja banal anhört, ist eine große Schwäche der Menschen. Wir hören auf zu fragen. Wir fragen nicht genug. Der überdeutliche, zugleich unsichtbare Rassismus der amerikanischen Gründungsväter ist ein Beispiel. Ein anderes, moderneres macht es noch deutlicher. 1974 veröffentlichte der Mediziner Harald zur Hausen einen Bericht über die Rolle von Viren bei der Entstehung von Gebärmutterhalskrebs. Der Forscher wurde anfangs hart dafür kritisiert, weil er der damaligen Lehrmeinung widersprach, dass Krebs nicht durch Viren ausgelöst wird. Der zentrale Unterschied: Gegen Viren können Impfungen entwickelt werden. Was schließlich auch versucht wurde - mit Erfolg. Weil ein Wissenschaftler der herrschenden Meinung widersprochen hatte, stand 2006 endlich ein Impfstoff zur Verfügung, der gegen zwei Krebs auslösende Virentypen immunisiert. Nicht nur Computer können vom Menschen lernen, auch wir von ihnen. Wir können lernen, die Fragen zu sehen, die sich aus der Datenanalyse ergeben. Wir können das Infragestellen lernen. Wir glauben zu wissen. Die Künstliche Intelligenz ist dagegen ein Anhänger Sophokles': Sie weiß, dass sie nur deswegen etwas wissen kann, weil sie so handelt, als wisse sie nichts.

Kein Krieg zwischen Mensch und Maschine

Auch wir sollten also das Lernen wieder lernen - und das Auswendiglernen, das die Lehrpläne dominiert, lieber den Maschinen überlassen. Der spielende, der neugierige, der poetische, der schöpferische Mensch hat in einer sich ständig verändernden Umwelt überlebt. Es gibt Insekten, die perfekt auf eine Wirtspflanze eingestellt sind. Wir sind es nicht. Als biologische Art sind wir Generalisten, die selbst chaotische Situationen noch überleben. Weil wir fähig sind, das Neue zu erfassen, ohne es zu kennen.

Und darum muss sich niemand Sorgen machen, dass wir verschwinden. Die zukünftige Intelligenz, der wir das Künstliche nicht mehr oder kaum noch anmerken, wird uns nicht in einen Menschenpark sperren, weil sie ihren Code entschlüsselt hat und wir langweilig geworden sind. Eine Intelligenz, der Neugier und Offenheit implantiert ist, wird Menschen schätzen, die ihr immer wieder Aufgaben stellen, an denen sie zu knabbern hat. Seit dem Mathematiker Kurt Gödel wissen wir, dass hinlänglich komplexe Systeme nicht widerspruchsfrei sein können, sie sich also nicht vollkommen aus sich beweisen lassen. Anders gewendet, Systeme schaffen sich selbst einen Grund. Unser soziales Leben beruht auf Annahmen: Liebe, Würde, Intelligenz. Wir haben damit wunderbare Dinge erschaffen: Musik, Sprachen, Wortspiele, Wein, Abzählreime, Freiheit - Errungenschaften, die eine Künstliche Intelligenz, wenn sie nicht dumm ist, zu schätzen wissen wird.

Es droht also kein Krieg zweier intelligenter Spezies, kein "survival of the fittest", kein Auslöschen der Menschheit. Keine neue Superrasse verdrängt uns wie der Homo sapiens den Homo neanderthalensis, der moderne Mensch den Neandertaler. Denkbar ist auch eine Koevolution, ein Nebeneinanderher, ein Wertschätzen jener Fähigkeiten, über die der andere nicht im gleichen Maße verfügt. Wir fürchten die Roboter, weil sie drohen, uns zu ähnlich zu werden. Das ist menschlich, muss aber nicht so sein. Marcel Proust wirft im vierten Teil der "Recherche" die Frage auf, ob wir nicht eigentlich das lieben, was uns nicht gleicht. Auch Unterschiede ziehen uns an.

Wir müssen die Roboter ja nicht gleich lieben. Es geht eher um Demut. Jahrtausendelang haben wir auf Barbaren, Naturvölker und Wilde herabgesehen. Wir sehen herab auf Menschen, die wir nicht als gleichwertig ansehen. Noch mehr auf Wesen, die, weil sie Tiere sind, von uns wie Vieh behandelt werden. Orcas sprechen, Mutterkühe leiden, wenn Bauern ihnen die neugeborenen Kälber wegnehmen, Keas, Papageien aus Neuseeland, lernen vom erfolgreichen Verhalten ihrer Artgenossen, Matabele-Ameisen schleppen verwundete Artgenossen in den Bau zurück, um sie dort zu versorgen. Wir sind nicht so einzigartig, wie wir denken.

Darwins Evolutionslehre wurde lächerlich gemacht, indem ein namenloser Zeichner ihn als Affen mit Menschenkopf karikierte. Aber der Zeichner lag richtiger, als er wusste: Schimpansen verwenden Werkzeuge, benutzen Sex als Mittel der sozialen Interaktion und, ja, bekämpfen andere Gruppen, wenn die in ihr Revier eindringen. Damit sind sie uns schon sehr nah.

Nah genug, damit ich sie im Zoo anstarre und ihre Gestik faszinierend finde.

Charles Darwin vermutete, dass der Unterschied zwischen Mensch und Affe ein gradueller, nicht ein prinzipieller sei. Auch der Unterschied zwischen der künstlichen und der menschlichen Intelligenz ist womöglich nur ein gradueller. Es kann sein, dass das Imitieren des Menschen die Maschinen sehr menschlich erscheinen lassen wird. Und dann? Dann ist die Frage, wie wir uns wechselseitig anschauen werden: Als Gegner? Oder als Faszinosum? Die Roboter, die neuronalen Netze, die Künstliche Intelligenz - sie kommen näher. Wenn wir nicht vor ihnen erschrecken, haben wir eine gute Chance, voneinander zu lernen.