Im Juni hat das Pentagon zum ersten Mal seit 1956 eine neue Version des Law of War Manual herausgebracht. Ein Handbuch, das auf 1200 Seiten die Regeln des Krieges aus Sicht des US-Verteidigungsministeriums auflistet. Auf Seite 330, im Kapitel 6.5.9.3 stehen die Zeilen, die manche Wissenschaftler auf die Barrikaden bringen. Frei übersetzt heißt es dort:

"Diese Regeln stellen keine Verpflichtung für die Waffen selbst dar. Selbstverständlich kann ein lebloses Objekt niemals einer Verpflichtung nachkommen."

Autonome Waffen, Maschinen, sind niemals Kämpfer, erklärt Paul Scharre die Aussage des Kriegshandbuchs. Er hat lange im Pentagon gearbeitet und dort einen Entwurf des Dokuments auf seinem Schreibtisch gehabt. Jetzt ist er als Experte für autonome Waffen beim Center for New American Security, einem Think Tank in Washington.

"Es sind Werkzeuge, genau wie eine Maschinenpistole oder ein Messer oder ein Bajonett, bei deren Einsatz sich Menschen an geltendes Recht halten müssen. Die Verantwortung für das, was passiert, können Menschen nie auf solch eine Waffe übertragen. Sie können nicht sagen: Ich habe nicht getötet, die Waffe hat getötet."

Können Maschinen eine moralische Verpflichtung haben?

Das sieht Selmer Bringsjord anders. Er forscht am Rensselaer Polytechnic Institute im Bundesstaat New York an Künstlicher Intelligenz.

Er sei geschockt von dem Statement des Pentagons, dass Maschinen keine moralische Verpflichtung haben können. Dass Waffen auch künftig dumme Werkzeuge bleiben sollen. Denn die Entwicklung laufe in eine andere Richtung. Bots an der Börse handeln heute schon selbstständig Aktien, autonome Autos fällen eigenständig Entscheidungen und auch die Waffensysteme der Zukunft werden ein gewisses Eigenleben haben, glaubt Bringsjord:

"Es gibt Computercode, der sich selbst verändert und anpasst und damit ein Ziel verfolgt. Solche Ideen gibt es schon seit den Anfängen der Künstlichen Intelligenz und sie gehen nicht weg, nur weil man sagt, dass es so was nicht geben kann."

Für Bringsjord und eine Reihe anderer amerikanischer KI-Forscher, die er neulich zu einer Podiumsdiskussion in Washington eingeladen hatte, geht das Dokument aus dem Pentagon von unrealistischen Annahmen aus und kratzt zudem an ihrer Existenzberechtigung. Sie verstehen es so, als wären wirklich intelligente, lernfähige Systeme unerwünscht und ihre Entwicklung überflüssig. Ex-Pentagon-Mitarbeiter Paul Scharre sucht einen Kompromiss:

"Wenn wir sagen, dass eine Maschine mit künstlicher Intelligenz ein Werkzeug ist und kein eigenständiger Akteur, dann heißt das nicht, dass wir die Forschung auf dem Gebiet limitieren. Es geht darum, wie wir das System designen. Nämlich so, dass es einen Nutzer hat und dass es dazu da ist, einen bestimmten Zweck für eine Person zu erfüllen.

Es geht also darum wie man die Technik nutzt."Doch wie sinnvoll ist es, die Verantwortung dem Nutzer zu überlassen, wenn der gar nicht mehr entscheidet, weil die Maschine es besser kann? Autonome Autos machen weniger Unfälle als Menschen am Steuer, das zeigt sich schon jetzt. Das autonome Auto der Zukunft wird kein Lenkrad mehr haben. Genauso könnten autonome Waffensysteme eines Tages Soldaten überlegen sein. Deshalb sei es entscheidend, solchen Systemen moralische Grundsätze zu implementieren.

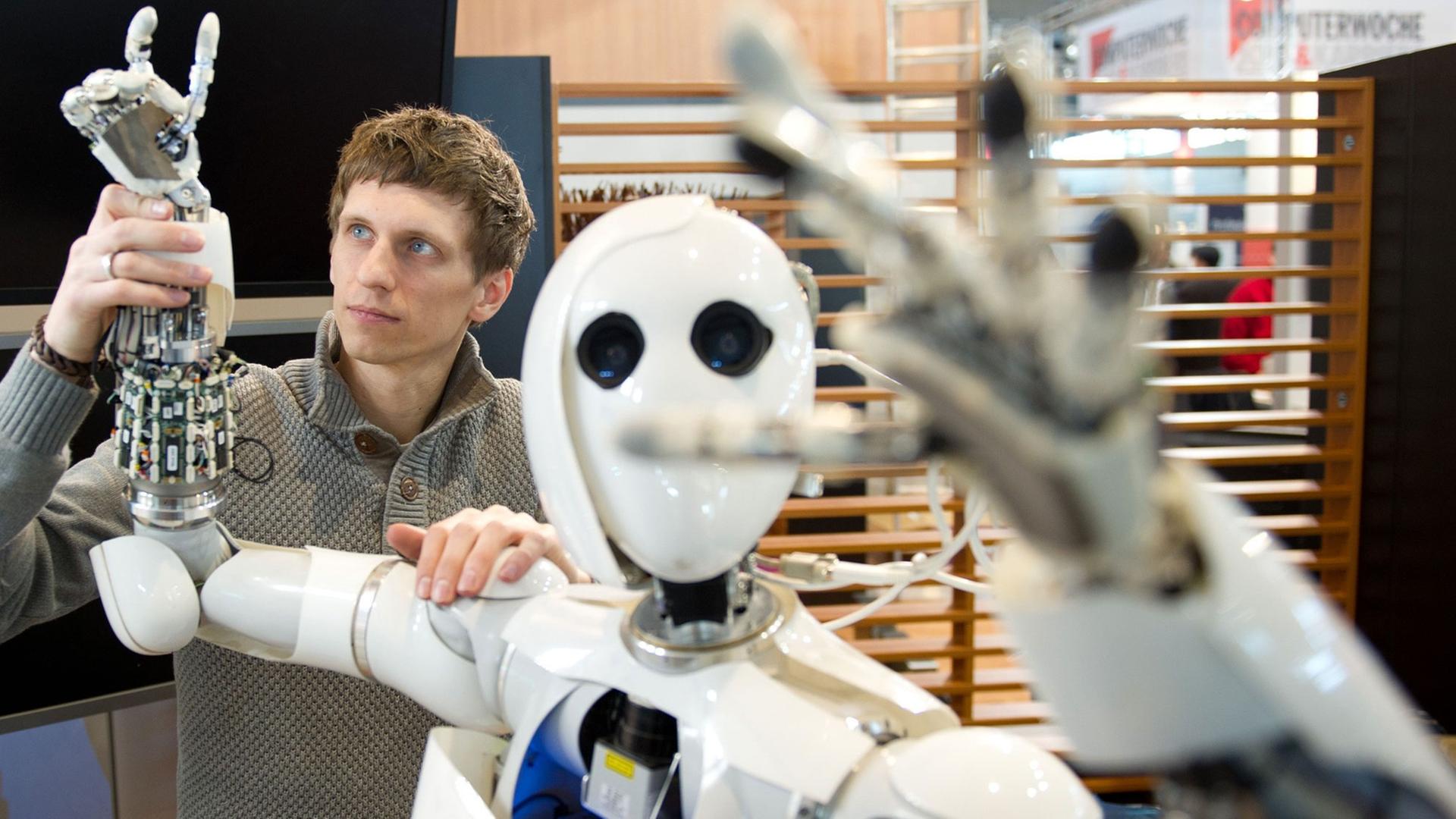

Schreckensvision des Kampfroboters

Ethische Grundsätze oder Normen sollten in Zukunft in das Betriebssystem autonomer Maschinen integriert sein, sagt Selmer Bringsjord. So tief integriert, dass sie nicht manipulierbar sind. So würde es einem Feind, dem die Maschine in die Hände fällt, unmöglich gemacht werden, sie für Zwecke zu missbrauchen, für die sie nicht konstruiert wurde - etwa um gezielt Zivilisten zu töten oder andere Kriegsverbrechen zu begehen.

Der Schreckensvision des Kampfroboters, der seine eigenen Ziele verfolgt, setzt Selmer Bringsjord die Vision einer Maschine entgegen, die sich auf dem Schlachtfeld stets moralisch einwandfrei verhält. Dass so etwas denkbar ist, müsse sich im Law of War Manual, dem Kriegshandbuch des Pentagon, widerspiegeln.