"Der Treiber von so was sind natürlich ungeplante Missionen. Beispielsweise Search-and-Rescue-Missionen, wo ein Einsatz geflogen werden muss, ohne dass groß eine Vorbereitung und Vorerkundung gemacht werden können."

Professor Axel Schulte leitet an der Bundeswehr-Universität in München das Institut für Flugmechanik. Eines der Themen, das ihn umtreibt, sind künftige Einsatzszenarien für Aufklärungsdrohnen. Und die Frage, wie autonom die fliegenden Späher unterwegs sein sollten, damit Flugzeugbesatzungen sie während eines Einsatzes nebenbei befehligen können.

"Man muss eine gewisse Automatisierung natürlich einführen, um die Aufgabe überhaupt handhabbar zu machen. Wenn Sie sich vorstellen, ein Pilot in einem Flugzeug, sei es ein Hubschrauber oder Kampfflugzeug, hat natürlich viel zu tun, von hause aus. Und jetzt gibt man ihm noch eine zusätzliche Aufgabe dazu. Da muss man automatisieren, sonst geht's gar nicht. Aber man darf eben auch nicht zu hoch greifen. Wir machen also bei uns experimentelle Untersuchungen mit Laborprototypen und Piloten der Bundeswehr, um genau diese Fragestellungen zu eruieren."

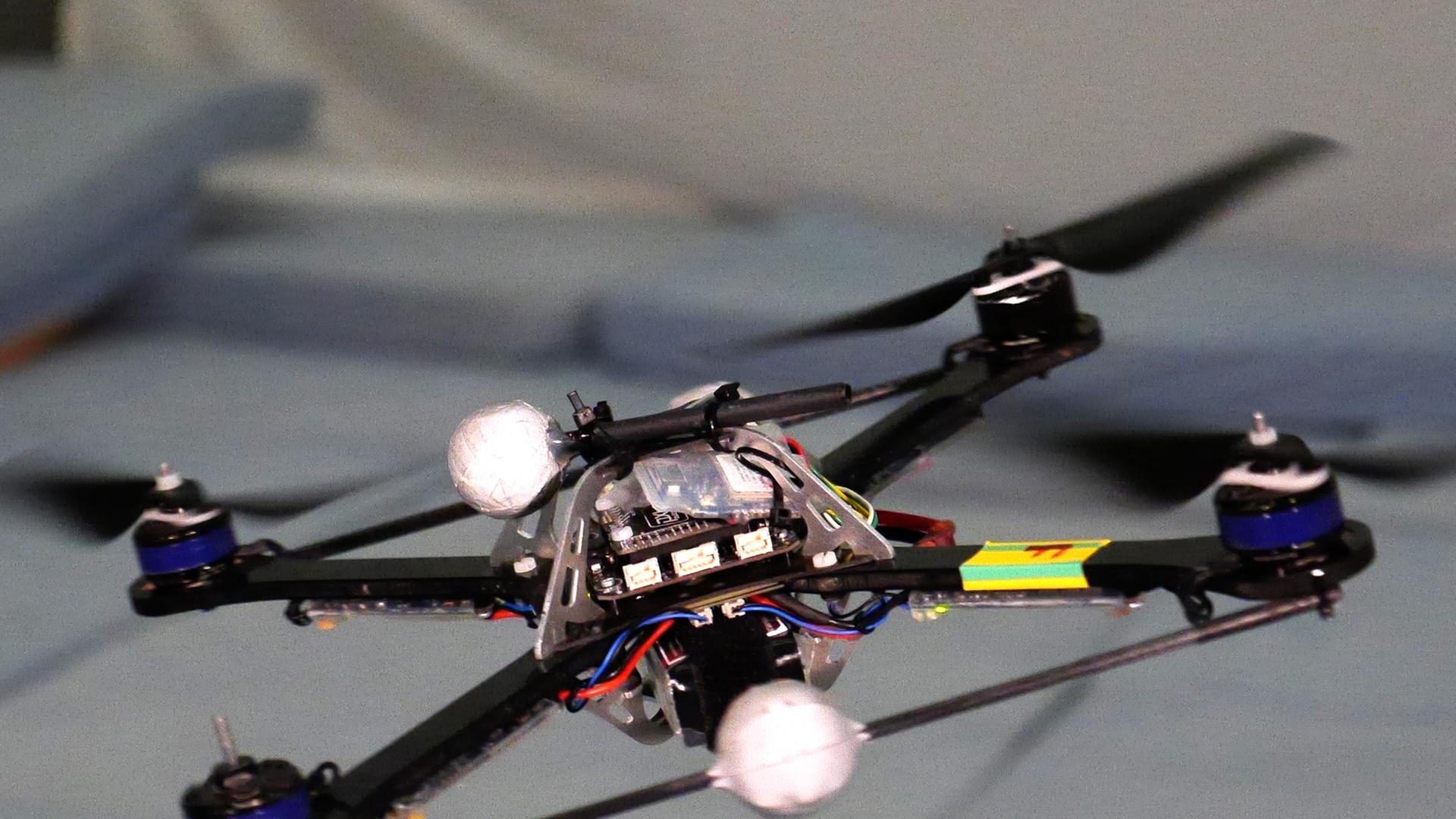

Bei einem der Testszenarien mussten Hubschrauberpiloten während einer Mission im Flugsimulator eine Flotte von drei Drohnen freisetzen und bestimmte Erkundungsaufgaben durchführen lassen.

"Zunächst einmal hat er die Aufgabe, diese unbemannten Luftfahrzeuge überhaupt einzusetzen. Denen also zu sagen, was sie zu tun haben, wo sie hinzufliegen haben, wie sie ihre Sensoren einzusetzen haben. Das ist der eine Teil. Und wenn sie dann mal richtig eingesetzt sind, dann kommt eben ein Sensorbild zurück. Das können Fotos sein, aber auch Live-Videos oder aufbereitete Sensorinformationen. Und die gilt es dann auszuwerten und im Hinblick auf Missionsrelevanz zu analysieren."

Den Automationsgrad des Aufklärungsgeschwaders variierten die Forscher während der Versuche: Von sehr niedrig bis zu einem Niveau, wo das Drohnen-Trio seine Aufgaben untereinander aushandelte – praktisch ohne Zutun des Piloten. Das Ergebnis der Tests zeigte: Wenn die Piloten zu viel selbst regeln müssen, sind sie überfordert. Doch auch zu viel Automatisierung berge Gefahren, erklärt Axel Schulte. Zum Beispiel den Verlust des Situationsbewusstseins.

Belastungswettbewerb zwischen Mensch und Maschine

"Man weiß eigentlich gar nicht mehr so genau, was die Maschine eigentlich macht und gewinnt dann sozusagen eine Art Gleichgültigkeit darüber, was da passiert. Das ist ein Effekt. Aber gerade im Bereich militärischer Missionen gibt's noch andere Effekte, die eben in die Richtung gehen, dass die Automation dann quasi Entscheidungen bis zu einem gewissen Grade vorbereitet, dass der Mensch geneigt ist, dieser Entscheidung einfach zu folgen – und selber nicht mehr in dem Maße die Situation analysiert, wie es eigentlich sein sollte."

Und das kann tödliche Folgen haben. Etwa wenn es um die Frage geht, ob ein im Fadenkreuz befindlicher Lastwagen ein militärisches Ziel darstellt oder nicht. Der Fall Kunduz, wo Bundeswehr-Soldaten zwei von Zivilisten umringte Tanklaster in einem Fluss bombardieren ließen, hat gezeigt, wie schwer es im Ernstfall sein kann, unter Zeitdruck die richtige Entscheidung zu treffen. Die Kampfpiloten, die in München im Simulator saßen, bekamen deshalb gezielt Fallen gestellt. Ab und an nahm ihre Zielautomatik zum Beispiel ein Fahrzeug mit einem roten Kreuz darauf ins Visier.

"Das war ein ganz gezieltes Experiment, was wir gemacht haben. Wo wir also sporadisch solche false targets eingespielt haben – also Ziele, die eben nicht vertretbar bekämpft werden sollen und dürfen – um zu sehen, wie Effekte dieser Hochautomatisierung eventuell aussehen könnten. Wir hatten in unseren Experimenten die glückliche Situation, dass unsere Kampfflugzeugpiloten samt und sonders die Situation gemeistert haben. Aber man sieht natürlich auch, dass hier doch ein gewisser Denkprozess nötig ist. Denn natürlich ist so ein Kampfflugzeugpilot in einem gewissen Target-Tunnel, wenn man so will. Und wenn man da rauskommen will, das erfordert ein gewisses Freischwimmen geistiger Art."

Um es zu unterstützen, sei es wichtig, die Piloten in hohem Maß an Entscheidungen zu beteiligen, betont Axel Schulte. Außerdem müsse man ihnen die Möglichkeit geben, den Automatisierungsgrad der Assistenzsysteme aktiv anzupassen – je nach Situation und Arbeitsbelastung im Cockpit.

"Es gibt ja dieses Schlagwort von den autonomen Systemen, die genau das Gegenteil bewirken sollen – nämlich einen sehr geringen Grad an Beteiligung des Menschen. Wir suchen nach Lösungen, die einerseits den Menschen entlasten, aber trotzdem seine ständige Beteiligung bei der Durchführung der Aufgabe erfordern." Denn nur so können Mensch und Maschine im militärischen Umfeld verantwortlich zusammen arbeiten.