Die USA sehen sich im Wettbewerb mit China im Hintertreffen, wenn es um Künstliche Intelligenz in der Sicherheits- und Militärtechnik geht. Mit massiven Investitionen soll gegengesteuert werden. Weltweit nutzen Militärs schon heute KI in Waffensystemen und für die strategische Planung sowie zur Spionage. Gleichzeitig werden Cyberwars ausgetragen, bei denen Gesellschaften mit Falschinformationen angegriffen und kritische Infrastrukturen lahmgelegt werden. Die Verabschiedung und Umsetzung von Normen für den Einsatz der Technik scheint dagegen langsamer voran zu kommen.

Wie kann konkrete Innovation gegen oft abstrakte Gefahren abgewogen werden? Die Kontrolle von KI gilt als schwierig. Es ist unklar, wie sich unabhängig überprüfen ließe, ob ein Waffensystem zukünftigen Regeln für den ethischen Einsatz von KI entspricht, ohne die geheime Funktionsweise des Waffensystems offenzulegen. Das Feature zeigt auf, wie sich Abschreckungs- und Bedrohungspotenziale global durch KI verschieben können und wie es um die internationale Zusammenarbeit bei der Entwicklung der Technik sowie bei ihrer Regulierung bestellt ist.

Wie kann konkrete Innovation gegen oft abstrakte Gefahren abgewogen werden? Die Kontrolle von KI gilt als schwierig. Es ist unklar, wie sich unabhängig überprüfen ließe, ob ein Waffensystem zukünftigen Regeln für den ethischen Einsatz von KI entspricht, ohne die geheime Funktionsweise des Waffensystems offenzulegen. Das Feature zeigt auf, wie sich Abschreckungs- und Bedrohungspotenziale global durch KI verschieben können und wie es um die internationale Zusammenarbeit bei der Entwicklung der Technik sowie bei ihrer Regulierung bestellt ist.

Manuskript im Wortlaut

„Die sich zurückziehenden Streitkräfte wurden aufgespürt und angegriffen: von unbemannten Kampfflugzeugen oder tödlichen autonomen Waffensystemen wie dem STM Kargu-2 und anderer Munition in Wartestellung.“ (Zitat aus UN-Bericht zu Libyen, 2021)

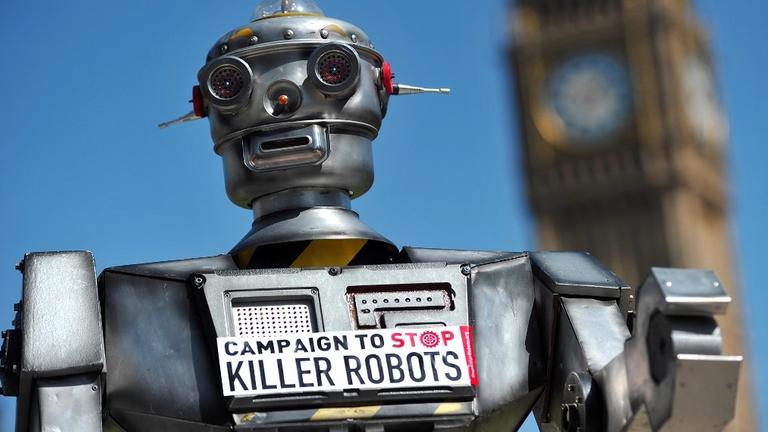

Künstliche Intelligenz für militärische Anwendungen – da geht es oft um dystopische Szenarien mit autonomen Drohnen und Killerrobotern. Bei den Vereinten Nationen laufen Verhandlungen, sie zu ächten. Es gibt viel weniger Aufsehen erregende Einsatzszenarien für KI im Militär, die viel näher an der Realität sind – die oft harmlos scheinen, aber dennoch die Gefahr bergen, dass die Welt aus den Fugen gerät.

Künstliche Intelligenz für militärische Anwendungen – da geht es oft um dystopische Szenarien mit autonomen Drohnen und Killerrobotern. Bei den Vereinten Nationen laufen Verhandlungen, sie zu ächten. Es gibt viel weniger Aufsehen erregende Einsatzszenarien für KI im Militär, die viel näher an der Realität sind – die oft harmlos scheinen, aber dennoch die Gefahr bergen, dass die Welt aus den Fugen gerät.

Geostrategischer Wettstreit zwischen USA und China

„Militärs sind gigantische Bürokratien. Ähnlich wie Großunternehmen müssen sie am Laufen gehalten werden.“ Margarita Konaev sagt, das sei wohl eher die langweilige Seite von KI im Militär. „Es birgt nicht so viel Sprengstoff wie eine Killer-Drohne, die selbst ihr Ziel findet und entscheidet, was sie macht. Aber jegliche Verbesserung in der Logistik und der Unterstützung militärischer Operationen, die dabei hilft, den Motor im Verteidigungsministerium am Laufen zu halten, ist absolut zentral und entscheidend für die militärische Effektivität.“

Konaev forscht am CSET, dem Zentrum für Sicherheit und sich entwickelnde Technik an der Georgetown-Universität in Washington DC. Dass ihr Büro keine zehn Gehminuten entfernt ist vom Kapitol, ist kein Zufall. Sie und andere aus ihrer Denkfabrik beraten regelmäßig Abgeordnete und Regierungsbeamte. Das Ziel sei, Rahmenbedingungen so zu stecken, dass die Neuentwicklungen sicher seien, demokratischen Werten dienten und den strategischen Interessen der USA.

„Wir leben in einer Zeit, in der geostrategische Interessen bestimmen, wie wir über Technik und die Entwicklung von Technik denken. In unserem Wettstreit mit China spielt Technik eine große Rolle und Militärtechnik ist ein wichtiger Teil davon. Wir könnten unter Druck geraten, diese Technik viel schneller einzusetzen als wir sollten.“

Konaev forscht am CSET, dem Zentrum für Sicherheit und sich entwickelnde Technik an der Georgetown-Universität in Washington DC. Dass ihr Büro keine zehn Gehminuten entfernt ist vom Kapitol, ist kein Zufall. Sie und andere aus ihrer Denkfabrik beraten regelmäßig Abgeordnete und Regierungsbeamte. Das Ziel sei, Rahmenbedingungen so zu stecken, dass die Neuentwicklungen sicher seien, demokratischen Werten dienten und den strategischen Interessen der USA.

„Wir leben in einer Zeit, in der geostrategische Interessen bestimmen, wie wir über Technik und die Entwicklung von Technik denken. In unserem Wettstreit mit China spielt Technik eine große Rolle und Militärtechnik ist ein wichtiger Teil davon. Wir könnten unter Druck geraten, diese Technik viel schneller einzusetzen als wir sollten.“

Mehr zum Thema

Deepfakes: Wenn Künstliche Intelligenz Geschichte, Stars und Präsidenten fälscht

Das neue atomare Wettrüsten: Künstlich intelligent

Die Zukunft des Menschen: Das Versprechen der Künstlichen Intelligenz

Künstliche Intelligenz und Menschenwürde - Politik muss das Heft in die Hand nehmen

Deepfakes: Wenn Künstliche Intelligenz Geschichte, Stars und Präsidenten fälscht

Das neue atomare Wettrüsten: Künstlich intelligent

Die Zukunft des Menschen: Das Versprechen der Künstlichen Intelligenz

Künstliche Intelligenz und Menschenwürde - Politik muss das Heft in die Hand nehmen

Vorbehalte gegen die Zusammenarbeit mit dem Militär

Die Vereinigten Staaten definieren sich immer stärker über ihre Abgrenzung zu China. Im März 2021 veröffentlichte die “Nationale Sicherheitskommission für Künstliche Intelligenz” der USA ihren Abschlussbericht. Auf den 756 Seiten wird China mehr als 300 Mal erwähnt. Grundton: Die USA könnten bei Künstlicher Intelligenz den Anschluss verlieren.

Die Kommission fordert, dass das Pentagon bis 2025 “AI-ready” werden solle. Heißt: „Soldaten im Einsatz haben den Umgang mit Digitaltechnik gelernt und können auf digitale Infrastruktur und Software zugreifen, die nötig sind für eine allgegenwärtige Integration von KI in Ausbildung, Übungen und Einsätzen.“

Um die nationale Sicherheit der USA im KI-Zeitalter zu gewährleisten, soll die ganze Gesellschaft einbezogen werden. Die Zusammenarbeit mit innovativen Unternehmen soll ausgebaut werden, die Ausbildung von Fachleuten verstärkt, ausländische Fachleute sollen angeworben werden. Das hat sich schon in der Vergangenheit als schwierig erwiesen. Top-KI-Expertinnen und -Experten arbeiten oft lieber im Silicon Valley als für das US-Militär. Und Kooperationsprojekte können für die Unternehmen riskant sein, wie ein Projekt aus dem Pentagon zeigt.

“Project Maven” startet 2017. Darin soll Künstliche Intelligenz entwickelt werden, die Luftaufnahmen von Drohnen oder Bilder von Aufklärungssatelliten auswerten kann. Ein großer Teil der Entwicklung dieser Bilderkennungstechnik soll bei Google stattfinden. Doch Mitarbeiterinnen und Mitarbeiter des Unternehmens weigern sich und protestieren, einige kündigen. 2018 steigt Google aus Project Maven aus. Seither sollen Amazon und Microsoft den rund 50 Millionen Dollar großen Auftrag unter sich aufgeteilt haben.

Um die nationale Sicherheit der USA im KI-Zeitalter zu gewährleisten, soll die ganze Gesellschaft einbezogen werden. Die Zusammenarbeit mit innovativen Unternehmen soll ausgebaut werden, die Ausbildung von Fachleuten verstärkt, ausländische Fachleute sollen angeworben werden. Das hat sich schon in der Vergangenheit als schwierig erwiesen. Top-KI-Expertinnen und -Experten arbeiten oft lieber im Silicon Valley als für das US-Militär. Und Kooperationsprojekte können für die Unternehmen riskant sein, wie ein Projekt aus dem Pentagon zeigt.

“Project Maven” startet 2017. Darin soll Künstliche Intelligenz entwickelt werden, die Luftaufnahmen von Drohnen oder Bilder von Aufklärungssatelliten auswerten kann. Ein großer Teil der Entwicklung dieser Bilderkennungstechnik soll bei Google stattfinden. Doch Mitarbeiterinnen und Mitarbeiter des Unternehmens weigern sich und protestieren, einige kündigen. 2018 steigt Google aus Project Maven aus. Seither sollen Amazon und Microsoft den rund 50 Millionen Dollar großen Auftrag unter sich aufgeteilt haben.

Geheimhaltung und Abschottung erschwert Datenaustausch

Während die amerikanischen Streitkräfte offenbar mehr Aufklärungsdaten haben als sie derzeit auswerten können, gibt es für andere KI-Anwendungen nicht genug Daten. Margarita Konaev: „Sie können natürlich keinen Machine-Learning-Algorithmus mit Ihrem kleinen grünen Notizbuch trainieren.“

Oft liegen Aufzeichnungen nicht digital vor. Wo Daten existieren, seien sie oft nicht gelabelt, also so beschriftet, dass ein Algorithmus verstehen könnte, um was es sich handelt.

„Das nächste Problem sind Silos. Wie gesagt, das Verteidigungsministerium ist riesig und es gibt verschiedene Geheimhaltungsstufen und Zugriffsrechte über Millionen von Abteilungen hinweg - ich übertreibe, aber viele verschiedene Abteilungen. Da ist eine Zusammenarbeit schwierig, weil die nicht so einfach Daten austauschen können.“

Dieses Problem potenziert sich, wenn die Zusammenarbeit über das Pentagon hinausgehen soll, etwa bei gemeinsamen Manövern und Einsätzen der NATO-Streitkräfte. Dann müssen sie auch in der Lage sein, Daten auszutauschen.

„Je größer der technologische Abstand zwischen Alliierten innerhalb der NATO, desto stärker ist die Interoperabilität gefährdet, was wiederum den Erfolg von Einsätzen beeinträchtigt und sich somit auf den Nutzen der Allianz insgesamt auswirkt. Eine große Sorge ist, dass US-Verbündete in Europa ins Hintertreffen geraten, Einsätze dadurch weniger effektiv werden, das Vertrauen zwischen den Alliierten leidet und die Allianz geschwächt wird.“

Oft liegen Aufzeichnungen nicht digital vor. Wo Daten existieren, seien sie oft nicht gelabelt, also so beschriftet, dass ein Algorithmus verstehen könnte, um was es sich handelt.

„Das nächste Problem sind Silos. Wie gesagt, das Verteidigungsministerium ist riesig und es gibt verschiedene Geheimhaltungsstufen und Zugriffsrechte über Millionen von Abteilungen hinweg - ich übertreibe, aber viele verschiedene Abteilungen. Da ist eine Zusammenarbeit schwierig, weil die nicht so einfach Daten austauschen können.“

Dieses Problem potenziert sich, wenn die Zusammenarbeit über das Pentagon hinausgehen soll, etwa bei gemeinsamen Manövern und Einsätzen der NATO-Streitkräfte. Dann müssen sie auch in der Lage sein, Daten auszutauschen.

„Je größer der technologische Abstand zwischen Alliierten innerhalb der NATO, desto stärker ist die Interoperabilität gefährdet, was wiederum den Erfolg von Einsätzen beeinträchtigt und sich somit auf den Nutzen der Allianz insgesamt auswirkt. Eine große Sorge ist, dass US-Verbündete in Europa ins Hintertreffen geraten, Einsätze dadurch weniger effektiv werden, das Vertrauen zwischen den Alliierten leidet und die Allianz geschwächt wird.“

Unterschiedlicher Entwicklungsstand in Europa

„Deshalb wird in der NATO gerade viel Aufwand getrieben, um Standardisierung und Harmonisierung voranzutreiben“, sgt Maaike Verbruggen, Doktorandin an der Freien Universität Brüssel. Sie forscht zu technischen Innovationen im Militär und deren Kontrolle. Mehr noch als die Unterschiede zwischen den USA und Europa beunruhigt sie der unterschiedliche Entwicklungsstand der Armeen in Europa.

„Es gibt gigantische Unterschiede zwischen europäischen Staaten. Frankreichs KI-Anstrengungen halte ich für unterschätzt, während andere Länder ihre Armeen fast gar nicht digitalisiert haben, vor allem in Osteuropa. Es fehlt schlicht das Geld für Modernisierungen.“

Das gleiche Problem hat auch Ulrike Franke ausgemacht. Sie beschäftigt sich bei der Denkfabrik “European Council on Foreign Relations” mit den Auswirkungen von Technik auf europäische Geopolitik:

„Wir haben einige Länder, wie insbesondere Frankreich, aber auch Großbritannien, zum gewissen Teil die Niederlande, ein paar Länder, die einigermaßen offensiv an die Thematik herangehen. Also Frankreich hat schon seit längerem eine militärische KI-Strategie, identifiziert Militärtechnologie auch als wichtiges Thema in der nationalen KI-Strategie. Dann gibt es andere Länder, die teilweise aufgrund ihrer Größe da noch nicht so sehr sich mit beschäftigen. Und es gibt natürlich in vielen Ländern, und da würde ich auch Deutschland hinzuzählen, eine gewisse Abneigung, die dazu führt, dass die öffentliche und die politische Debatte sich doch sehr stark eher interessiert für zum Beispiel mögliche Verbote, was solche Systeme angeht und vielleicht etwas weniger, wie man Elemente davon auch selbst einsetzen will.“

„Es gibt gigantische Unterschiede zwischen europäischen Staaten. Frankreichs KI-Anstrengungen halte ich für unterschätzt, während andere Länder ihre Armeen fast gar nicht digitalisiert haben, vor allem in Osteuropa. Es fehlt schlicht das Geld für Modernisierungen.“

Das gleiche Problem hat auch Ulrike Franke ausgemacht. Sie beschäftigt sich bei der Denkfabrik “European Council on Foreign Relations” mit den Auswirkungen von Technik auf europäische Geopolitik:

„Wir haben einige Länder, wie insbesondere Frankreich, aber auch Großbritannien, zum gewissen Teil die Niederlande, ein paar Länder, die einigermaßen offensiv an die Thematik herangehen. Also Frankreich hat schon seit längerem eine militärische KI-Strategie, identifiziert Militärtechnologie auch als wichtiges Thema in der nationalen KI-Strategie. Dann gibt es andere Länder, die teilweise aufgrund ihrer Größe da noch nicht so sehr sich mit beschäftigen. Und es gibt natürlich in vielen Ländern, und da würde ich auch Deutschland hinzuzählen, eine gewisse Abneigung, die dazu führt, dass die öffentliche und die politische Debatte sich doch sehr stark eher interessiert für zum Beispiel mögliche Verbote, was solche Systeme angeht und vielleicht etwas weniger, wie man Elemente davon auch selbst einsetzen will.“

Wer will schon Killer-Roboter?

Die deutsche KI-Strategie erwähnt die militärische Komponente nur am Rande. Währenddessen kümmern sich andere Staaten aktiv darum, ihre Armeen mit KI effizienter zu führen, mit KI die Präzision von Waffen zu erhöhen oder ihren Militärs mit KI strategische Vorteile zu verschaffen. Das kann man ablehnen, ignorieren sollte man es nicht, sagt Ulrike Franke:

„Das darf meines Erachtens nicht dazu führen, dass man sich mit der Thematik dann nicht mehr auseinandersetzt und sie einfach grundsätzlich ablehnt, weil das, und das muss sich halt jeder klarmachen, der jetzt zuhört und sagt, ja, aber ich will keine Killer-Roboter, und ich finde das alles ganz schrecklich und wir sollen nichts davon machen. Das ist ja eine legitime Position. Nur man darf da nicht aufhören, weil es ja eine neue Herausforderung, Bedrohungslage, Abschreckung etc. gibt.“

Eine mögliche neue Bedrohung sehen Fachleute darin, dass KI Entscheidungsprozesse beschleunigt. Wenn die Aufklärung schneller geht, könnte ein Militärschlag wahrscheinlicher werden. Vergeht hingegen mehr Zeit, kühlt sich der Konflikt im besten Fall wieder ab.

„Das darf meines Erachtens nicht dazu führen, dass man sich mit der Thematik dann nicht mehr auseinandersetzt und sie einfach grundsätzlich ablehnt, weil das, und das muss sich halt jeder klarmachen, der jetzt zuhört und sagt, ja, aber ich will keine Killer-Roboter, und ich finde das alles ganz schrecklich und wir sollen nichts davon machen. Das ist ja eine legitime Position. Nur man darf da nicht aufhören, weil es ja eine neue Herausforderung, Bedrohungslage, Abschreckung etc. gibt.“

Eine mögliche neue Bedrohung sehen Fachleute darin, dass KI Entscheidungsprozesse beschleunigt. Wenn die Aufklärung schneller geht, könnte ein Militärschlag wahrscheinlicher werden. Vergeht hingegen mehr Zeit, kühlt sich der Konflikt im besten Fall wieder ab.

Kann KI die Vergeltungsschlags-Doktrin aushebeln?

Eine noch bedeutendere Veränderung der Bedrohungslage könnte bevorstehen, wenn KI-Werkzeuge die derzeitige Abschreckung durch Atomwaffen aushebeln. Atomare Abschreckung beruht darauf, dass Atommächte nicht wissen, wo sich die Atomwaffen des Gegners befinden. Gelingt es bei einem Erstschlag nicht, das feindliche Atomwaffenarsenal zu vernichten, droht Vergeltung. Entscheidendes Element dieser Strategie sind U-Boote. Ihr Standort ist schwer auszumachen und ändert sich permanent. Wird ein Land mit Atomwaffen angegriffen, könnte von dessen U-Booten immer noch ein Vergeltungsschlag ausgehen.

Sind Anstrengungen wie Project Maven erfolgreich, werden Algorithmen Satellitendaten und andere Sensordaten schnell und massenweise auswerten. Dadurch könnten die Standorte der U-Boote offenbart werden. Im Jargon heißt das: “die Ozeane werden transparent”. Ulrike Franke: „Das würde einen wirklich fundamentalen Teil der nuklearen Abschreckungs-Architektur, auf die unsere Sicherheit ja - wie sagt man so schön, ‚for better or worse‘, eben aufbaut, unterlaufen.“

Zumindest, wenn man davon ausgeht, dass die Abschreckungs-Doktrin überhaupt funktioniert. Maaike Verbruggen: „Ich bin skeptisch, ob Atomkriege wirklich wegen der Existenz von Atomwaffen in anderen Ländern abgewendet werden. Ich halte Atomwaffen für gefährlich. Durch KI könnte es weitere Destabilisierung geben, aber keine radikale Destabilisierung, weil ich von vornherein nicht an die Verlässlichkeit von nuklearer Abschreckung glaube.“

Sind Anstrengungen wie Project Maven erfolgreich, werden Algorithmen Satellitendaten und andere Sensordaten schnell und massenweise auswerten. Dadurch könnten die Standorte der U-Boote offenbart werden. Im Jargon heißt das: “die Ozeane werden transparent”. Ulrike Franke: „Das würde einen wirklich fundamentalen Teil der nuklearen Abschreckungs-Architektur, auf die unsere Sicherheit ja - wie sagt man so schön, ‚for better or worse‘, eben aufbaut, unterlaufen.“

Zumindest, wenn man davon ausgeht, dass die Abschreckungs-Doktrin überhaupt funktioniert. Maaike Verbruggen: „Ich bin skeptisch, ob Atomkriege wirklich wegen der Existenz von Atomwaffen in anderen Ländern abgewendet werden. Ich halte Atomwaffen für gefährlich. Durch KI könnte es weitere Destabilisierung geben, aber keine radikale Destabilisierung, weil ich von vornherein nicht an die Verlässlichkeit von nuklearer Abschreckung glaube.“

Rüstungswettlauf und Eskalationsdynamik

Die Wirkung von Künstlicher Intelligenz auf konventionelle Waffen hält Maaike Verbruggen für relevanter. Raketen beispielsweise lassen sich dank KI besser steuern. Das erhöht ihre Reichweite. Kampfflugzeuge, wie das von Deutschland und Frankreich entwickelte FCAS - Future Combat Air System - sollen durch KI neue Fähigkeiten bekommen. Wenn FCAS in etwa 20 Jahren den Eurofighter ablöst, soll es im Verbund mit unbemannten Drohnen fliegen können. Die Systeme erlauben komplexere Manöver, reagieren schneller, werden autonomer. Vor allem durch die Autonomie sieht Ulrike Franke die Gefahr eines KI-getriebenen Rüstungswettlaufs:

„Wenn ein Land, ein Akteur anfängt, gewisse Systeme anzuschaffen, dann sehen sich Gegner gezwungen, diese Systeme auch anzuschaffen, um sich dagegen zu schützen. Also es geht nicht einfach nur darum, alle schaffen die sich an, weil die der Meinung sind, die funktionieren gut, sondern es gibt so eine Art Zwang. Der eine zieht vor und dann muss der andere nachziehen und es gibt so eine Eskalationsdynamik, die extrem teuer werden kann und vor allen Dingen auch sehr destabilisierend. Also dass man eben so eine Situation hat, wo man sagt: Jetzt bin ich gerade vorne, jetzt muss ich den anderen angreifen, weil sonst zieht der wieder nach und es wird alles schwieriger.“

Es gibt also einen Mix aus Begeisterung für die neue Technik und ihre Möglichkeiten, und dem Narrativ eines KI-Wettlaufs, den kein Land verlieren will. Mit einer sich verändernden geostrategischen Lage wächst der Druck, KI einzusetzen, bevor sie wirklich einsatzbereit ist. Verschiedene Staaten dürften diesem Druck unterschiedlich schnell nachgeben. Ulrike Franke:

„Wenn wir einen zunehmenden geopolitischen Wettbewerb zwischen den USA und China bekommen und Technologie dann ein elementarer Faktor wird, dann kann es passieren, dass wir wenig geprüfte militärische KI-Systeme plötzlich eingesetzt sehen, weil sich da jemand einen Vorteil davon verspricht. Und das kann natürlich potenziell katastrophale Resultate und Konsequenzen haben.“

„Wenn ein Land, ein Akteur anfängt, gewisse Systeme anzuschaffen, dann sehen sich Gegner gezwungen, diese Systeme auch anzuschaffen, um sich dagegen zu schützen. Also es geht nicht einfach nur darum, alle schaffen die sich an, weil die der Meinung sind, die funktionieren gut, sondern es gibt so eine Art Zwang. Der eine zieht vor und dann muss der andere nachziehen und es gibt so eine Eskalationsdynamik, die extrem teuer werden kann und vor allen Dingen auch sehr destabilisierend. Also dass man eben so eine Situation hat, wo man sagt: Jetzt bin ich gerade vorne, jetzt muss ich den anderen angreifen, weil sonst zieht der wieder nach und es wird alles schwieriger.“

Es gibt also einen Mix aus Begeisterung für die neue Technik und ihre Möglichkeiten, und dem Narrativ eines KI-Wettlaufs, den kein Land verlieren will. Mit einer sich verändernden geostrategischen Lage wächst der Druck, KI einzusetzen, bevor sie wirklich einsatzbereit ist. Verschiedene Staaten dürften diesem Druck unterschiedlich schnell nachgeben. Ulrike Franke:

„Wenn wir einen zunehmenden geopolitischen Wettbewerb zwischen den USA und China bekommen und Technologie dann ein elementarer Faktor wird, dann kann es passieren, dass wir wenig geprüfte militärische KI-Systeme plötzlich eingesetzt sehen, weil sich da jemand einen Vorteil davon verspricht. Und das kann natürlich potenziell katastrophale Resultate und Konsequenzen haben.“

Rüstungskontrolle bei KI schwierig bis unmöglich

Margarita Konaev: „Ich glaube, dass es zumindest in westlichen Demokratien Regularien und Prozesse gibt, die dazu da sind sicherzustellen, dass Waffensysteme und Soldaten sich dem Völkerrecht entsprechend verhalten. Die Entwicklung von Künstlicher Intelligenz sollte diesem Rahmen ebenfalls folgen.“

Doch genau wie KI im zivilen Sektor existierende Regelwerke an ihre Grenzen bringt, stellt sie auch bei der Rüstungskontrolle eine Herausforderung dar. Maaike Verbruggen:

„KI betrifft viele Rüstungskontroll-Konventionen. Wir sehen die Entwicklung von Smart Guns. Was bedeutet das für die Kontrolle von Kleinwaffen und leichten Waffen? Die Kombination von KI und Biotechnologie: Was bedeutet das für die Biowaffenkontrolle? KI im Weltraum, Kontrolle von Weltraumwaffen… Eine generelle KI-Kontroll-Konvention würde nicht super viel Sinn machen, weil KI so breit ist und die Bedenken auch je nach Kontext, je nach Waffe andere sein können.“

Die vielleicht größte Herausforderung dabei: KI ist Software. Man kann sie nicht zählen wie Atomsprengköpfe. Man kann sie nicht sehen und nicht anfassen. Man kann einem System - sei es eine Rakete oder eine Aufklärungsdrohne - nicht ansehen, ob sie KI einsetzt, in welchem Umfang, welche Daten dabei ausgewertet und welche Entscheidungen getroffen werden. Maaike Verbruggen:

„Das ist ein großes Problem bei meiner Forschung, aber es ist auch für Staaten ein Problem. Wir haben beim Wettrüsten im Kalten Krieg gesehen, dass die USA die Stärke der Sowjetunion teilweise vollkommen falsch eingeschätzt haben. Bei KI wird das noch schwieriger. Das könnte dann wieder dazu führen, dass Staaten die Ausrüstung ihrer Feinde überschätzen, um kein Risiko einzugehen. Auch das könnte destabilisierend wirken. “

Ihre Forschung und wohl auch die Verteidigungspolitik stützen sich auf Indikatoren: Informationen über Forschungsprojekte. Patente, die angemeldet werden. Pressemitteilungen. Aber wieviel KI Chinas Streitkräfte wirklich einsetzen, dürfte auch für die USA schwer festzustellen sein. Worst-Case-Szenarien aber führen dazu, dass mehr Geld in militärische KI-Entwicklung gesteckt und aufgerüstet wird.

Doch genau wie KI im zivilen Sektor existierende Regelwerke an ihre Grenzen bringt, stellt sie auch bei der Rüstungskontrolle eine Herausforderung dar. Maaike Verbruggen:

„KI betrifft viele Rüstungskontroll-Konventionen. Wir sehen die Entwicklung von Smart Guns. Was bedeutet das für die Kontrolle von Kleinwaffen und leichten Waffen? Die Kombination von KI und Biotechnologie: Was bedeutet das für die Biowaffenkontrolle? KI im Weltraum, Kontrolle von Weltraumwaffen… Eine generelle KI-Kontroll-Konvention würde nicht super viel Sinn machen, weil KI so breit ist und die Bedenken auch je nach Kontext, je nach Waffe andere sein können.“

Die vielleicht größte Herausforderung dabei: KI ist Software. Man kann sie nicht zählen wie Atomsprengköpfe. Man kann sie nicht sehen und nicht anfassen. Man kann einem System - sei es eine Rakete oder eine Aufklärungsdrohne - nicht ansehen, ob sie KI einsetzt, in welchem Umfang, welche Daten dabei ausgewertet und welche Entscheidungen getroffen werden. Maaike Verbruggen:

„Das ist ein großes Problem bei meiner Forschung, aber es ist auch für Staaten ein Problem. Wir haben beim Wettrüsten im Kalten Krieg gesehen, dass die USA die Stärke der Sowjetunion teilweise vollkommen falsch eingeschätzt haben. Bei KI wird das noch schwieriger. Das könnte dann wieder dazu führen, dass Staaten die Ausrüstung ihrer Feinde überschätzen, um kein Risiko einzugehen. Auch das könnte destabilisierend wirken. “

Ihre Forschung und wohl auch die Verteidigungspolitik stützen sich auf Indikatoren: Informationen über Forschungsprojekte. Patente, die angemeldet werden. Pressemitteilungen. Aber wieviel KI Chinas Streitkräfte wirklich einsetzen, dürfte auch für die USA schwer festzustellen sein. Worst-Case-Szenarien aber führen dazu, dass mehr Geld in militärische KI-Entwicklung gesteckt und aufgerüstet wird.

War in Libyen autonomes KI-Waffensystem im Einsatz?

Dass es schwierig ist, KI zu erkennen, betrifft nicht nur die Potenziale einer feindlichen Armee. Selbst wenn die Technik eingesetzt wird - und möglicherweise völkerrechtswidrig eingesetzt wird - ist nicht offensichtlich, ob KI im Spiel war. Das zeigt sich an einem Vorfall in Libyen.

Mariarosaria Taddeo forscht am Oxford Internet Institute und ist außerdem Fellow des Entwicklungslabors des britischen Verteidigungsministeriums am Alan Turing Institut: „Wir wissen aus einem Anfang 2021 veröffentlichten UN-Bericht, dass KI in Waffensystemen in Libyen eingesetzt wurde. Obwohl es international breite Unterstützung für ein Verbot dieser Waffen gibt, ist das passiert. Das ist sehr besorgniserregend und enttäuschend.“

„Diese tödlichen autonomen Waffensysteme waren darauf programmiert, Ziele anzugreifen, ohne dass eine Datenverbindung zu einem Bediener bestehen muss. Faktisch eine wahre 'feuern, vergessen und finden'-Technik.“ (Zitat aus dem UN-Bericht)

Ulrike Franke: „Das ist unglaublich schwer nachzuprüfen, weil das einzige, was wir wissen, ist: Es gibt dieses System, worum es geht, und dem werden gewisse KI-unterstützte autonome Funktionen zugeschrieben. Erstens wissen wir gar nicht, ob es wirklich kann, was behauptet wird. Das ist natürlich immer so eine Frage. Und wir wissen auch gar nicht, wie es dann tatsächlich eingesetzt wurde in Libyen. Nur weil ein System zum Beispiel eben relativ autonom handeln kann, heißt es nicht, dass es das muss.“

Die Türkei, aus der die Drohne stammt, die in Libyen im Einsatz war, will sich nicht in die Karten schauen lassen. Kein Militär und kein Waffenproduzent würde wohl Kontrolleuren Zugriff auf seine Algorithmen geben wollen. Und selbst wenn, bleibt die Frage, ob die möglicherweise in Zukunft von Waffenkontrolleuren freigegebenen Algorithmen dieselben sind, die später zum Einsatz kommen.

„Diese tödlichen autonomen Waffensysteme waren darauf programmiert, Ziele anzugreifen, ohne dass eine Datenverbindung zu einem Bediener bestehen muss. Faktisch eine wahre 'feuern, vergessen und finden'-Technik.“ (Zitat aus dem UN-Bericht)

Ulrike Franke: „Das ist unglaublich schwer nachzuprüfen, weil das einzige, was wir wissen, ist: Es gibt dieses System, worum es geht, und dem werden gewisse KI-unterstützte autonome Funktionen zugeschrieben. Erstens wissen wir gar nicht, ob es wirklich kann, was behauptet wird. Das ist natürlich immer so eine Frage. Und wir wissen auch gar nicht, wie es dann tatsächlich eingesetzt wurde in Libyen. Nur weil ein System zum Beispiel eben relativ autonom handeln kann, heißt es nicht, dass es das muss.“

Die Türkei, aus der die Drohne stammt, die in Libyen im Einsatz war, will sich nicht in die Karten schauen lassen. Kein Militär und kein Waffenproduzent würde wohl Kontrolleuren Zugriff auf seine Algorithmen geben wollen. Und selbst wenn, bleibt die Frage, ob die möglicherweise in Zukunft von Waffenkontrolleuren freigegebenen Algorithmen dieselben sind, die später zum Einsatz kommen.

Deep Fakes können bewaffnete Konflikte auslösen

Es sind nicht nur physische Waffen, in denen KI problematisch sein kann, sondern auch Propagandawaffen. Auch beim folgenden Fall wird darüber gestritten, ob KI im Spiel war oder nicht. Die Frage selbst birgt Zündstoff.

31. Dezember 2018. Gabuns Präsident Ali Bongo Ondimba veröffentlicht seine Neujahrsansprache. Es ist sein erster öffentlicher Auftritt seit Monaten. Zuletzt gesehen wurde er im Oktober, bei einer Konferenz in Saudi-Arabien. Während der Konferenz ist er aus unbekannten Gründen in ein Krankenhaus eingeliefert worden. Seither kursieren widersprüchliche Angaben über Ali Bongos Gesundheitszustand. Lebt er überhaupt noch? Dann erscheint er plötzlich in der rund zweiminütigen Neujahrsansprache. Doch der Präsident sieht anders aus als zuvor. Die tiefen Falten in seinem Gesicht sind verschwunden. Sein Gesicht ist wenig ausdrucksstark. Es kommen Gerüchte auf, das Video sei ein Deepfake. Erzeugt von einer KI. Computergeneriert. Medien greifen den Verdacht auf und berichten darüber.

Heute glauben Fachleute, dass das Video echt ist und Ali Bongo einen Schlaganfall hatte. Aber im Januar 2019 ist die Situation in Gabun nach dem monatelangen Verbreiten von Desinformation so aufgeheizt, dass es zu einem Militärputsch kommt. Im staatlichen Fernsehen bezweifeln die Putschisten, dass der Präsident noch selbst handlungs- und entscheidungsfähig ist und beziehen sich dabei auf das merkwürdige Video mit der Neujahrsansprache. Der Putsch scheitert. Ali Bongo Ondimba ist bis heute im Amt.

Auch wenn in Gabun wohl keine KI im Spiel war, das Beispiel verdeutlicht, wie eine Situation durch Desinformation eskalieren kann. Expertinnen und Experten betrachten Desinformation als einen weiteren Prozess, den Künstliche Intelligenz beschleunigen kann. Akteure könnten Deepfake-Videos gezielt einsetzen, um eine Gesellschaft zu destabilisieren. Eine aufgebrachte Bevölkerung könnte einen bewaffneten Konflikt heraufbeschwören.

31. Dezember 2018. Gabuns Präsident Ali Bongo Ondimba veröffentlicht seine Neujahrsansprache. Es ist sein erster öffentlicher Auftritt seit Monaten. Zuletzt gesehen wurde er im Oktober, bei einer Konferenz in Saudi-Arabien. Während der Konferenz ist er aus unbekannten Gründen in ein Krankenhaus eingeliefert worden. Seither kursieren widersprüchliche Angaben über Ali Bongos Gesundheitszustand. Lebt er überhaupt noch? Dann erscheint er plötzlich in der rund zweiminütigen Neujahrsansprache. Doch der Präsident sieht anders aus als zuvor. Die tiefen Falten in seinem Gesicht sind verschwunden. Sein Gesicht ist wenig ausdrucksstark. Es kommen Gerüchte auf, das Video sei ein Deepfake. Erzeugt von einer KI. Computergeneriert. Medien greifen den Verdacht auf und berichten darüber.

Heute glauben Fachleute, dass das Video echt ist und Ali Bongo einen Schlaganfall hatte. Aber im Januar 2019 ist die Situation in Gabun nach dem monatelangen Verbreiten von Desinformation so aufgeheizt, dass es zu einem Militärputsch kommt. Im staatlichen Fernsehen bezweifeln die Putschisten, dass der Präsident noch selbst handlungs- und entscheidungsfähig ist und beziehen sich dabei auf das merkwürdige Video mit der Neujahrsansprache. Der Putsch scheitert. Ali Bongo Ondimba ist bis heute im Amt.

Auch wenn in Gabun wohl keine KI im Spiel war, das Beispiel verdeutlicht, wie eine Situation durch Desinformation eskalieren kann. Expertinnen und Experten betrachten Desinformation als einen weiteren Prozess, den Künstliche Intelligenz beschleunigen kann. Akteure könnten Deepfake-Videos gezielt einsetzen, um eine Gesellschaft zu destabilisieren. Eine aufgebrachte Bevölkerung könnte einen bewaffneten Konflikt heraufbeschwören.

Geostrategische Verschiebungen im Cyberspace

Bei solchen Cyberangriffen könnte KI aber auch Teil der Lösung sein, sagt Mariarosaria Taddeo. „KI hat das Potenzial, unsere Gesellschaft sicherer zu machen, indem sie eine effizientere Verteidigung ermöglicht. Bei Cyberangriffen ist es schwierig, sie mit Gewissheit einem Angreifer zuzuschreiben. Aber das ist notwendig, um eine Antwort zu rechtfertigen. KI kann helfen, die Quelle eines Angriffs auszumachen, vielleicht nicht die Personen, aber die Maschinen hinter einem Angriff. Die können zurückverfolgt und dann ins Visier genommen werden, um den Angreifer zu schwächen.“

Auch im Cyberspace könnte KI zu geostrategischen Verschiebungen führen: „Es eröffnen sich neue Möglichkeiten für diejenigen, die bisher nicht so viel Macht hatten. Vielleicht weil sie keine Atombomben haben oder nicht so eine große Marktmacht wie andere Nationen. KI bietet da einen neuen Hebel. Länder, die viel Geld in die Entwicklung von KI stecken können, viele Daten sammeln und diese Daten uneingeschränkt nutzen können, könnten in Zukunft leider im Vorteil sein. Und ich sage leider, weil Daten uneingeschränkt zu nutzen bedeutet, dass demokratische Werte, Persönlichkeitsrechte und Menschenrechte verletzt werden.“

Eine verwandte Gefahr sieht sie bei der Cyberabwehr. KI ist geeignet, Angriffe frühzeitig zu erkennen. Sie könnte also die Datenverbindungen an kritischen Infrastrukturen auf Auffälligkeiten untersuchen. Künstliche Intelligenz könnte Alarm schlagen, wenn sie etwa in einem deutschen Krankenhausnetzwerk ungewöhnliche Datenströme beobachtet. Aber dazu muss sie Systeme permanent überwachen - und Mariarosaria Taddeo befürchtet, dass dabei auch die Nutzerinnen und Nutzer dieser Systeme überwacht werden.

Auch im Cyberspace könnte KI zu geostrategischen Verschiebungen führen: „Es eröffnen sich neue Möglichkeiten für diejenigen, die bisher nicht so viel Macht hatten. Vielleicht weil sie keine Atombomben haben oder nicht so eine große Marktmacht wie andere Nationen. KI bietet da einen neuen Hebel. Länder, die viel Geld in die Entwicklung von KI stecken können, viele Daten sammeln und diese Daten uneingeschränkt nutzen können, könnten in Zukunft leider im Vorteil sein. Und ich sage leider, weil Daten uneingeschränkt zu nutzen bedeutet, dass demokratische Werte, Persönlichkeitsrechte und Menschenrechte verletzt werden.“

Eine verwandte Gefahr sieht sie bei der Cyberabwehr. KI ist geeignet, Angriffe frühzeitig zu erkennen. Sie könnte also die Datenverbindungen an kritischen Infrastrukturen auf Auffälligkeiten untersuchen. Künstliche Intelligenz könnte Alarm schlagen, wenn sie etwa in einem deutschen Krankenhausnetzwerk ungewöhnliche Datenströme beobachtet. Aber dazu muss sie Systeme permanent überwachen - und Mariarosaria Taddeo befürchtet, dass dabei auch die Nutzerinnen und Nutzer dieser Systeme überwacht werden.

Regulierungsbedarf für den Krieg des 21. Jahrhunderts

Regeln, die festlegen wie Konflikte ausgetragen werden, fehlen im virtuellen Raum genauso wie in der realen Welt. Es mangelt an Gesetzen und Abkommen. Das Völkerrecht lasse sich nicht so einfach auf Cyber-Auseinandersetzungen übertragen, sagt die Expertin. „Wir brauchen eine Regulierung für das Verhalten von Staaten im Cyberspace. Wir müssen überlegen, wie wir sicherstellen können, dass KI angemessen auf einen Angriff reagiert. Wie definieren wir, was ein legitimes Ziel ist? Im virtuellen Raum sind militärische und zivile Ziele nicht so einfach voneinander zu trennen.“

Wenn ein Angriff von einem Computer in einem Rechenzentrum ausgeht, in dem auch zivile Prozesse laufen, darf dann als Antwort auf den Angriff das ganze Rechenzentrum lahmgelegt werden? Solche Fragen sind bisher unbeantwortet.

Dazu, dass der Krieg des 21. Jahrhunderts nicht vollkommen unreguliert bleibt, könnten vielleicht Europäer nennenswert beitragen. Die EU ist zwar nicht führend bei ziviler oder militärischer KI, aber stark in der Regulierung. „Wir stecken vielleicht nicht Millionen in die Entwicklung von Künstlicher Intelligenz, wie private Unternehmen das in den USA und China machen, aber wir diktieren die Regeln.“

Dem Beispiel der Datenschutzgrundverordnung folgend, der nun auch US-amerikanische Internetdienste entsprechen müssen, könnte die EU auch bei KI die Spielregeln festlegen. Dabei muss der starke Datenschutz europäischer Künstlicher Intelligenz nicht unbedingt im Weg stehen, obwohl KI nur mit einer großen Menge an Daten funktioniert, sagt Ulrike Franke. „Ich würde tatsächlich sagen, dass ethische KI im Zweifel auch ein Standortvorteil für Europa werden kann.“

Wenn ein Angriff von einem Computer in einem Rechenzentrum ausgeht, in dem auch zivile Prozesse laufen, darf dann als Antwort auf den Angriff das ganze Rechenzentrum lahmgelegt werden? Solche Fragen sind bisher unbeantwortet.

Dazu, dass der Krieg des 21. Jahrhunderts nicht vollkommen unreguliert bleibt, könnten vielleicht Europäer nennenswert beitragen. Die EU ist zwar nicht führend bei ziviler oder militärischer KI, aber stark in der Regulierung. „Wir stecken vielleicht nicht Millionen in die Entwicklung von Künstlicher Intelligenz, wie private Unternehmen das in den USA und China machen, aber wir diktieren die Regeln.“

Dem Beispiel der Datenschutzgrundverordnung folgend, der nun auch US-amerikanische Internetdienste entsprechen müssen, könnte die EU auch bei KI die Spielregeln festlegen. Dabei muss der starke Datenschutz europäischer Künstlicher Intelligenz nicht unbedingt im Weg stehen, obwohl KI nur mit einer großen Menge an Daten funktioniert, sagt Ulrike Franke. „Ich würde tatsächlich sagen, dass ethische KI im Zweifel auch ein Standortvorteil für Europa werden kann.“

EU sucht koordinierte Strategie

In den USA wird viel davon gesprochen, dass militärische KI gemeinsam mit den richtigen Verbündeten entwickelt werden müsse, um bestimmte Standards durchzusetzen und eine Dominanz ethisch zweifelhafter KI zu verhindern. Ulrike Franke stimmt zu, dass…

„… mit Technologien auch zunehmend eben Werte und Ideen und Ideologien zum gewissen Grade transportiert werden. Und deswegen setzt sich auch die EU zunehmend damit auseinander, was man denn in anderen Ländern verkaufen will und was man den anderen Ländern anbieten kann, wenn man mit ihnen zusammenarbeitet im Bereich der Technologien. Und dass man denen klar macht, wenn ihr mit uns zusammenarbeitet und unsere Technologie kauft, dann kriegt ihr Folgendes; und wenn ihr von den anderen Systeme kauft, dann habt ihr einen ganz anderen Ansatz. Das ist gerade ein Riesenthema, diese ganzen Normen und Standards und wie man das am besten macht.“

Die USA, zumindest deren Nationale KI-Sicherheitskommission, will starke KI aus dem Westen. Doch selbst unter den traditionellen Verbündeten gehen die Meinungen darüber auseinander, was KI können soll und was nicht, wo die Grenzen eines legitimen Einsatzes liegen. Was es beispielsweise genau heißen soll, einen „human in the loop“ zu haben, einen Menschen, der in die Handlungen eines KI-Systems eingreifen kann, Für Ulrike Franke wäre es ein guter Anfang, wenn die EU-Kommission Mitgliedsstaaten auffordern würde, jeweils eine militärische KI-Strategie zu entwickeln. Dann könnte eine EU-weite Kommission ins Leben gerufen werden, die, nach amerikanischem Vorbild, die wesentlichen Fragen beantwortet.

„Was ist unser direktes Interesse hier? Was sind die Systeme, die wir brauchen? Was sind die Systeme, die wir ablehnen? Was sind Bereiche, wo wir uns auch international stärker engagieren wollen, zum Beispiel im Rüstungskontroll-Bereich, all sowas.“

Ulrike Franke schlägt vor, ein europäisches Forschungsinstitut für geopolitische und Sicherheits-Aspekte von KI aufzubauen. Denn Künstliche Intelligenz hat das Potenzial, die Welt neu zu ordnen. Neue reale und virtuelle Schlachtfelder, neue Angriffs- und Verteidigungsmethoden, neue Allianzen. Wie bei alldem sichergestellt werden kann, dass die positiven Effekte von KI überwiegen, muss im Militär wohl noch dringlicher beantwortet werden als im zivilen Sektor.

„… mit Technologien auch zunehmend eben Werte und Ideen und Ideologien zum gewissen Grade transportiert werden. Und deswegen setzt sich auch die EU zunehmend damit auseinander, was man denn in anderen Ländern verkaufen will und was man den anderen Ländern anbieten kann, wenn man mit ihnen zusammenarbeitet im Bereich der Technologien. Und dass man denen klar macht, wenn ihr mit uns zusammenarbeitet und unsere Technologie kauft, dann kriegt ihr Folgendes; und wenn ihr von den anderen Systeme kauft, dann habt ihr einen ganz anderen Ansatz. Das ist gerade ein Riesenthema, diese ganzen Normen und Standards und wie man das am besten macht.“

Die USA, zumindest deren Nationale KI-Sicherheitskommission, will starke KI aus dem Westen. Doch selbst unter den traditionellen Verbündeten gehen die Meinungen darüber auseinander, was KI können soll und was nicht, wo die Grenzen eines legitimen Einsatzes liegen. Was es beispielsweise genau heißen soll, einen „human in the loop“ zu haben, einen Menschen, der in die Handlungen eines KI-Systems eingreifen kann, Für Ulrike Franke wäre es ein guter Anfang, wenn die EU-Kommission Mitgliedsstaaten auffordern würde, jeweils eine militärische KI-Strategie zu entwickeln. Dann könnte eine EU-weite Kommission ins Leben gerufen werden, die, nach amerikanischem Vorbild, die wesentlichen Fragen beantwortet.

„Was ist unser direktes Interesse hier? Was sind die Systeme, die wir brauchen? Was sind die Systeme, die wir ablehnen? Was sind Bereiche, wo wir uns auch international stärker engagieren wollen, zum Beispiel im Rüstungskontroll-Bereich, all sowas.“

Ulrike Franke schlägt vor, ein europäisches Forschungsinstitut für geopolitische und Sicherheits-Aspekte von KI aufzubauen. Denn Künstliche Intelligenz hat das Potenzial, die Welt neu zu ordnen. Neue reale und virtuelle Schlachtfelder, neue Angriffs- und Verteidigungsmethoden, neue Allianzen. Wie bei alldem sichergestellt werden kann, dass die positiven Effekte von KI überwiegen, muss im Militär wohl noch dringlicher beantwortet werden als im zivilen Sektor.