Künstliche Intelligenz (KI) wird auch beim Militär eingesetzt. Die neuen Technologien werden von Armeen unter anderem genutzt, um die Aufklärung über das Vorgehen des militärischen Gegners zu verbessern. Doch es gibt in der Debatte um eine militärische Nutzung auch Kritik an "Killerrobotern" - und dies schon seit Jahren.

Wie könnte KI den Krieg verändern?

Künstliche Intelligenz kann Militärs dabei helfen, Entscheidungen zu treffen – beispielsweise, indem die KI Informationen sammelt und auswertet.

„Militärs haben nie genug Informationen, um eine Entscheidung zu treffen“, sagt Patrick Bolder, Ex-Soldat und Analyst beim The Hague Center for Strategic Studies, einem Thinktank. „Es gibt immer mehr Sensoren, die das gesamte Schlachtfeld überwachen, nicht nur am Boden, sondern auch auf dem Wasser, unter Wasser, in der Luft, im Weltraum und im Cyberspace. Und all diese Informationen führen zu einem bestimmten Bild, dem Lagebewusstsein. Aber über all diese Sensoren kommen so viele Informationen herein, dass es fast unmöglich ist, sie als Mensch zu erfassen. Man braucht also eine automatische Verarbeitung.“

KI-Waffensysteme werten Informationen aus

Künstliche Intelligenz begreift so Zusammenhänge, die für Menschen nur schwer sichtbar sind. Registrieren beispielsweise Militär-Satelliten, Sensoren am Meeresboden oder Kameras an Land ungewöhnliche Bewegungen und schicken die Informationen an eine KI, kann diese anhand der Daten feindliche Aktivitäten erkennen und vor einem Angriff warnen.

Analysten wie Bolder gehen davon aus, dass der Markt für militärische KI-Anwendungen in den kommenden fünf Jahren rasant wachsen wird. Ein Trend, der schon jetzt Auswirkungen auf die militärische Praxis hat.

Wo und warum wird KI bereits beim Militär eingesetzt?

Nach dem Hamas-Terrorangriff auf Israel wurde Kritik an den durch KI gestützten Verteidigungssystemen Israels laut. Im Mai 2023 hatte Eyal Zamir, ein führender israelischer Militärvertreter, gesagt, das Land stehe kurz davor, eine KI „Supermacht“ zu werden. Am 7. Oktober 2023 wurden Israels Sicherheitskräfte dennoch von der Hamas-Terrorattacke überrascht.

Außerdem werden viele KI-Instrumente wahrscheinlich schon in der Ukraine eingesetzt. In Kriegszeiten ist das ukrainische Militär froh über jeden Vorteil gegenüber Russland. Der aktuelle Krieg in der Ukraine gilt somit als eine Art "Labor" für die Erprobung der Integration von KI in bestehende Plattformen, aber auch für neue Arten von Technologien.

Unternehmen liefern etwa Software, die Militärs helfen soll, im richtigen Moment die richtige Entscheidung zu treffen. Eine Art KI-General, der das Schlachtfeld und den Informationsfluss im Blick behält: Taucht ein Feind auf, schlägt die KI Alarm, weiß, welche eigenen Einheiten sich zur Verteidigung eignen, und berechnet die schnellste Route zum Feind. Den Befehl zum militärischen Handeln aber trifft weiter der Mensch.

„Guardion – Countering Drones“ heißt ein System, das zum Beispiel bei politischen Gipfeltreffen eingesetzt wird, um Angriffe oder Spionage durch Drohnen zu verhindern. Ein Van ist bestückt mit Kameras, Radar-Technologie und anderen Sensoren, die kontinuierlich den Luftraum überwachen. Die gesammelten Daten werden mithilfe von KI in sekundenschnell ausgewertet.

Im Van befinden sich Stühle, zahlreiche Bildschirme und Computer. Auf den Rechnern läuft ein KI-System, das unter anderem auf große Entfernung Drohnen von Vögeln unterscheiden kann.

Sichert die Polizei beispielsweise einen G-7-Gipfel mit dem System, haben die Beamten je nach Ausstattung verschiedene Optionen: Sie können die Funkverbindung des Drohnenpiloten stören, die Steuerung der Drohne selbst übernehmen, sie mit einem Netz einfangen oder sie sogar abschießen.

KI bei der Bundeswehr

Die Bundeswehr nutzt die Technologie beispielsweise für den Schutz ihrer Feldlager im Ausland. Mit dem Überwachungssystem kann das Militär verhindern, dass feindliche Drohnen Bundeswehr-Lager auskundschaften oder angreifen.

Welche Risiken bringen KI-Waffensysteme beim Militär mit sich?

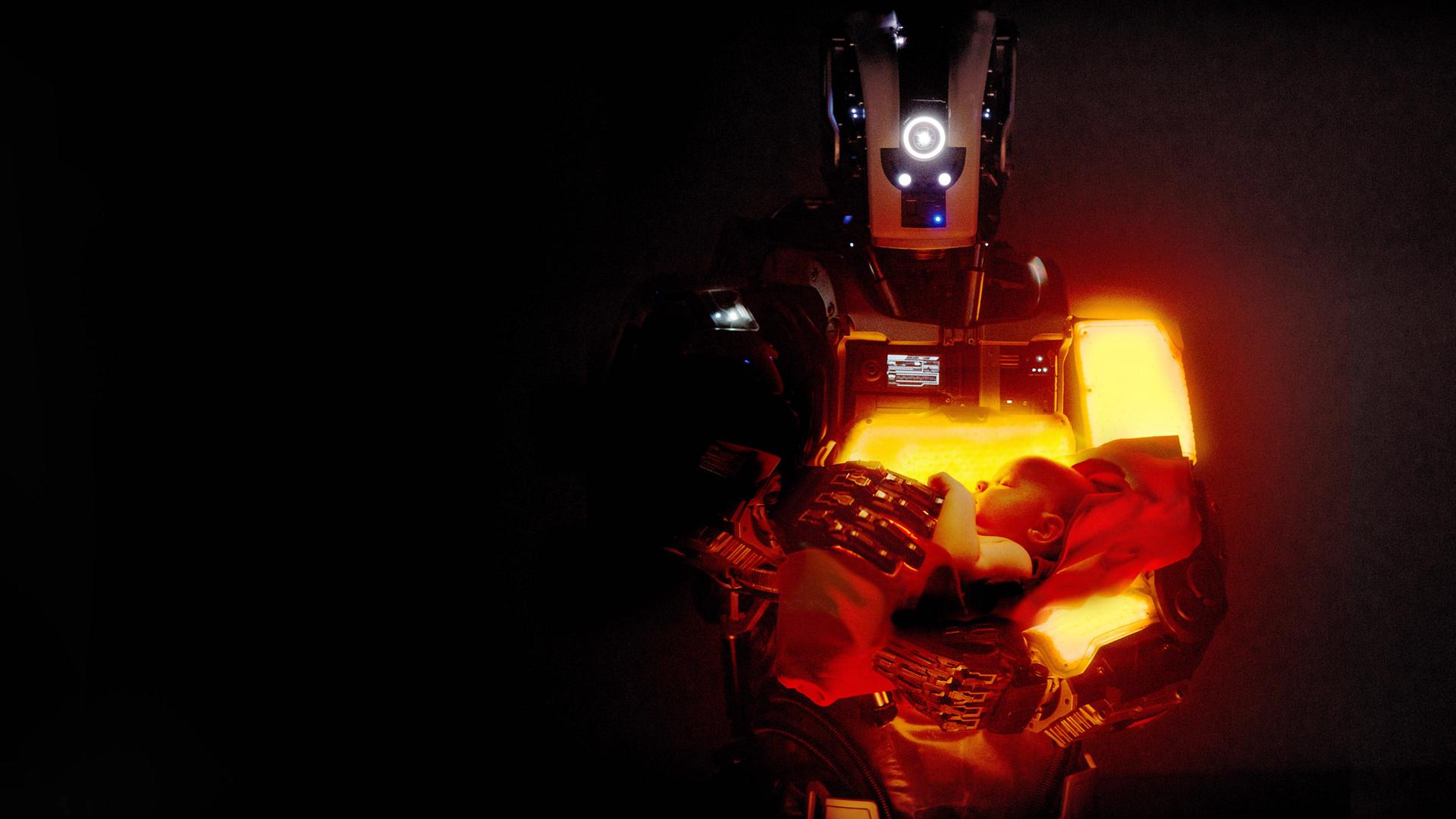

Groß ist die Angst vor „Killerrobotern“: Roboterarmeen, die ohne moralische Skrupel töten, der menschlichen Kontrolle entzogen. Befürchtet werden auch Online-Leaks bei gefährlichen KI-Waffensystemen, durch die Informationen in falsche Hände geraten könnten.

Expertinnen und Experten mögen den Begriff „Killerroboter“ allerdings nicht. Auch der Begriff „Militärroboter“ greift für viele zu kurz. Sie sprechen in der Regel lieber von LAWS. Die Abkürzung kommt aus dem Englischen und steht für „Lethal Autonomous Weapon Systems“, also tödliche autonome Waffensysteme.

Bei LAWS handelt es sich bisher weniger um humanoide Roboter, wie sie oft in Science-Fiction-Filmen zu sehen sind. Viel öfter sind Drohnen in der Luft und unter Wasser im Kriegseinsatz, auf dem Land schlagen sich Roboter auf Rollen oder Ketten in der Regel besser als Maschinen mit Beinen.

Es gibt auch ganz einfache praktische Probleme mit KI-gestützten Waffen. Harald Schaub ist Professor für Psychologie an der Otto-Friedrich-Universität in Bamberg und ist beim Sicherheitsunternehmen IABG für das Thema Mensch-System-Schnittstelle zuständig. Er warnt vor Produkten, die an den Nutzerinnen und Nutzern vorbei entwickelt werden. Denn es würden zunehmend komplexe, teil oder voll automatisierte Systeme gebaut, die viele weder verstehen noch nachvollziehen können. Soldatinnen und Soldaten müssten deswegen geschult werden, um die Fähigkeiten der KI-Helfer richtig einzuschätzen.

Wie können KI und autonome Waffen beim Militär reglementiert werden?

Nichtregierungsorganisationen drängen auf ein Verbot von vollautonomen Waffensystemen. Viele Regierungen wollen zumindest eine Regulierung. Doch seit Jahren kommt es zu keiner Einigung. UN-Generalsekretär António Guterres rief gemeinsam mit der Präsidentin des Internationalen Roten Kreuzes, Mirjana Spoljaric Egger, die Staaten dazu auf, sich bis 2026 auf Verbote und Beschränkungen festzulegen.

Regeln für Kampfroboter im Krieg

Aktuell wird dazu bei den Vereinten Nationen in New York eine Resolution verhandelt, bis Anfang November 2023 soll sie vorliegen. Ob das gelingt und wie sie aussehen wird, ist allerdings offen. Das liegt auch am Verhandlungsgegenstand. Denn die Debatte um autonome Waffensysteme ist sehr komplex und viele Fragen sind noch überhaupt nicht geklärt. Gefordert wird zum Beispiel eine Klärung aller rechtlichen Rahmenbedingungen, bevor Algorithmen und smarte Maschinen ein fester Bestandteil von Kriegsführung werden.

Der frühere US-Generalstabschef Mark Milley betonte, dass Menschen weiterhin die letzte Entscheidung über den Einsatz von KI-gestützten Waffensystemen treffen müssten. Er forderte andere Armeen auf, dem nachzukommen.

Nutzung von KI beim Militär nimmt zu

Gleichzeitig hat jedoch ein globales Wettrüsten begonnen. 2019 belief sich der Markt für Militärroboter laut dem Marktforschungsunternehmen „Fortune Business Insights“ weltweit auf knapp 14 Milliarden US-Dollar. 2027 werden Hersteller Schätzungen zufolge rund 25 Milliarden US-Dollar mit dem modernen Kriegsgerät umsetzen.

Marten Hahn, Anna Loll, tei