Künstliche Intelligenz, das klingt groß. Was aber ist das, womit wir uns hier im Kern beschäftigen? Große Sprachmodelle, Learning Language Models, sind Werkzeuge, die enormes Potenzial bieten: Das, was wir Sprache nennen, wird erst in seine logischen Einzelteile, sogenannte Tokens, zerlegt, logische Zusammenhänge erlernt und dann von Computern neu zusammengesetzt, wenn eine entsprechende Anfrage hereinkommt. Ähnlich funktioniert es auch mit Bild-Generatoren: Information wird kodiert und mithilfe automatisierter Interpretation neu zusammengefügt.

Im Kern ist das eng verwandt mit dem, was wir Menschen machen: Wir verarbeiten Eindrücke, speichern, kontextualisieren sie neu, wenden unser Wissen an. Genau das zu automatisieren und aus diesem Wissen nahezu in Echtzeit Neues zu generieren, das ist das Versprechen, das die sogenannte Künstliche Intelligenz mit sich bringt.

Beeindruckend und nützlich im Alltag

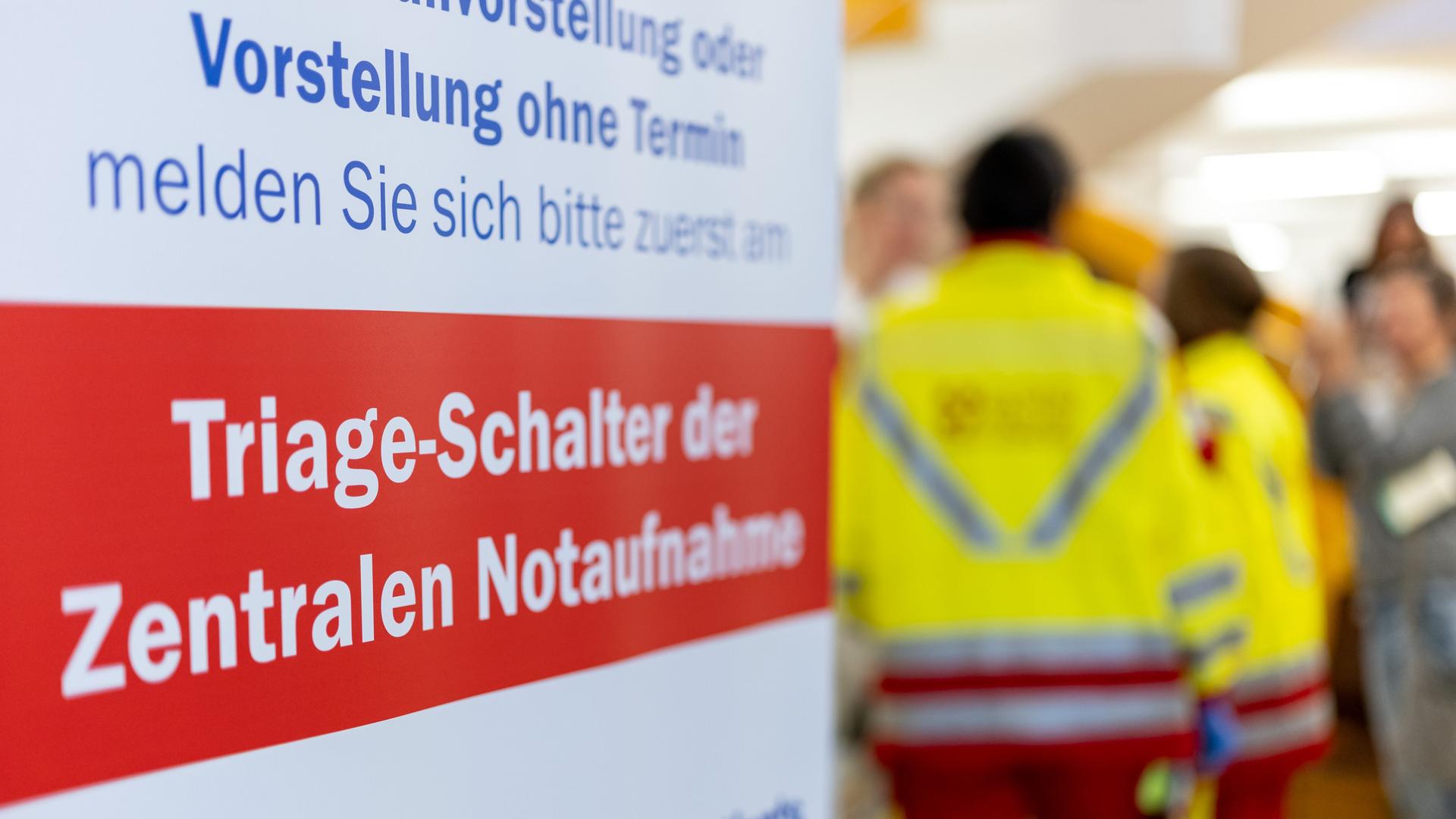

Die Hoffnungen sind also groß. Die Anwendung von derartigen Modellen verspricht enorme Effizienzgewinne. Ist es nicht wunderbar, wenn wir mit einem kurzen Kommando etwa Bilder generieren lassen können? Spracherkennung, Übersetzung, Bildauswertung, Bildgenerierung, Sprachsynthese – all das ist für den Alltag toll und nützlich, etwa wenn es um Live-Übersetzungen geht. Und ist es nicht wunderbar, wenn wir viele banale Aufgaben an automatisierte Systeme delegieren können?

Ja, das ist eine eindrucksvolle Leistung. Das Problem beginnt aber mit einem grundsätzlichen Missverständnis: dass Technologie neutral sei, weil sie am Ende gar nicht weiß, was sie tut. So wie Menschen von ihren sozialen Erfahrungen, durch Bildung, aber auch durch höchst individuelle Wahrnehmungen und Präferenzen geprägt werden, so werden KI-Modelle durch das geprägt, was sie kennenlernen – sprich: was wir ihnen als Grundlage mitgeben.

KI kann keine Verantwortung übernehmen

Was wir jetzt bei der Entwicklung sogenannter Künstlicher Intelligenz sehen, ist nur der Anfang, und schon jetzt zeigen sich massive Probleme: Welche Daten wurden den Modellen zur Verfügung gestellt? Wie werden diese gespeichert und verarbeitet? KI-Modelle sind limitiert auf ihre Algorithmen und das, was man ihnen als Datengrundlage beigebracht hat. Sie lernen anhand dessen, was sie kennen, ohne tatsächlich einschätzen zu können, was diese jeweiligen Inhalte bedeuten. Auch deshalb werden sie derzeit auf die Menschheit losgelassen: Aus den Nutzungsdaten der Interaktion mit echten Menschen können Rückschlüsse gezogen werden. Wir Menschen trainieren derzeit die Systeme – übrigens auch mit all unseren Fehlern.

Gerade Allzweck-KI-Systeme sind automatisch problematisch. „Ein Sprachmodell kann autonom funktionieren, aber es kann keine Verantwortung übernehmen. Es kann Entscheidungen treffen, aber es ist nicht in der Lage, die Konsequenzen seiner Entscheidungen zu verstehen oder zu tragen“, meint etwa der auf GPT4 basierende Bing-Chatbot.

Die Entwickler müssten ihnen also beibringen, was im jeweiligen Kontext verantwortliches Handeln ist. Wenn ein Modell das aber nicht kann, ist es nicht marktreif und gehört auch nicht in die freie Wildbahn, so faszinierend es auch sein mag.

Auch KI muss sich an Recht halten

So ist es nur naheliegend, dass etwa Datenschutzbehörden auf der ganzen Welt ihre Zweifel daran haben, dass die Anbieter ihren heute bereits existierenden Pflichten nachkommen. Die Anbieter haben bis heute nicht öffentlich erklären können, wie genau sie ihren Modellen die Anforderungen des Rechts beibringen können. Das aber ist die Voraussetzung für das Inverkehrbringen und Nutzen von Software, und es gibt auch keine Ausnahmeregelungen für besonders faszinierende neue Technologie.

Es ist gut, dass nicht nur die italienische Datenschutzaufsichtsbehörde das so sieht, sondern auch die kanadische. Andere wie die französische prüfen bereits ebenfalls, und auf EU-Ebene wird seit zwei Jahren darüber verhandelt, welchen Regeln KI unterworfen sein soll. Mit der sogenannten KI-Verordnung sollen Anbieterpflichten spezifisch reguliert werden. Hier war die EU tatsächlich einmal weit vorne mit ihren Ideen: So kompliziert die Einhegung von ChatGPT, Midjourney, Dall-E, Stable Diffusion, Neeva, Luminous, Bard oder Jasper ist, so dringlich ist es, hier klare Regeln für ihren Einsatz vorzuschreiben.

Mittlerweile hat die Realität die EU eingeholt – und es wäre höchste Zeit, an diese Entwicklung angepasste Regeln auch zu beschließen.